阿里云开源通义千问视觉语言模型Qwen-VL 具备多模态信息理解能力

站长网2023-08-26 17:01:230阅

阿里云旗下魔搭社区(ModelScope)宣布开源视觉语言模型Qwen-VL。

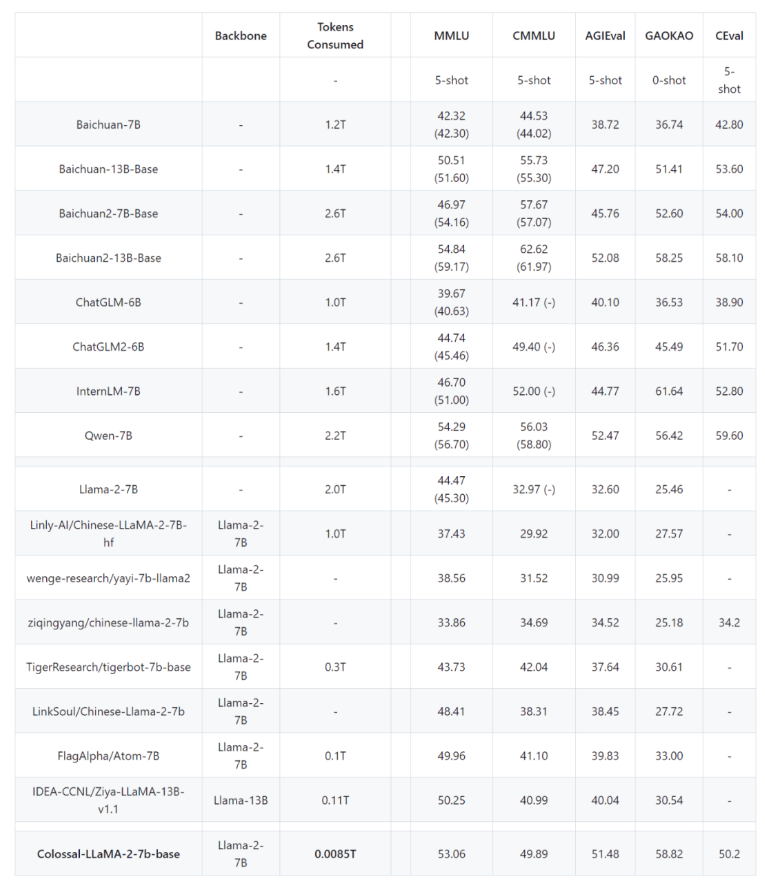

据介绍,Qwen-VL以通义千问70亿参数模型Qwen-7B为基座语言模型研发,支持图文输入,具备多模态信息理解能力。

相比之前的模型,Qwen-VL 新增了视觉定位、图像中文字理解等功能,可以接受图像和多语言文本作为输入,并输出图像或文本。

目前,该模型在魔搭社区上线,开源了 Qwen-VL 和 Qwen-VL-Chat 两个模型。

Qwen-VL-Chat 可以用于快速搭建具备多模态能力的对话应用。用户可以通过安装依赖项和模型推理的步骤来使用该模型。模型还支持微调和微调后推理,通过微调可以改进模型的性能。该模型的推理速度快,资源消耗相对较低。

Qwen-VL-Chat

模型链接:https://modelscope.cn/models/qwen/Qwen-VL-Chat

Qwen-VL

模型链接:https://modelscope.cn/models/qwen/Qwen-VL

0000

评论列表

共(0)条相关推荐

- 0000

- 0000

- 0000

- 0000

- 0000