文生图模型升级!DreamDistribution:基于少量参照图片无限生成多样个性化图片

**划重点:**

- 🚀 **全新方法:** 南加州大学、哈佛大学等团队推出DreamDistribution,一种基于提示学习的生成模型,可通过极少数量的参照图片生成高度多样且个性化的图像。

- 🖼️ **多领域应用:** 该方法不仅适用于文本生成图像,还可扩展到3D生成,实现更广泛的个性化生成任务。

- 📊 **评估结果:** DreamDistribution在自动和人工评估中均取得卓越成绩,相较于传统方法,生成图像更具多样性和质量。

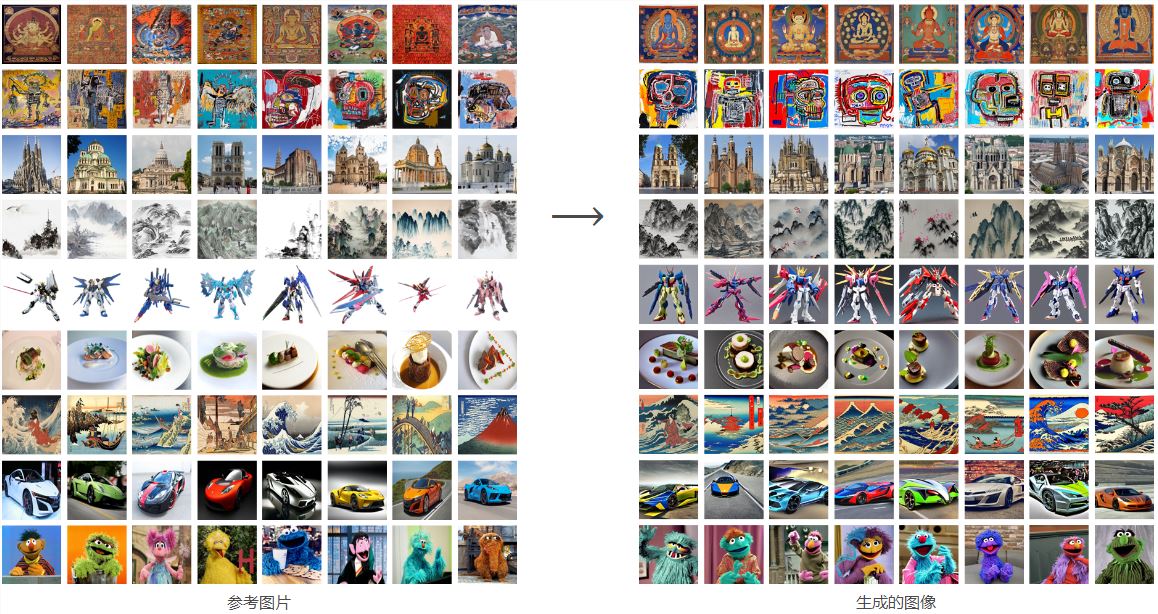

来自南加州大学、哈佛大学等机构的研究团队最近提出了一项创新性的生成模型方法,名为DreamDistribution。这一方法基于提示学习,能够通过仅有的几张参照图片学习文本提示分布,从而实现高度多样化和个性化的图像生成。

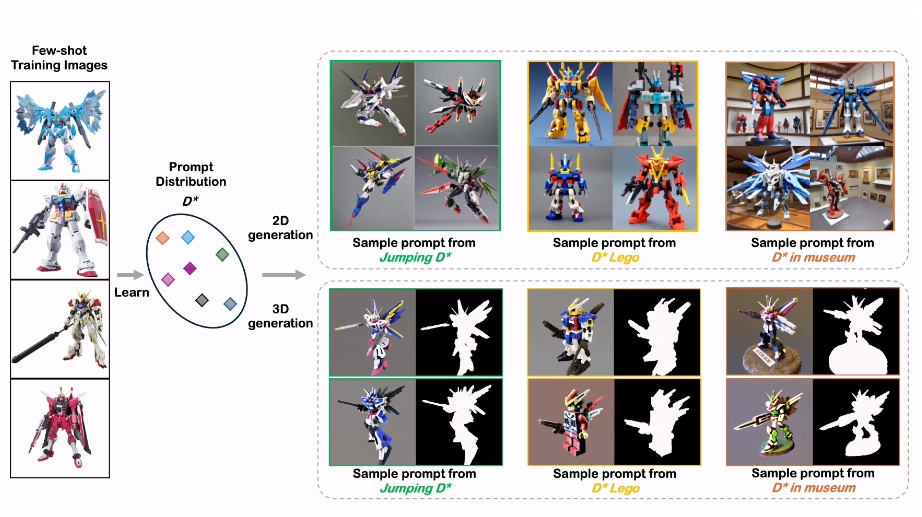

DreamDistribution找到参考图像的提示分布,然后可用于生成新的2D/3D 实例,能够进行文本引导编辑等。

DreamDistribution的独特之处在于它不仅适用于文本生成图像,还能在3D生成领域发挥作用。通过学习文本提示分布,该方法可以生成具有极大多样性的图像,保留参照图片的视觉属性,同时注入新颖的变化。

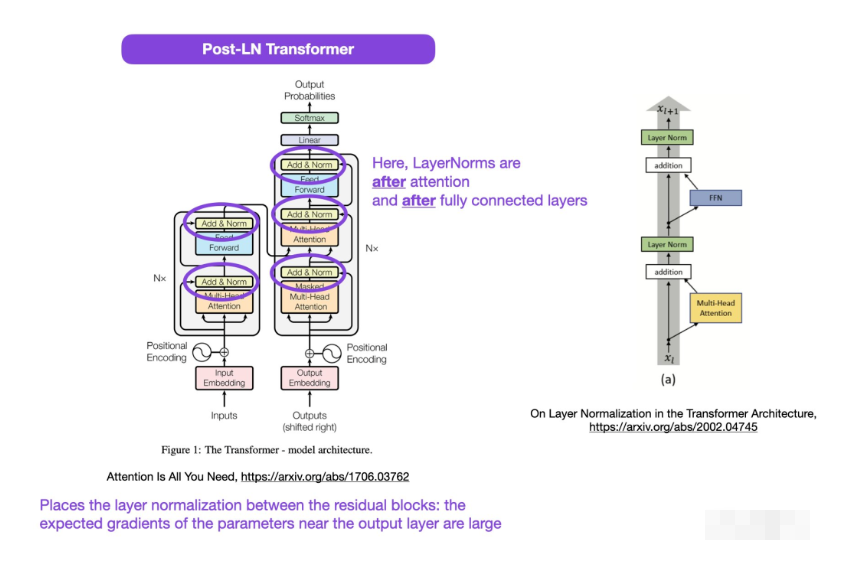

方法通过在语义空间内使用提示的语义特征拟合一个提示的高斯分布,以此来实现对生成图像的控制。正交损失项确保不同提示在语义空间中的特征差异,使生成更多样性。此外,方法还支持通过文本引导进行提示编辑,进一步增强了生成图像的个性化。

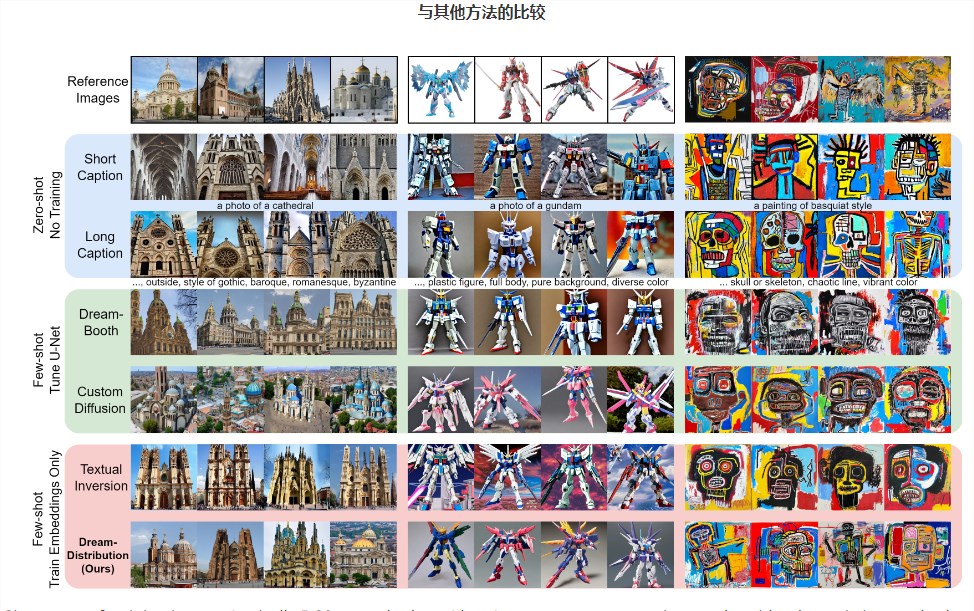

给定一组训练图像(通常为5-20张,在这里只显示4张),将生成结果与其他现有方法进行比较。我们对所有方法都使用 Stable Diffusion2.1版。从底行可以看出,这种的方法能够生成更多样化和连贯的图像。

在评估方面,DreamDistribution在自动评估和人工评估中均表现出色。使用流行的指标进行评估,如FID、CLIP-I和DINO等,结果显示该方法生成的图像在质量上明显优于基线方法。人工评估也证实了DreamDistribution生成图像的多样性和个性化程度相较于其他方法更高。

该方法不仅在生成图像的质量和多样性方面取得成功,而且展示了在更广泛生成任务中的应用潜力。研究人员使用MVDream作为3D生成模型,成功地将DreamDistribution的方法应用于3D生成任务,进一步证实了其适用性和灵活性。

然而,研究人员也指出一些不足之处,例如生成效果高度依赖于训练图片的质量和多样性,并且在3D生成上仍有提升的空间。这一工作为生成模型领域注入了新的思路,强调了在更高层面上实现个性化生成的重要性,为未来的研究提供了有益的启示。

DreamDistribution 主要特色功能总结如下:

Prompt 分发学习:DreamDistribution 通过学习软提示的分发,使预训练的文本到图像扩散模型能够生成新的2D/3D实例。这些软提示可以从学到的分发中进行采样,从而实现文本引导的编辑和更多功能。

个性化定制:该项目专注于在更抽象的概念或类别水平上个性化文本到图像扩散模型,从一组参考图像中调整共性,并创建具有足够变化的新实例。这使得生成的图像具有多样性,同时保持与参考图像的关联性。

多任务适应性:学到的提示分发不仅可以用于文本到2D图像的生成,还展示了在其他任务上的适应性,如文本到3D的生成。

文本引导编辑:该方法支持文本引导的编辑功能,用户可以通过调整提示来控制生成图像的变化和混合。这增加了用户对生成过程的灵活性。

应用于文本到3D生成:** 通过学习提示分发,可以应用于文本到3D生成,并支持文本引导的编辑,提供更多维度的图像生成能力。

论文地址:https://arxiv.org/abs/2312.14216

项目网址:https://briannlongzhao.github.io/DreamDistribution/

- 0004

- 0000

- 0000

- 0000

- 0001