浙大研究者提出UrbanGIRAFFE,解决城市场景的可控3D感知图像合成

**划重点:**

1. 🌐 UrbanGIRAFFE是浙江大学研究人员提出的一种用于逼真图像合成的方法,旨在实现可控的相机姿势和场景内容。

2. 🖼️ 该方法通过将场景分解为物体、物体和天空,利用语义体素网格和对象布局,实现对复杂城市环境的多样控制。

3. 🚀 UrbanGIRAFFE通过在合成和实际数据集上进行全面评估,展示了在可控性和保真度方面超越各种2D和3D基线的出色性能。

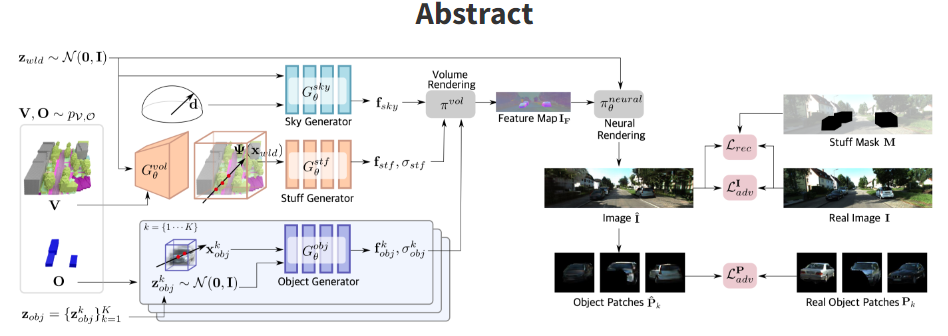

浙江大学的研究人员最近提出了一种名为UrbanGIRAFFE的创新方法,用于解决具有挑战性的城市场景的可控3D感知图像合成问题。该方法通过引入可控的相机姿势和场景内容,以实现逼真的图像合成,特别是在处理具有挑战性的城市环境时。

UrbanGIRAFFE采用了一种组合和可控的策略,利用了粗糙的3D全景先验,包括无法计数的物体和可计数的对象的布局分布。该方法将场景分解为物体、物体和天空,从而实现对场景的多样控制,如大范围相机移动、物体编辑和物体操作。

在过去的条件图像合成方法中,以生成逼真图像为目标的方法已取得了显著进展,特别是那些利用生成对抗网络(GANs)的方法。然而,现有方法主要限于以对象为中心的场景,并且在处理复杂且不对齐的城市场景时存在局限性。UrbanGIRAFFE则专注于城市场景,通过引入3D感知的生成模型,克服了这些限制,为大范围相机移动、物体编辑和物体操作提供了多样的可控性。

UrbanGIRAFFE的创新之处在于将城市场景巧妙地分解为无法计数的物体、可计数的对象和天空,利用先验分布来理清复杂的城市环境。该模型包括一个条件物体生成器,利用语义体素网格作为物体先验,以集成粗糙的语义和几何信息。通过在混乱的场景中学习对象生成器的对象布局先验,模型在对抗性和重构损失的端到端训练中得以优化,利用射线-体素和射线-盒交叉策略来优化采样位置,减少所需采样点的数量。

在全面的评估中,UrbanGIRAFFE方法在合成和真实数据集上超越了各种2D和3D基线,展示了出色的可控性和保真度。在KITTI-360数据集上进行的定性评估显示,UrbanGIRAFFE在背景建模方面优于GIRAFFE,实现了增强的物体编辑和相机视角控制。在KITTI-360上进行的剖析研究证实了UrbanGIRAFFE的架构组件的有效性,包括重构损失、对象判别器和创新的对象建模。在推断期间采用移动平均模型进一步提高了生成图像的质量。

UrbanGIRAFFE的未来工作包括引入语义体素生成器,以进行新颖场景采样,并通过光-环境颜色解缠来探索光照控制。文章强调了重构损失的重要性,以保持保真度并产生多样的结果,尤其是对于不经常遇到的语义类别。

该研究展示了UrbanGIRAFFE在处理具有挑战性的城市场景的可控3D感知图像合成问题方面的卓越成就,实现了在相机视角操作、语义布局和物体交互方面的卓越多功能性。通过利用3D全景先验,该模型有效地将场景分解为物体、物体和天空,促进了组合生成建模。未来的研究方向包括整合语义体素生成器以进行新颖场景采样,并通过光-环境颜色解缠来探索光照控制。 UrbanGIRAFFE通过在合成和实际数据集上进行全面评估,展示了在可控性和保真度方面超越各种2D和3D基线的出色性能。

项目网址:https://github.com/freemty/urbanGIRAFFE

https://lv3d.github.io/urbanGIRAFFE/

论文:https://arxiv.org/abs/2303.14167

- 0006

- 0000

- 0000

- 0000

- 0000