LongLoRA:提升LLM上下文能力的创新微调方法

要点:

1. LongLoRA是一种创新的微调方法,可以显著增强大语言模型的上下文处理能力,而无需消耗大量算力资源。

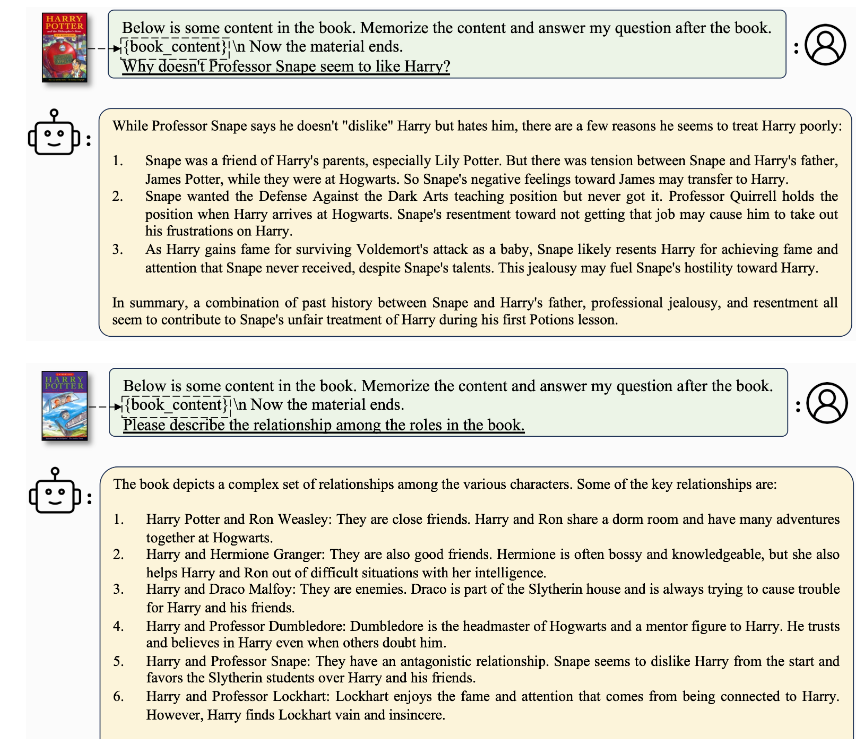

2. LongLoRA采用了两大步骤的高效微调方法,包括使用转变短注意力(S2-Attn)和有效扩大上下文的技巧,可以在不同任务上取得出色的结果。

3. LongLoRA展示了大型语言模型在处理更多信息时能力的提升,尤其擅长处理长文本和长对话中的特定主题,为处理复杂任务提供了新的可能性。

LongLoRA是一种全新的微调方法,旨在提高大语言模型(LLM)的上下文处理能力,而无需过多的算力资源。传统上,增加LLM的上下文处理能力需要大量的算力支持,但LongLoRA采用了创新的方法,使LLM能够处理更长的文本和更多的信息。这种方法的核心是采用了两大步骤的高效微调方法。首先,它使用了一种称为转变短注意力(S2-Attn)的新型注意力形式,该方法能够在训练过程中节省计算能力,同时保持了高效性。其次,LongLoRA重新挖掘了一种名为LoRA的方法,用于有效扩大训练信息的上下文。这个方法在与可训练的嵌入和规范化一起使用时非常有效。

开源地址:https://github.com/dvlab-research/LongLoRA

论文地址:https://arxiv.org/abs/2309.12307

LongLoRA的优势在于它能够在各种任务上取得出色的结果,并且可以与不同大小的LLM一起使用。它可以将用于训练的数据量从4k增加到100k,对于另一个模型,可以增加到32k,而所有这些都可以在一台强大的计算机上完成,与其他技术兼容性良好,不会改变原始模型设计架构。

研究还发现,随着上下文大小的增加,模型的性能更好,这证明了LongLoRA微调方法的有效性。使用更多信息进行训练可以带来更好的结果,例如,一个模型的困惑度性能从2.72降低到2.50,当上下文窗口从8192增加到32768时。此外,LongLoRA还在处理长对话中找到特定主题方面表现出色,与竞争对手相比,它更有效地适应开源数据。

LongLoRA提出了一种创新方法,使大型语言模型能够更轻松、更高效地处理大量信息,而无需消耗大量算力资源。它在处理长文本和复杂任务方面表现出色,为语言模型领域带来了新的可能性。

- 0000

- 0003

- 0000

- 0000

- 0000