AI大模型突围战

最近,GPT赛道上争议不断,先是GPT-4的问世,用一些亮眼的功能让人类感叹自己是不是要丢工作?紧接着又有一封联名信刷屏,图灵奖得主、AI三巨头之一的约书亚·本吉奥、埃隆·马斯克等123个业界大佬,呼吁所有人工智能实验室应暂停比GPT-4更强大的AI系统训练。

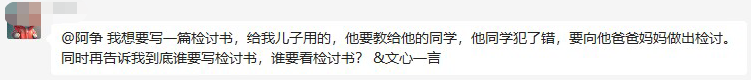

大语言模型的安全问题已经显现,ChatGPT被国内厂商直接应用并不现实,国内科技公司迎来了超车机会,就像一直耕耘网络安全的周鸿祎强调的那样——不发展才是最大的不安全。

所以,当人工智能领域的技术革命再次发生时,我们要做的不是“因噎废食”,而是努力储备、赶上这一班车并且找机会超越,这也是国内科技企业在AI大模型竞争上“全员加速中”的原因。

技术革命已经发生,重要的是储备力量

在大模型的应用上,OpenAI已经完成了从0到1的突破,而互联网行业有一个特点,就是但凡有一人捅破窗户纸,那么就是千军万马独木桥,方向正确了大家就都能努力赶上。

国外科技巨头中,微软宣布将GPT-4、DALL-E等,全都整合在旗下的Bing搜索、office办公套件、Teams聊天产品中;Adobe在老本行图片处理上推出生成式AI Firefly生成图像;谷歌也开放了聊天式机器人Bard……

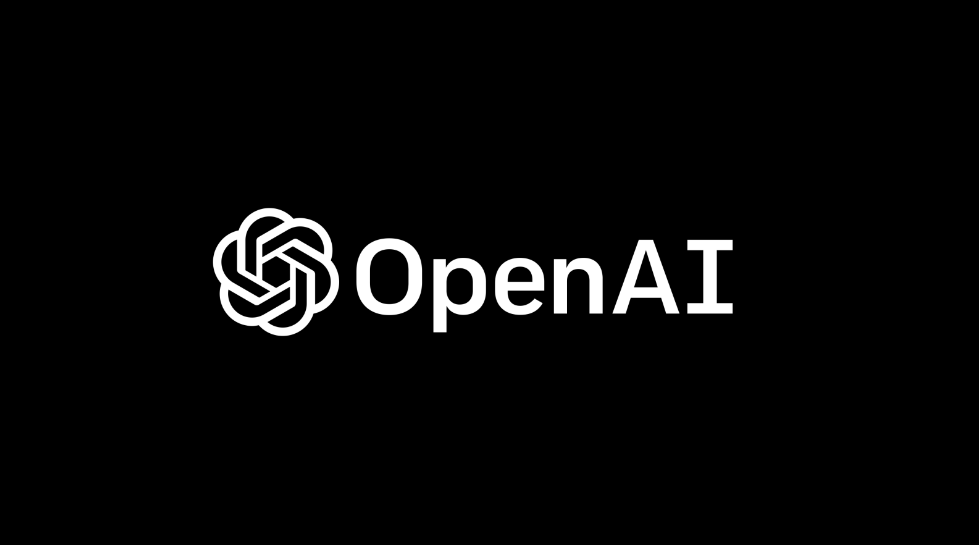

在国内,百度发布文心一言,成为中国第一个类ChatGPT产品;华为在2021年基于昇腾AI与鹏城实验室联合发布了鹏程盘古大模型;阿里在2022年9月发布了“通义”大模型系列,包含NLP大模型AlicMind、视觉大模型、多模态大模型M6;腾讯和阿里思路差不多,在去年发布了混元AI大模型,其中包含NLP、CV和多模态等基础模型和众多行业/领域模型;京东也宣布研发产业版的ChatGPT—ChatJD;网易、360、字节跳动等都官宣了自己在AI大模型方面的布局。

可以说,目前国内的互联网企业基本都拥有一个AI大模型,或者制定了相应的计划。

与国外企业专注于一个大模型并且在实验室训练研发不同,国内科技企业在大模型方面的布局和储备是一个组合拳,是直接从产业端实战出来的。虽然消费端的用户感知并不强烈,但不代表咱们没有大动作。

当你发现开车时,自动驾驶对于障碍识别越来越精准、倒车入库踩线越来越细致,视觉大模型可能已经迭代了好几个版本;你发现家里的智能音箱越来越能get你的意思时,NLP大模型可能在默默努力……许多生活中服务和应用升级的背后,都有大模型的功劳。

在所有头部厂商中,商汤则是大模型储备上的佼佼者,而且商汤的AI大模型已经历过商业化验证。截至目前商汤的商用模型就超过了67000个,据商汤财报,其语言大模型、多模态大模型、AI内容生成(AIGC)模型等正在从以前的“支持状态”快速浮出水面。

行至2023年,对百度、商汤这种拥有大模型搭建能力的企业,大家正在从“卖算力”走向“卖模型”,Maas也成为了AI企业发展的新商业路径。

走稳大模型的底层逻辑

在大模型这个赛道上,其实并无任何实质性技术卡脖子。例如GPT的逻辑,是技术以及运用算力进行试错与暴力破解。李彦宏也坦言,语言大模型是算力和数据的“暴力美学”,只有当训练的数据达到一定规模的情况下,才会出现智能涌现。

所以大模型繁荣式爆发的背后,是算力、算法、数据三大底层能力。在国内科技厂商中,AI原生企业的积累不容小觑。

例如上文提到的商汤,已布局大模型领域5年之久,解决了不少大模型实际应用中的问题,顺利打开商业化的口子。

首先,在大模型的应用领域上,商汤相比于单一的语言模型,有着更广的半径。

在CV领域,商汤研发了320亿参数的全球最大通用视觉模型,实现高性能的目标检测、图像分割和多物体识别算法等,在自动驾驶、医疗影像等领域得到应用。据悉,商汤在2022年环视感知算法BEVFormer 获得了 Waymo 挑战赛冠军。

在AIGC文生图领域,2022年商汤训练的AIGC文生图模型,对文生图的理解以及推理速度等具备强能力。在NLP自然语言处理领域,商汤今年年中即将推出千亿参数量的NLP大模型,显著提高了文本生成、人机对话等任务的性能。

在多模态大模型方面,商汤已经把拥有30亿参数的多模态大模型—书生2.5开源。“书生2.5”不仅是世界上开源模型中ImageNet准确度最高、规模最大的模型,也是物体检测标杆数据集COCO中唯一超过65.0mAP的模型,推动通用AI技术的规模化应用。

这样看来,商汤在大模型训练上收获颇丰,已然跑在了行业前列。能取得领先优势,除了商汤跑得快以外,还因为起跑点不一样,得益于其底层逻辑为“大装置 大模型”。

这些年,商汤一直在打造SenseCore大装置,2022年SenseCore大装置持续扩建,已完成2.7万块GPU的部署,并实现了5.0exaFLOPS的算力输出能力,有效支持20个千亿参数量大模型(以千卡并行)同时训练,最高可支持万亿参数超大模型的训练。

把上文翻译一下,作为基础设施,商汤大装置可以把AI能力变成一个从输入到输出的机器,而且商汤一直在扩大这个机器的能力,未来能应用“机器”的领域更多,直至赋能千行百业。

还有业内人士这样拆解商汤“大装置 大模型 ”的优势:

每次训练模型,相当于给模型喂饭,既然要做饭,你需要采购数据中心、芯片、算力等,然后自己加工喂到模型嘴里,这是“食堂模式”。

但是有了SenseCore大装置后,给模型喂饭就不用担惊受怕今天买不到米、明天买不到菜,大装置相当于一片菜地,不需要出去采购,直接摘了果实做成食物就能喂给模型进行训练,这是商汤搭建大模型范围广、数量多的重要原因。

此外,大装置还从算力、算法、平台方面,带动AI模型生产在规模、性能、速度等方面的提升,大幅降低AI模型的生产成本、加速大模型的研发。

例如前文提到,到2022年底,商汤的累计商用模型已经达到了67000个,同比增加了93%;2022年人均研发模型数量9.35个,效率也比前年翻倍。可以这样理解,从自家菜地里摘果实要比外采便宜得多也方便得多,大家给模型喂饭也有底气了也更高效了、研发速度也提高了。有了这个基础,未来建立大模型的能力也有望从头部玩家转向中小入局者。同样这也能解决AI模型生产成本高昂、AI模型定制化开发效率低,无法满足市场的大量需求、难以训练高性能AI模型等问题。

据商汤最新财报的披露,公司已经将SenseCore AI大装置的能力向行业客户开放,目前服务了8家客户进行大模型训练,已训练超过10个大模型,其中就包括了CV大模型、NLP大模型和多模态大模型等。2022年,商汤SenseCore大装置对外服务收入占到智慧商业整体收入的20%以上,商汤预计,今年这一收入规模及占比将大幅增加。

未来大模型

可以给商汤带来多少红利?

国际货币基金组织前副总裁朱民在不久前的一次会议中表示,AI大模型不是你说一句话、写一首诗、作一幅画的问题,它改变了全球未来竞争的格局,这个我们必须争。

对于商汤来说,拥有大装置 大模型,到底能为商汤赢来多少未来?我们不妨回到财报里细细拆解。

2022年,商汤业绩增长最快的是智慧生活和智能汽车两大业务板块,皆是在大装置 大模型的基础上破局商业化。

商汤的智慧生活收入同比增长130%,机构分析增长原因是拥有AIGC全栈能力的SenseMARS平台,在200多个移动应用中被持续使用,头部客户续约率超过95%,线下也覆盖到了大型游乐园区、大型商场等120个场景。

不久前,SenseMARS还为房产营销提供了AIGC的解决方案,相较于传统VR看房,SenseMARS带来了像素级的场景复刻,让大家解锁如同亲临现场般地漫游看房感受。

截至2022年底,商汤智慧生活的客户数达到317个,同比增长23%,单客户ARPU也同比增长了86%。值得一提的是,智慧生活板块在AI传感器、AI ISP芯片、智慧医疗等方面都有了商业化突破。

在另一个高增长板块智能汽车上,商汤的表现在机构的预料之内,因为汽车厂家的结构并不复杂。

2022年,商汤的绝影智能车舱和智能驾驶产品完成了27款车型的适配和量产交付,量产交付数量超过50万;座舱客户包括蔚来、广汽、比亚迪、长安等;L2 /L2 ADAS等产品主要交付给广汽、合众的旗舰车型;新增定点数超800万辆,覆盖30余家车企的80多款车型。

另外,基于多个AI模型上的积淀并且借助激光雷达、摄像头、毫米波雷达等基础感知设备,商汤还推出了“绝影车路协同平台”,可以对车端、路端的信息进行融合处理,实现“车-路-云”一体化决策控制。例如它能解决99%以上的单车盲区问题;借助AI云计算和云控平台,还可以实现车辆感知范围的千倍扩展;另外通过提供精准路径导航、车速建议和碳排放优化等功能,更能显著降低路口平均延误时间和绿灯空放现象,提升交通效能超过20%。

中金公司在研报中称,商汤的汽车业务依托于在视觉领域的多年积累,已具备客户群基础,ADAS的标杆案例也有望为后续拿单带来示范效应;智慧生活与智能汽车占比在2025年有望达50-60%,远超当前33%的水平,成为强劲驱动力。

写在最后

AI领域的投资逻辑一直都是“投资前置,收益后置”。投资规模大,盈利周期长。

马斯克当年给了OpenAI一笔钱后就拂袖离去,坊间传言没有继续投资,因此OpenAI无法支付在超级计算机上训练人工智能模型所需的巨额费用。再到OpenAI功成名就后,马斯克和OpenAI之间又基于“摘桃子”battle了好几个回合。

我们在AI赛道上也不能短视,特别是在大模型竞争上,任何企业都需要与具体的行业结合,才能形成确定性的商业模式,这才是长期投入带来的“高技术门槛,强竞争壁垒”。对于深耕大模型已久的商汤来说,一家AI原生公司在讲故事层面或许不如互联网大厂那般丰富多彩;但在大模型研发落地上,则值得被注入新的期待。

节点财经声明:文章内容仅供参考,文章中的信息或所表述的意见不构成任何投资建议,节点财经不对因使用本文章所采取的任何行动承担任何责任。

- 0007

- 0007

- 0000

- 0001

- 00023