exllamav2:一个用于在现代消费 GPU 上运行本地 LLM 的推理库

站长网2023-09-15 10:24:040阅

exllamav2是一个用于在现代消费级GPU上本地运行大型语言模型(LLM)的快速推理库。它能够利用最新的GPU技术,在不牺牲太多质量的情况下,以非常快的速度对巨大的神经网络进行推理。

项目地址:https://github.com/turboderp/exllamav2

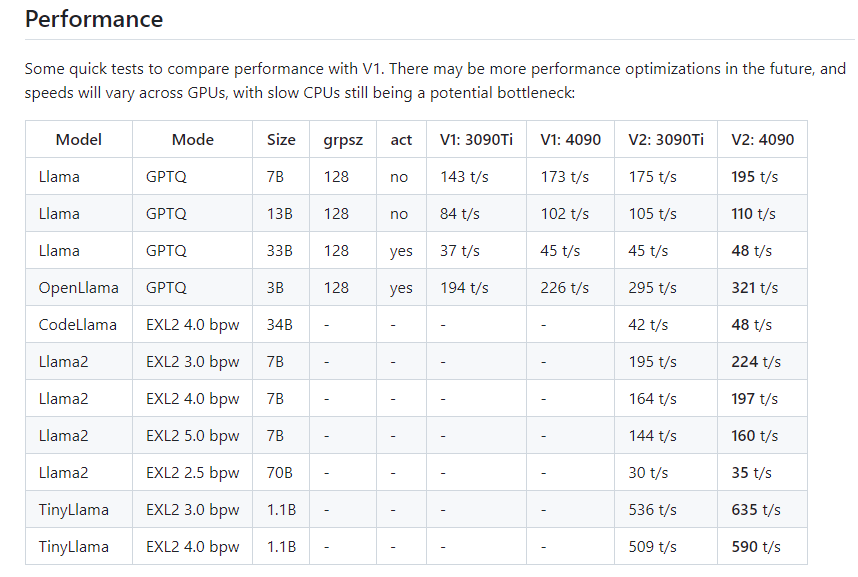

这个库采用了全新的代码库和内核实现,相比之前的版本获得了显著的性能提升。ExLlamaV2支持与 V1相同的4位 GPTQ 模型,但也支持新的“EXL2”格式。EXL2基于与GPTQ相同的优化方法,支持2、3、4、5、6和8位量化。该格式允许在模型内混合量化级别,以实现每个权重2到8位之间的任何平均比特率。这样既可以充分利用GPU的计算能力,又可以控制模型大小,适应不同的显存限制。

在测试中,利用EXL2格式,一个70B参数的模型可以在单块24GB显存的GPU上运行,一个13B参数的模型也可以在8GB显存中顺畅地进行推理。这为在普通的台式机上本地运行大模型打开了可能性。相比之前的版本,新的内核和代码架构也带来了1.5-2倍的速度提升。

这个库还集成了与HuggingFace模型的兼容性,提供了文字生成的交互式示例,以及将模型转换为量化格式的脚本。它的目标是成为一个易于入门和使用的LLM推理解决方案,让更多的人可以无障碍地体验和应用LLM带来的强大能力。

总之,exllamav2是一个非常有前景的LLM推理库。它为利用家用GPU资源运行大模型提供了一个切实可行的途径。随着它的不断发展和优化,相信它一定会让LLM的应用变得更加普及。

核心功能:

- 支持4位GPTQ模型

- 支持新的EXL22-8比特可调量化格式

- 大幅提升的推理性能

- 易于安装和使用

- 支持HuggingFace模型转换

- 提供交互式示例

0000

评论列表

共(0)条相关推荐

- 0000

- 0000

- 0000

- 000123

- 0000