LLM Finetuning Hub开源:提升大型语言模型性能的实用平台

站长网2023-09-06 17:57:010阅

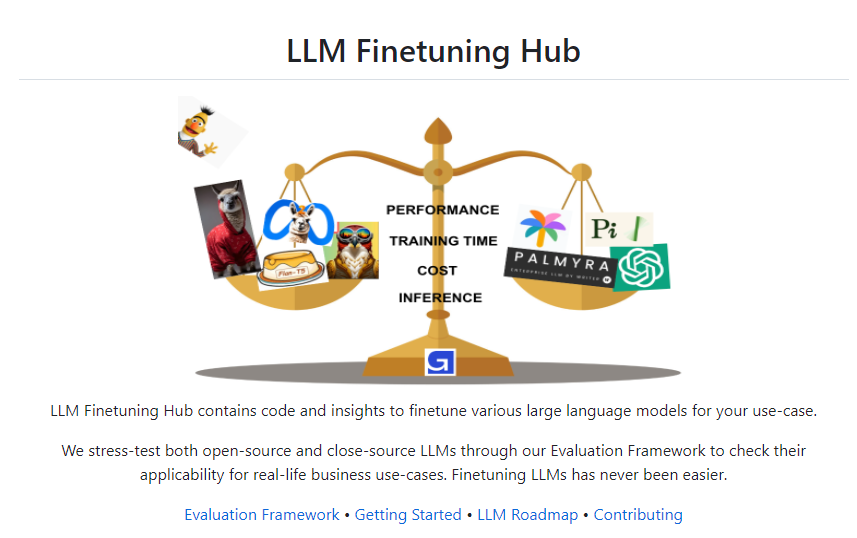

大语言模型微调中心(LLM Finetuning Hub)是一个开源项目,它包含了大规模语言模型(LLM)微调和部署的代码库以及相关研究成果。该项目由Georgian Partners旗下的Georgian IO团队开发,目的是帮助用户轻松地针对具体业务场景对各种LLM进行微调,并根据综合评估结果选择最适合的模型。

项目地址:https://github.com/georgian-io/LLM-Finetuning-Hub

该项目提供了针对多个流行LLM的微调脚本,如Flan-T5、Falcon、RedPajama等,使用户可以通过省时省力的方法,基于LORA和Prefix Tuning等模型微调技术,在自定义数据集上快速微调这些LLM。同时,该项目还提供了丰富的评估指标,允许用户从性能、训练时间、训练成本以及推理等多个维度对LLM进行全面评估,以确定最符合具体业务需求的LLM方案。所有脚本都经过详细注释,可以直接用于生产环境,大大降低了使用LLM的门槛。

该项目源代码托管在GitHub上,采用开源Apache2.0协议。用户可以轻松Fork项目、在本地修改并提交PR,参与到LLM微调相关研究的开源社区当中。该项目预计会持续迭代,支持越来越多前沿的LLM,并公开更多评估实验结果,以造福LLM领域的技术发展。

核心功能:

提供多种流行LLM的微调脚本

支持基于LORA、Prefix Tuning等方法进行模型微调

评估框架全面(性能、耗时、成本、推理)

脚本可直接用于生产环境

开源代码,社区维护

0000

评论列表

共(0)条相关推荐

- 0004

- 0000

- 0002

- 0002

- 0000