图像编辑EditGAN新方法:实现高精度细节编辑 并保持图像质量

文章概要:

1. EditGAN 是高精度语义图像编辑的新方法,解决传统GAN的局限

2. EditGAN 通过嵌入图像到GAN的潜在空间进行精确编辑,学习“编辑向量”

3. EditGAN 可以进行高精度编辑,同时保持图像质量,表现超过其他模型

近年来,生成对抗网络(GAN)在图像编辑领域得到广泛应用。但是传统GAN架构存在一些局限,如需要大量标注数据、编辑控制粒度较粗等。为解决这些问题,NVIDIA 在2022年提出了EditGAN。

EditGAN是一种高精度、高质量语义图像编辑的新方法。它基于一种GAN框架,可以同时建模图像及其语义分割,只需要很少的标注数据。

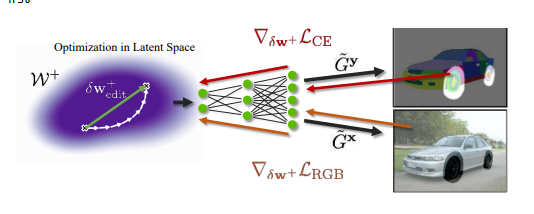

EditGAN通过优化将图像嵌入到GAN的潜在空间,然后根据分割编辑进行条件潜码优化,以精确修改图像。为了缩短优化过程,模型会在潜在空间中找到实现编辑的“编辑向量”。

EditGAN框架可以学习任意数量的编辑向量,然后可以高效地应用于其他图像。实验结果表明,EditGAN可以在保持图像质量的同时,以前所未有的细节进行图像编辑。相比其他模型,EditGAN可以进行更复杂、更精细的编辑,同时保持身份信息及图像质量。

上图展示了 EditGAN 框架在新颖图像上应用先前学习的编辑向量并使用30个优化步骤细化图像时的性能。

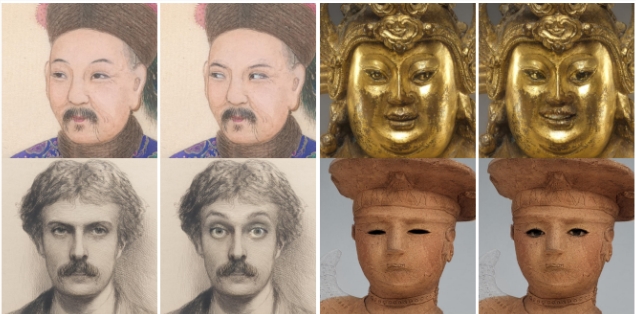

为了评估 EditGAN 的域外性能,该框架已在 MetFaces 数据集上进行了测试。EditGAN 模型使用域内真实面孔来创建编辑向量。然后,该模型使用100步优化过程嵌入域外的 MetFaces 肖像,并通过30步自我监督细化过程应用编辑向量。结果如下图所示。

简单的说,EditGAN是第一个基于 GAN 的图像编辑框架,它提供了如下功能:

非常高精度的编辑。

可以处理少量标记数据。

可以在实时场景中有效部署。

允许同时进行多个编辑的组合性。

适用于 GAN 生成的、真实的嵌入图像,甚至域外图像。

此外,EditGAN 提供了三种不同的编辑模式:使用预学习的编辑向量实时编辑、使用自监督优化refine向量编辑、从头开始优化进行大范围编辑的全优化编辑。定量结果显示,在保持语义正确性及身份信息的同时,EditGAN也可以生成高质量的编辑结果。

EditGAN是语义图像编辑领域的重要进展,可以进行高精度编辑,其性能也超过当前其他模型。它很可能成为这个领域的新标准。

由于 EditGAN 基于 GAN 框架,因此它与任何其他 GAN 模型具有相同的限制:它只能处理可由 GAN 建模的图像。EditGAN 在处理 GAN 建模图像方面的局限性是难以跨不同场景实现 EditGAN 的主要原因。然而,值得注意的是,EditGAN 的高精度编辑可以通过利用编辑向量轻松转移到其他不同的图像。

EditGAN特点总结如下:

1. 基于GAN框架,只需要很少的标注数据即可进行高精度语义图像编辑

2. 通过将图像嵌入GAN的潜在空间,学习“编辑向量”来修改图像

3. 可以学习任意数量的编辑向量,高效应用到其他图像上

4. 可以进行前所未有的细节编辑,同时保持图像质量

5. 提供实时编辑向量编辑、自我监督向量编辑、全优化编辑三种编辑模式

6. 定量结果显示在保证语义和身份信息正确的同时,也可以生成高质量结果

内容参考自:https://www.unite.ai/high-precision-semantic-image-editing-with-editgan/

- 0000

- 0000

- 0000

- 0000

- 0000