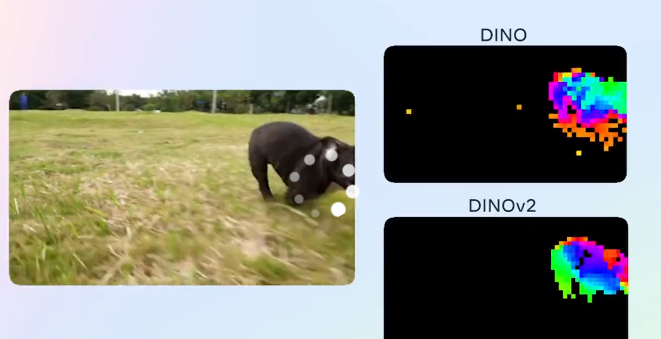

Meta 开源计算机视觉基础模型DINOv2

文章概要:

1. Meta公司以Apache2.0许可证发布计算机视觉模型DINOv2开源版本。

2. DINOv2可用于各种计算机视觉任务,是灵活通用的工具。

3. Meta计划将DINOv2与大规模语言模型结合,创造更强大的图像分析系统。

Meta 在 Apache2.0许可下发布其计算机视觉模型 DINOv2,为开发人员和研究人员提供下游任务的更大灵活性。Meta 还发布了一系列基于 DINOv2的密集预测模型,用于语义图像分割和单目深度估计。

Meta 还引入了FACET,这是一个评估计算机视觉模型在分类和分割等任务中的公平性的基准。该数据集包含50,000人的32,000张图像,除了身体特征之外,还具有感知性别和年龄组等人口统计属性。FACET旨在成为评估计算机视觉模型公平性的标准基准,并鼓励设计和开发考虑更多人的模型。

DINOv2是一种自监督学习训练的模型,在各种视觉任务上的表现可与当前主流的专用系统可相媲美甚至更好。该模型可以为下游任务提供更大的灵活性,是一种通用的计算机视觉工具。

DINOv2经过1.42亿张图像的训练,可以直接作为各种视觉任务的输入特征使用,包括图像级任务(图像分类、实例检索、视频理解等)和像素级任务(深度估计、语义分割等)。DINOv2模型可能在各种应用中发挥作用,如森林绘图、动物密度估计、生物学研究等。

DINOv2核心特色功能包括:

基于PyTorch实现的DINOv2自监督学习方法的代码和预训练模型

不需要任何标签或注释即可在包含1.42亿张图像的数据集上进行预训练

产生高性能的视觉特征,可以直接与简单的线性层组合在各种计算机视觉任务上使用

预训练模型效果强劲,在不进行微调的情况下也能跨域泛化

提供多个预训练模型 BACKBONE(ViT-S/14、ViT-B/14等)可通过PyTorch Hub加载

提供了对应预训练任务头,如图像分类、深度估计、语义分割等

代码模块化,可以方便训练、评估和微调

模型和代码均基于Apache2.0许可证开源

Meta公司计划将DINOv2与大规模语言模型相结合,创造出更强大的图像分析和处理系统。语言模型受输入字幕限制,而DINOv2可以为复杂的AI系统提供更丰富的图像信息,实现更深层次的图像推理。DINOv2的开源发布是计算机视觉领域的重要进展。

DINOv2项目网址:https://github.com/facebookresearch/dinov2

FACET官方介绍:https://ai.meta.com/datasets/facet/

- 0000

- 0001

- 0000

- 0000

- 0000