新加坡南洋理工大学出品!大规模视频分割数据集MeViS,自动识别视频动态主体

文章概要:

1) MeVIS数据集包含2006段视频,强调目标物体的运动属性,不能仅从单帧识别。

2) 提出LMPM基准方法,利用语言理解和运动评估找到视频中语言描述的目标物体。

3) 研究为发展更高级的语言引导视频分割算法奠定基础。

当前用于引用视频对象的数据集通常强调突出的对象并依赖于具有许多静态属性的语言表达。这些属性允许仅在单帧中识别目标对象。然而,这些数据集忽视了运动在语言引导视频对象分割中的重要性。

新加坡南洋理工大学研究人员发表了一篇AI论文,提出了一个大规模视频分割基准数据集MeVIS(Motion Expression Video Segmentation)。简单的说,MeViS是一个大规模的视频分割数据集,它让计算机能够根据描述对象运动的自然语言语句来分割和跟踪视频中的目标对象。

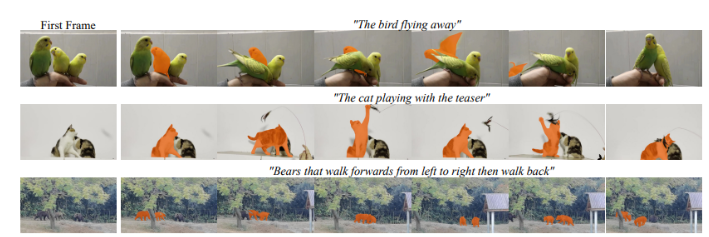

MeViS 数据集包含2,006个视频和8,171个对象,并提供了28,570个运动表达式来引用这些对象。数据集示例中,表达主要集中在运动属性,被指代的目标物体无法仅通过观察单帧进行识别。上图显示了 MeViS 中的表达式主要关注运动属性,仅通过检查单帧无法识别所涉及的目标对象。比如给计算机一个视频和一个句子“飞离树枝的鸟”,它就可以在整个视频中找出符合这个句子描述的鸟,并把这只鸟在每一帧图像中的位置分割出来。

MeViS不同于以前的数据集,以前的数据集更关注静态的特征比如颜色、形状等来分割,而MeViS关注的是运动信息。例如视频里有三只外观很像的鸟,只有根据它们的飞行动作才能区分出目标鸟。

研究人员采取了一些步骤,确保MeVIS数据集强调视频的时间运动:

首先,仔细选择视频内容,其中包含与运动共存的多个对象,并排除具有静态属性可以轻松描述的孤立对象的视频。

其次,在仅通过动作词就可以明确描述目标对象的情况下,优先考虑不包含静态线索(例如类别名称或对象颜色)的语言表达。

除了提出MeVIS数据集,研究人员还给出了一个基准方法LMPM(Language-guided Motion Perception and Matching)来解决这个数据集提出的挑战。他们的方法包含生成语言条件查询来在视频中识别可能的目标物体,使用更稳健高效的对象嵌入来表示这些对象,应用运动感知捕捉对象嵌入的时间上下文,从而建立视频运动动力学的整体理解,以掌握视频中的瞬时运动和持续运动。

然后,他们比较语言特征与预测的对象运动,找到语言表达中提到的目标物体。这种方法有效结合了语言理解和运动评估来处理复杂的数据集任务。

这项研究为开发更高级的语言引导视频分割算法奠定了基础。它向更具挑战性的方向开辟了道路,如探索更好的理解运动和建模技术、创建更高效的模型以减少冗余检测物体、设计有效的跨模态融合方法等。解决这些挑战需要推动语言引导视频分割领域的当前最新技术。

项目网址:

https://github.com/henghuiding/MeViS

https://henghuiding.github.io/MeViS/

论文:https://arxiv.org/abs/2308.08544

- 0000

- 0000

- 0004

- 0000

- 0000