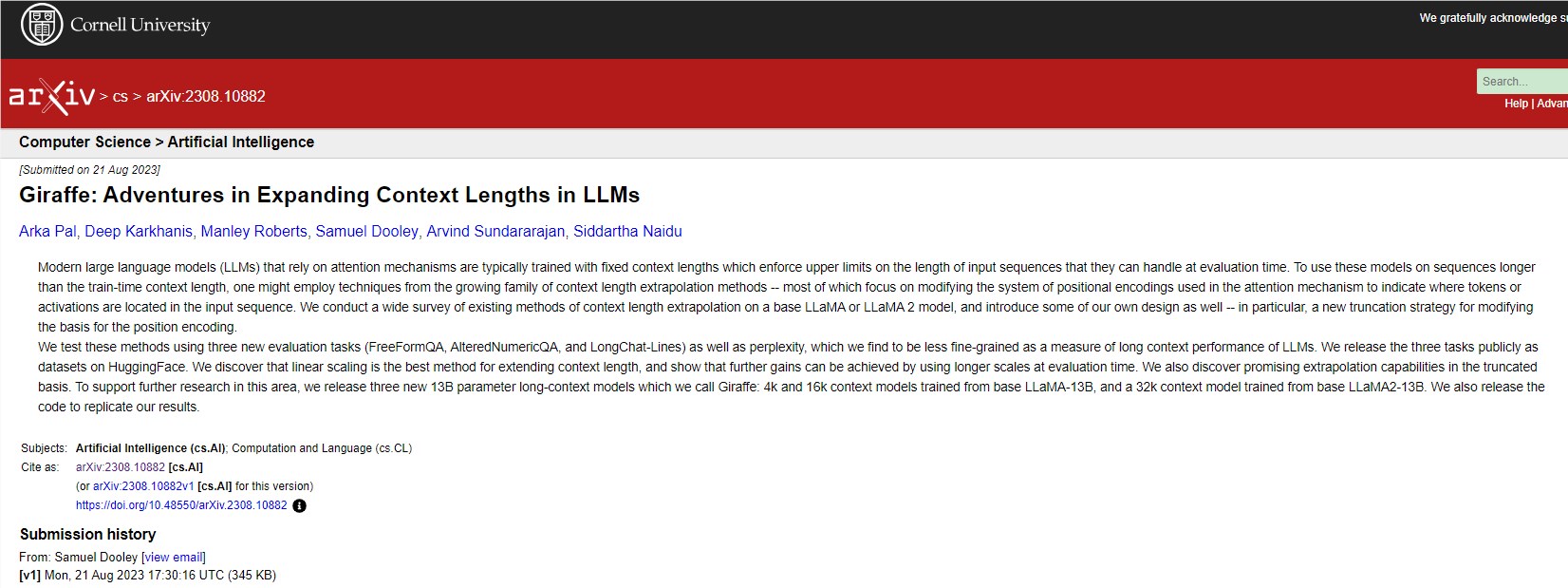

32k上下文可商用!长颈鹿来袭,开源大模型长度再创新高

要点:

长颈鹿是基于LLaMA模型打造的,上下文长度达到32k,是目前开源大模型中最长的。

研发团队Abacus.AI通过测试不同的上下文外推方法,发现线性插值效果最好,并在此基础上提出了Power Scaling和Truncated Basis两种新思路。

尽管Abacus.AI宣称长颈鹿是首个32k开源模型,但Together.AI更早发布了类似规模的版本,两者可以说并列第一。

长颈鹿(Giraffe)是Abacus.AI团队基于LLaMA模型系列打造的新作,被称为“开源大模型史上第一个上下文长度达到32k的版本”。LLaMA发布于2022年,包含多个规模参数的迭代版本,但都仅有4k的上下文长度,在实际应用中表现仍有局限。为突破这一瓶颈,Abacus.AI团队进行了一系列测试与优化。

论文地址:https://arxiv.org/abs/2308.10882

项目地址:https://huggingface.co/abacusai/Giraffe-v2-13b-32k

他们发现,通过修改注意力机制中的位置编码系统是当前主流的上下文外推方法,包括线性缩放、随机编码等。在此基础上,团队提出了Power Scaling和Truncated Basis两种新思路。Power Scaling是对原有编码做指数变换,使模型更倾向于外推距离较远的上下文;Truncated Basis则是保留高频分量但将低频分量设置为0,也能在循环周期中覆盖更长距离。

为全面评估不同方法的效果,团队设计了三个新的测试集,除困惑度外还加入了问答和关键词检索等任务。结果显示,线性插值最为有效,新提出的Truncated Basis也展现出一定的优势。最终,团队选择线性插值法打造出长颈鹿系列模型,长度可选4k、16k和32k。

Abacus.AI宣称这是全球首个32k开源大模型,但实际上Together.AI已经在更早发布了类似的版本。两家企业使用的上下文扩展方法和模型规模也有细微区别。所以,可以说长颈鹿与Together.AI的模型并列为当前开源领域32k长度的“第一”。

- 0000

- 0000

- 0000

- 0000

- 0000