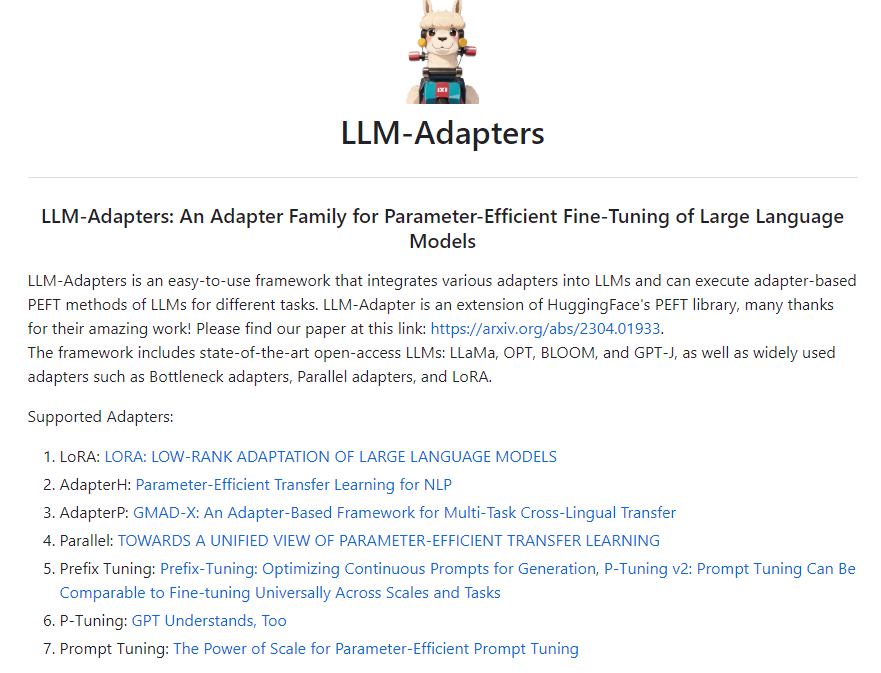

LLM-Adapters:将各种适配器集成到大型语言模型中

来自新加坡科技设计大学和新加坡管理大学的研究人员发布了一篇题为《LLM-Adapters: An Adapter Family for Parameter-Efficient Fine-Tuning of Large Language Models》的论文。该论文介绍了一种名为 LLM-Adapters 的适配器系列,用于大型语言模型的参数高效微调。该适配器系列可在不影响模型性能的情况下减少微调所需的参数数量,从而提高微调效率。

代码:https://github.com/AGI-Edgerunners/LLM-Adapters

LLM-Adapters 框架包含了最先进的开放访问大型语言模型,如 LLaMA、BLOOM、OPT 和 GPT-J,以及广泛使用的适配器,具体如下:

1、串联适配器(Series Adapter):在每个Transformer块的多头自注意力层和前馈层后串联地添加瓶颈前馈层,如图1(a)所示。

2、并行适配器(Parallel Adapter): 如图1(b)所示,将瓶颈前馈层与每个Transformer层的多头自注意力层和前馈层并行地集成。

3、LoRA:如图1(c)所示,向现有层中注入低秩可训练矩阵,实现参数高效微调。

LLM-Adapters框架设计在研究、efficient、模块化和可扩展方面表现良好,允许集成新的适配器和用新的更大规模的语言模型进行评估。

为了评估 LLM-Adapters 中的适配器的有效性,作者在6个数学推理数据集上进行了实验。实验结果表明,在简单的数学推理任务上,使用较小规模语言模型的参数高效微调仅需要很少的可训练参数,就能达到强大语言模型在零样本推断中可比的性能。总体而言,LLM-Adapters 框架提供了一个有希望的框架来微调大型语言模型用于下游任务。

核心功能:

适配器集成:将各种适配器(如 LoRA、AdapterH、AdapterP、Parallel)集成到 LLMs 中,提供灵活的模型适配能力。

参数高效微调:使用适配器进行参数高效微调,减少参数量,节省训练时间和计算资源。

支持多种任务:适用于各种 NLP 任务,如语言生成、问答、机器翻译等。

提供预训练模型:集成了 LLaMa、OPT、BLOOM 和 GPT-J 等最先进的预训练模型,可直接使用。

简化模型训练和推理:提供训练和推理代码示例,简化模型训练和推理流程。

LLM-Adapters 是一个强大的工具,可帮助用户快速搭建和优化大型语言模型,并在各种 NLP 任务上取得优秀的性能。

- 0001

- 0000

- 0000

- 0000

- 0000