利用检索增强生成技术提升语言模型的能力

文章要点:

检索增强生成(RAG)方法可以让语言模型访问最新的知识库,从而提高模型在实际业务中的应用能力。

RAG 方法相比重新训练模型或微调模型更为便宜和容易实现,同时也避免了数据集准备的工作量。

使用 Haystack 等开源框架,结合句子嵌入技术和检索算法,可以构建强大的 RAG-enabled 语言模型,提供准确、实时的信息检索和问题回答能力。

虽然人们在工作中使用ChatGPT等生成式人工智能可以大大提高效率,但有时候,ChatGPT52%的回答是错误的。有人提出,可以利用检索增强生成(RAG)方法来增强语言模型(LLM)。

为了解决这个问题,国外一博主提出了两种方法:一种是在最新数据上训练或微调模型,但这种方法成本高且准备数据集的工作量大;另一种方法是使用 RAG 方法,将一个最新的知识库与大型语言模型结合起来,这种方法成本较低且易于实施。

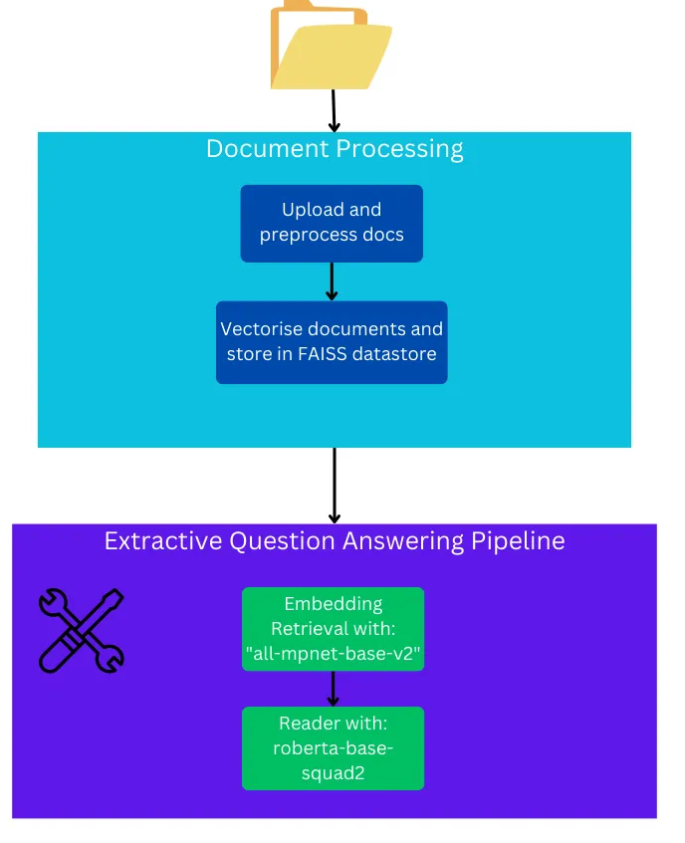

这些涉及到如何使用 Haystack 框架、sentence transformers 和 transformers 库来构建 RAG-enabled 模型。首先,需要对文档进行预处理和存储,然后构建一个提取式问答管道,包括检索器和阅读器。最后,通过使用大型语言模型(如 OpenAI 的 gpt-4)构建一个 RAG-enabled 代理模型。

博主通过向模型提问关于2022年俄乌冲突的问题进行了测试,并与谷歌搜索的结果进行了对比。测试结果显示,RAG-enabled 模型能够给出相关的回答,但在某些情况下可能会产生幻觉或不完全准确的回答。

通过利用 RAG 方法增强语言模型的能力,使其可以访问最新的知识库,从而在各种应用场景中更加实用。但需要注意的是,模型的性能取决于提供的知识库的质量,而且部署模型的基础设施也会影响推理时间。此外,通过增加步骤数或添加记忆组件等方式,可以进一步改进模型的性能。

具体操作方法点此查看

- 0000

- 0000

- 0000

- 0000

- 0000