基于 Transformer 的大模型如何从参数中提取知识

站长网2023-07-26 15:01:190阅

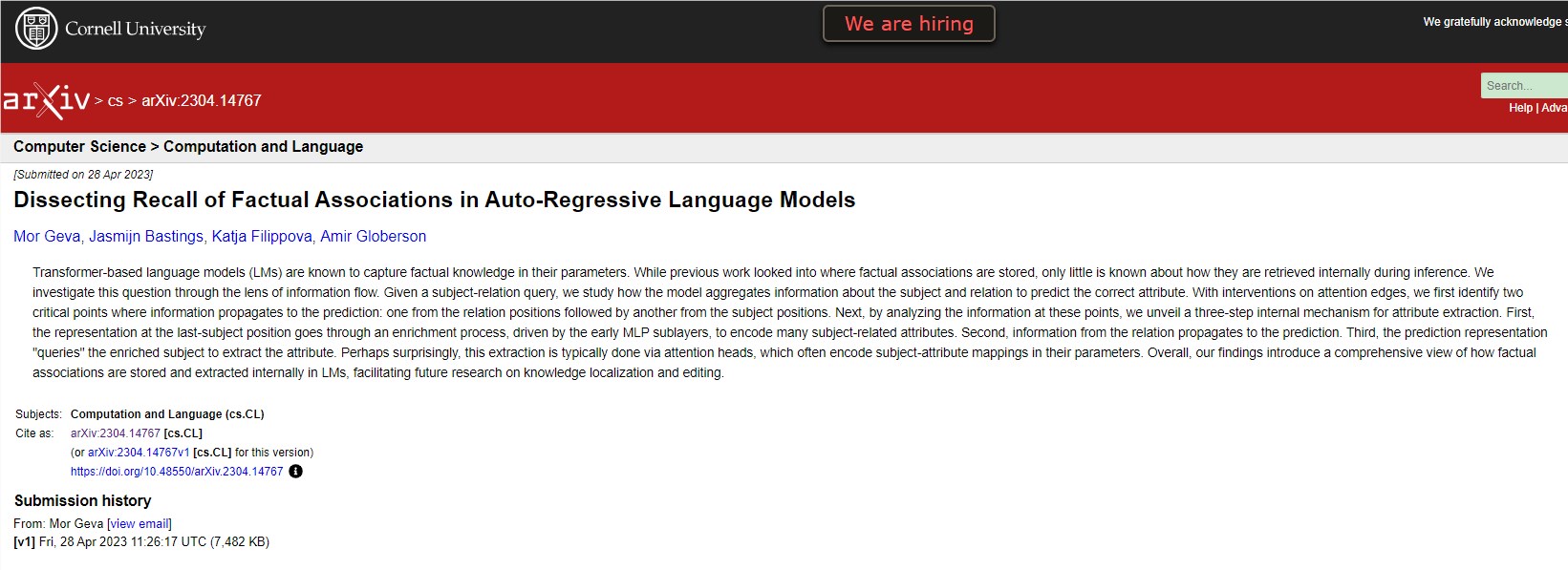

最近一项由 Google DeepMind、特拉维夫大学和 Google 研究人员进行的研究,旨在探究基于 Transformer 的大型语言模型(LLMs)如何存储和提取事实关联。研究采用信息流的方法,研究模型如何预测正确的属性,并观察模型在不同层次中的内部表示是如何演变的。

论文地址:https://arxiv.org/abs/2304.14767

研究发现,模型的关键计算点与关系和主体位置有关。研究人员使用 "阻塞" 策略,阻止最后一个位置在特定层次上与其他位置产生关联,并观察推理过程中的影响。通过分析这些关键点和前面的表示构建过程,研究人员进一步确定了属性提取发生的位置。

研究人员发现了一种基于主体丰富过程和属性提取操作的内部机制。在模型的早期层次中,关于主体的信息在最后一个主体标记中得到丰富,而关系则传递给最后一个标记。最后一个标记使用关系通过自注意力机制从主体表示中提取相应的属性。

这些发现揭示了 LLMs 内部如何存储和提取事实关联的机制。研究人员认为,这些发现可以为知识定位和模型编辑开辟新的研究方向。例如,可以利用这种方法来确定 LLMs 获取和存储偏见信息的内部机制,并开发缓解这种偏见的方法。

总之,这项研究强调了研究 Transformer 模型如何存储和提取事实关联的内部机制的重要性。通过了解这些机制,研究人员可以开发更有效的方法来提高模型性能并减少偏见。此外,这种方法还可以应用于其他自然语言处理领域,如情感分析和语言翻译,以更好地理解这些模型的内部运作。

0000

评论列表

共(0)条相关推荐

- 0000

- 0000

- 0001

- 0000

- 0001