开源工具xTuring厉害了,三行代码就能创建自己的大语言模型

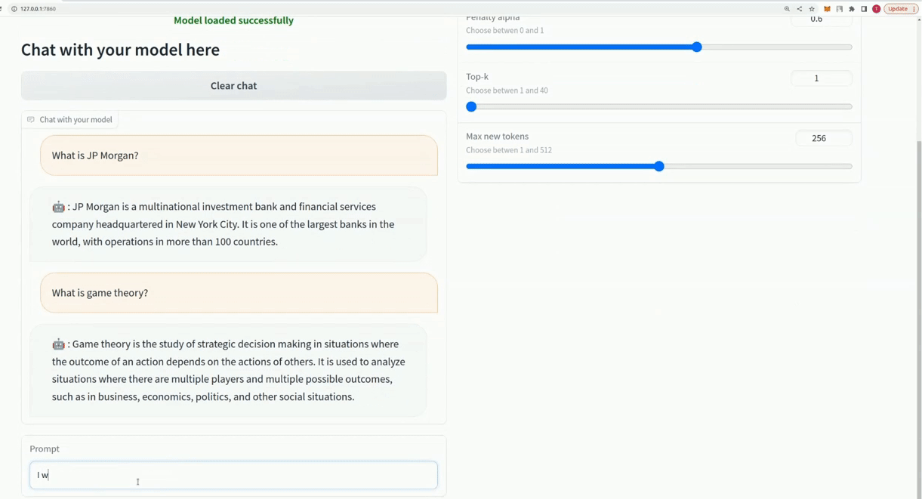

xTuring 是一个开源工具,可以让用户只用三行代码就能创建自己的大语言模型 (LLMs)。

据了解,xTuring由 Stochastic 团队开发,旨在优化和加速人工智能大语言模型。Stochastic 拥有一支由聪明的机器学习工程师、博士后和哈佛大学研究生组成的团队,专注于优化和加速法学硕士的人工智能。

自动文本传输、聊天机器人、语言翻译和内容制作等应用程序是人们努力利用这些概念开发和创建新应用程序的领域。训练和微调这些模型可能既耗时又昂贵。无论是使用 LLaMA、GPT-J、GPT-2还是其他方法,xTuring 都可以轻松快速地进行模型优化。

xTuring 可以适应不同的硬件配置,通过内存高效的微调技术 LoRA,加快学习过程,降低硬件成本。据称,xTuring 使用 LoRA 等内存高效微调技术来加速学习过程,并将硬件支出减少多达90%。通过减少微调所需的内存量,LoRA 有助于更快速、更有效的模型训练。

与其他微调技术相比,xTuring 在 LLaMA7B 模型的微调能力上取得了出色的结果。LLaMA7B 模型被用作 xTuring 微调能力的基准,团队将 xTuring 与其他微调技术进行了比较。数据集由52K token组成,测试中使用了335GB CPU 内存和4xA100GPU。

结果表明,使用 DeepSpeed CPU 卸载对 LLaMA7B 模型进行每个 epoch21小时的训练消耗了33.5GB GPU 和190GB CPU。在使用 LoRA DeepSpeed 或 LoRA DeepSpeed CPU 卸载进行微调时,GPU 上的内存使用量分别急剧下降至23.7GB 和21.9GB。CPU 使用的 RAM 量从14.9GB 下降到10.2GB。此外,使用 LoRA DeepSpeed 或 LoRA DeepSpeed CPU 卸载时,训练时间从每个 epoch40分钟减少到20分钟。

操作方面,用户可以通过简单的鼠标点击来微调模型,并且 xTuring 的用户界面非常简单易用。该团队表示,xTuring 是调整大型语言模型的不错选择,因为它支持单个和多个 GPU 训练,使用内存高效的方法,并具有直观的界面。

项目网址:https://github.com/stochasticai/xTuring

https://xturing.stochastic.ai/

- 0000

- 0000

- 0000

- 0000

- 0000