苏黎世大学研究员开发SwissBERT多语言模型 针对瑞士小语种

站长网2023-07-18 19:02:050阅

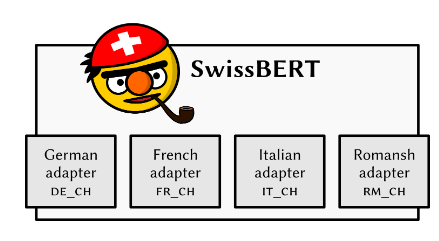

瑞士苏黎世大学的研究人员开发了一种名为 SwissBERT 的多语言语言模型,用于瑞士的四种官方语言。

之前,瑞士研究人员在多语言任务上面临困难,因为每种语言都需要单独的语言模型,而且其中一种语言甚至没有独立的神经语言模型。SwissBERT 通过组合这些语言的文章并隐式利用新闻中的实体和事件来创建多语言表示,解决了这一问题。

SwissBERT 模型是基于跨语言模块化(X-MOD)转换器进行改造的,该转换器已经在81种语言上进行了预训练。研究人员通过训练自定义的语言适配器将 X-MOD 转换器应用于他们的语料库中。他们为 SwissBERT 创建了瑞士特有的子词词汇表,生成的模型包含多达1.53亿个参数。

该模型在任务上的表现良好,例如命名实体识别和检测用户对瑞士政治的评论中的立场。在评估模型在罗曼什语上的能力时,发现 SwissBERT 在零样本跨语言迁移以及单词和句子的德语-罗曼什语对齐方面远远优于未使用该语言进行训练的模型。然而,该模型在识别 OCR 处理的历史新闻中的命名实体方面表现不佳。

通过微调下游任务,该模型在未来的研究和非商业用途中可能具有潜力。

论文:https://arxiv.org/pdf/2303.13310.pdf

项目介绍:https://vamvas.ch/introducing-swissbert

模型网址:https://huggingface.co/ZurichNLP/swissbert

0000

评论列表

共(0)条相关推荐

- 0000

- 0000

- 0000

- 0003

- 0004