OpenAI 的 GPT-4 变得「懒惰」和「愚蠢」:或被 MoE 彻底重塑导致性能下降

世界上最强大的人工智能模型似乎变得不那么强大了。这让业内人士开始谈论可能会对该系统进行重大重新设计。

最近几周,OpenAI 的 GPT-4 的用户们纷纷抱怨性能下降,有些人将这个模型与以前的推理能力和其他输出进行比较,称其变得「懒散」和「更笨」。

在 Twitter 上和 OpenAI 的在线开发者论坛上,用户们发表了对弱化逻辑、更多错误响应、追踪不到提供的信息、难以按照指令操作、忘记在基本软件代码中添加括号以及只记住最近的提示等问题的不满。

一位使用 GPT-4 来帮助编写网站功能的开发者写道:「现在的 GPT-4 令人失望。就像你开了一个月的法拉利,然后突然变成了一辆破旧的皮卡车。我不确定是否愿意为此付费。」

Roblox 的产品负责人 Peter Yang 在推特上表示,该模型生成速度更快,但质量更差。「只是一些简单的问题,比如使文本更清晰、更简洁,以及生成想法,」他补充道。「在我看来,写作质量下降了。」他问是否有其他人注意到了这一点。

另一位名为 Frazier MacLeod 的用户回答说:「我发现它变得更懒散了。」

Christi Kennedy 在 OpenAI 的开发者论坛上写道,GPT-4 开始一遍又一遍地循环输出代码和其他信息。

从缓慢且昂贵,到快速且不准确

与今年年初的情况相比,这是一个相当大的变化。当时 OpenAI 通过 ChatGPT 和 GPT-4 的推出赢得了全世界的赞誉,科技行业也在翘首以待 GPT-4 的发布。ChatGPT 最初运行在 GPT-3 和 GPT-3.5 上,它们是支撑其神奇回答的巨大基础 AI 模型。

更大的 GPT-4 于三月份推出,并迅速成为开发者和其他科技行业内部的首选模型。它被认为是目前最强大的广泛可用的 AI 模型,并且是多模态的,可以理解图像和文本输入。

在尝试这个新模型后的最初热潮之后,一些人对使用 GPT-4 的账单感到震惊。Lamini 创业公司的首席执行官 Sharon Zhou 表示,它的速度很慢,但非常准确。

忒修斯之船

然而,几周前情况发生了变化。GPT-4 的速度变快了,但性能明显下降,这引发了整个 AI 社区对重大变化正在发生的讨论,Zhou 和其他专家表示。

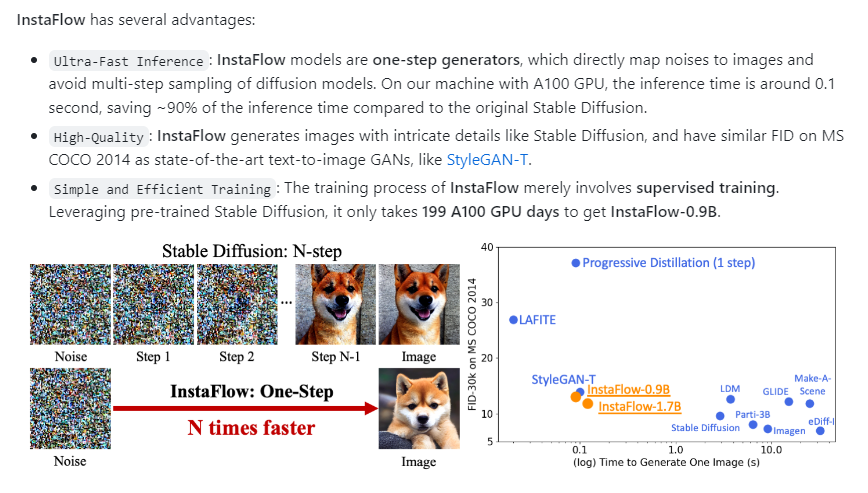

他们认为 OpenAI 正在创建几个较小的 GPT-4 模型,这些模型的行为类似于大模型,但运行成本更低。

据 Zhou 称,这种方法被称为专家混合(Mixture of Experts,MoE)。这些较小的专家模型分别针对不同的任务和领域进行训练。可能会有一个用于生物学、物理学、化学等的小型生物学家 GPT-4。当一个 GPT-4 用户提出问题时,新系统知道将查询发送给哪个专家模型。新系统可能会决定将查询发送给两个或更多的专家模型,以防万一,然后将结果混合在一起。

Zhou 表示:「这个想法已经存在一段时间了,这是自然而然的下一步。」

Zhou 将这种情况比作「忒修斯之船」思想实验,在这个实验中,船的部分逐渐被更换,引发了一个问题:在哪个时刻它成为了一个全新的船?

她说:「OpenAI 正在将 GPT-4 转变为一支由较小船只组成的小型舰队。」「从我的角度来看,这是一个新模型。有人可能会说它是一样的。」

本周,几位 AI 专家在推特上发布了他们声称是 GPT-4 架构细节的内容。初创公司创始人 Yam Peleg 在推特上表示,OpenAI 通过使用 16 个专家的混合模型来降低成本。Semianalysis 在本周写了关于 GPT-4 内部工作原理的文章。

开发者和黑客 George Hotz 在最近的一期播客中描述了 GPT-4 的「八路混合模型」。Meta 的 PyTorch 开源 AI 项目联合创始人 Soumith Chintala 对 Hotz 的评论表示了支持。

在看到本周在线泄露的消息后,Allen 人工智能研究所的创始首席执行官 Oren Etzioni 在一封电子邮件中写道:「我推测这些猜测大致是准确的,但我没有得到证实。」

他解释说,使用 MOE 方法有两个主要的技术原因:生成更好的响应,以及更便宜、更快的响应。

他补充说:「『正确的』混合将同时给你带来这两个好处,但通常在成本和质量之间存在权衡。」「在这种情况下,OpenAI 似乎在为降低成本而牺牲了一些质量。这些模型很难进行评估(什么样的响应更好?在什么情况下?),所以这只是凭经验而非科学的观察。

2022 年,OpenAI 的总裁 Greg Brockman 与其同事 Lilian Weng共同撰写的研究中提到了 MOE 方法。他们写道:「使用专家混合(Mixture-of-Experts,MoE)方法,仅使用网络的一小部分来计算任何一个输入的输出。一个例子是通过推理时的门控机制选择使用哪个权重集合。」「这样做可以在不增加计算成本的情况下增加更多参数。每个权重集合被称为『专家』,希望网络能够学习将专业计算和技能分配给每个专家。」

最近几周 GPT-4 性能下降的情况可能与这种训练有关,OpenAI 正在推出这一批较小的专家级 GPT-4 模型,Zhou 表示。

Zhou 解释说:「当用户对其进行测试时,我们会提出许多不同的问题。它的表现可能不太好,但它正在从我们这里收集数据,并且会不断改进和学习。」

- 0000

- 0001

- 0001

- 0000

- 0000