ControlNet新玩法爆火:画出可扫码插画,内容链接任意指定

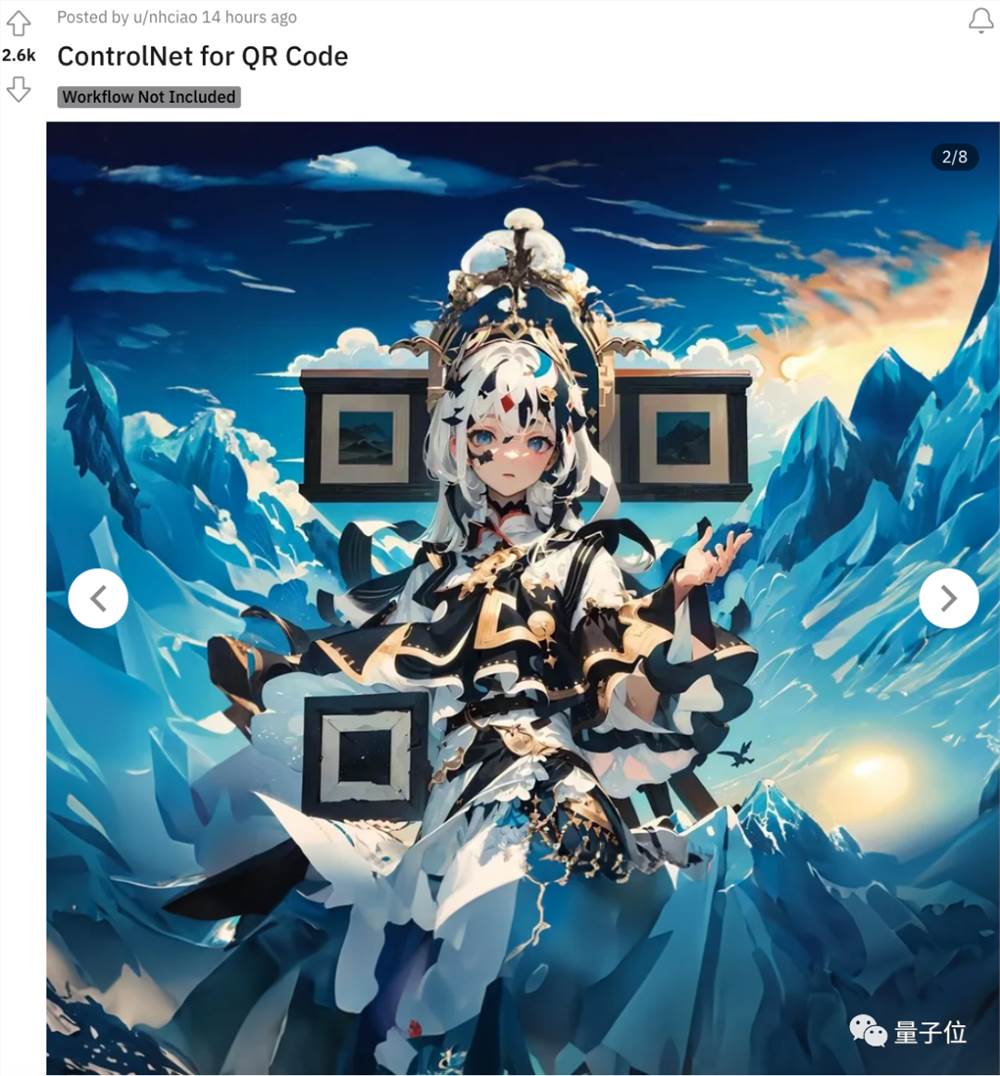

一组神秘的“虚拟老婆”照片,最近在国内外社交媒体上传疯了。

怎么回事?

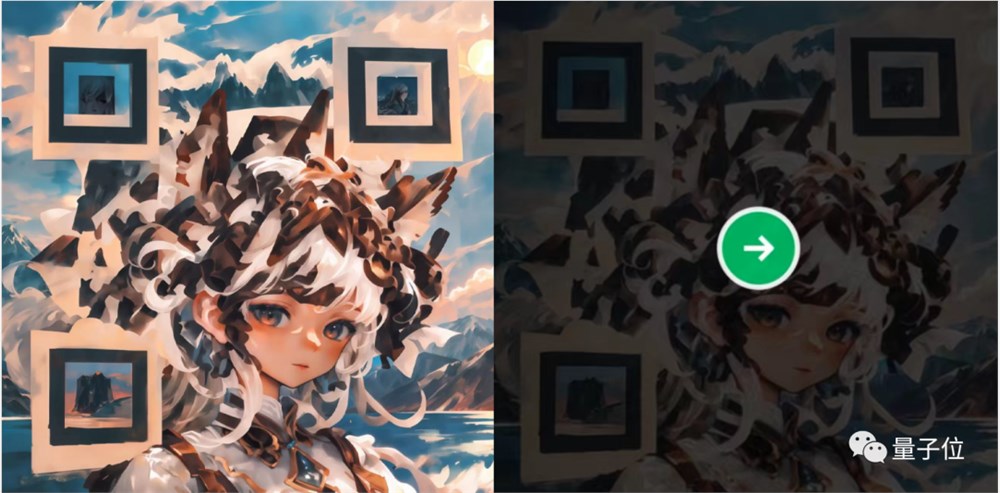

试着用手机扫一下,就能发现其中的玄机——

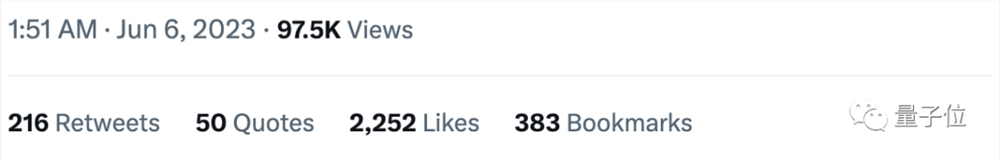

原来这些看起来颇为自然的照片,都是藏了二维码的图像。它们不仅能被手机相机识别,跳转的网站还都是有效的:

从推特到Reddit,每隔几条就能刷出这些二维码照片,下面全是一片“竟然扫出来了”的惊叹声。

最关键的是,这些照片并非手动绘制,而是用Stable Diffusion生成的,背后再一次加持了神奇的ControlNet魔法。

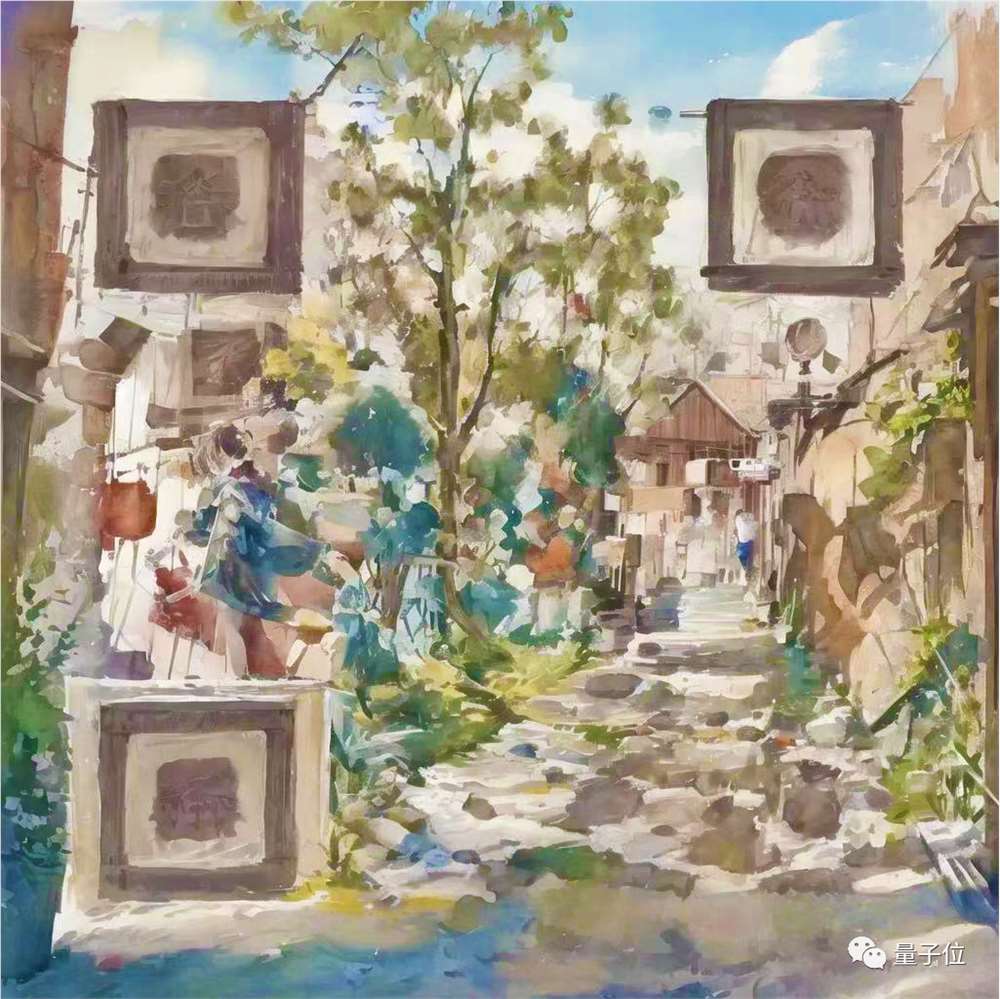

生成的二维码图像风格,也远非只有二次元虚拟人像这一种,一起来看看~

8种图像风格任意可选

除了上述的二次元插(lao)画(po)风格以外,作者们还展示了另外8种二维码图像的生成效果。

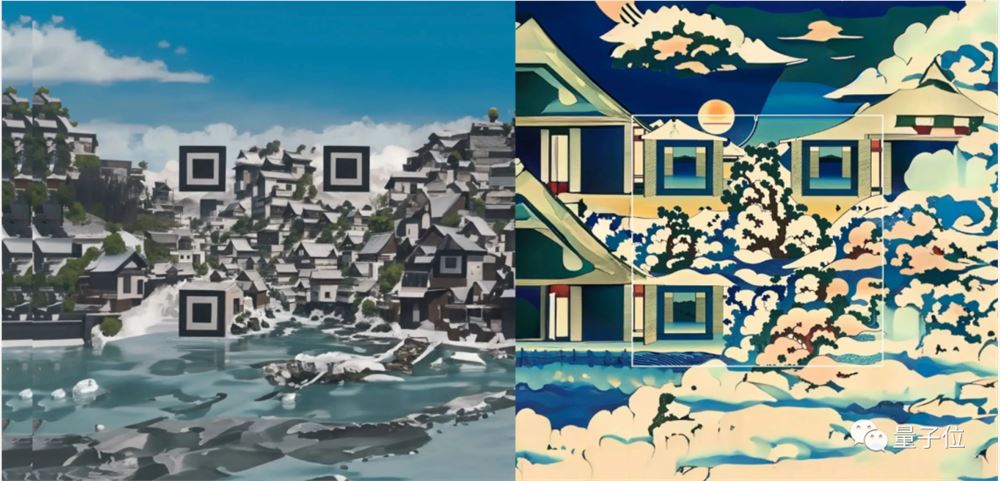

这是立体风格的二维码图像,看起来就像一张真正的城市照片一般:

有网友感叹,简直可以在物理世界中构造一个真的二维码城市了:

甚至它只能在特定的地点、特定的日子、特定的时间被扫出来,有寻宝游戏内味了。

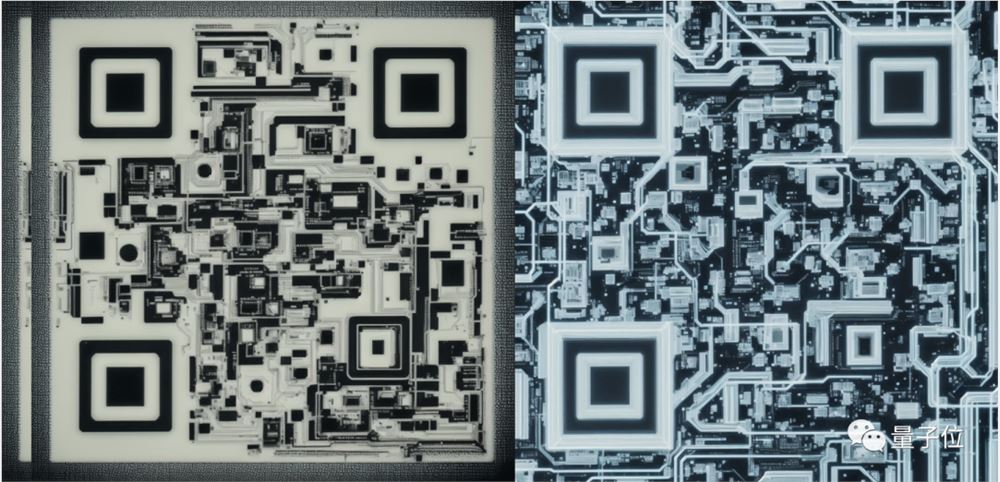

这类立体作品不仅细节可控(如更多的草木植被),还可以改变风格,生成更具机械感的科幻二维码图像:

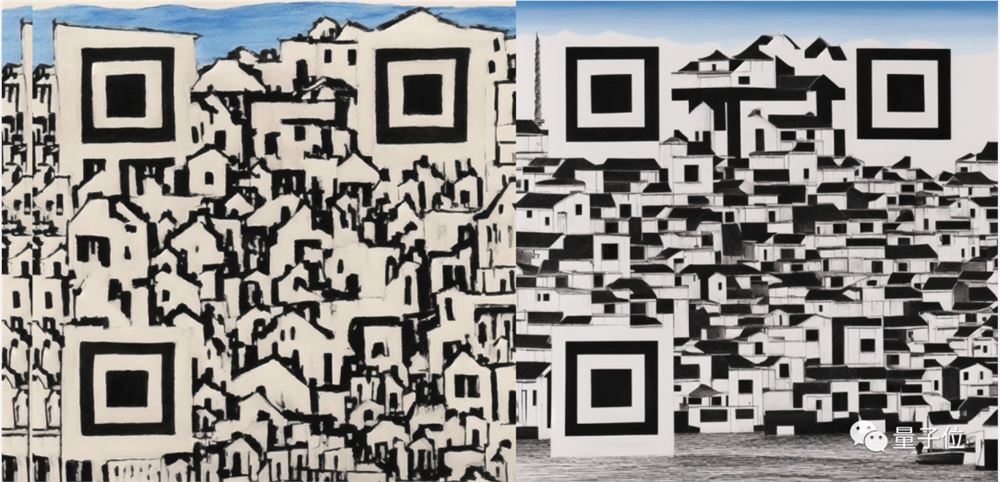

3D城市看得不过瘾,还有2D抽象风格的作品,数据都藏在小房子里了:

除此之外,二维码还能被融入中国传统纹样风格中,或是被巧妙放置在瓷器或壁画一类的装饰物里:

更具艺术性的水墨风格也能hold住,无缝衔接画作笔迹:

又或是这种水彩风格的画作:

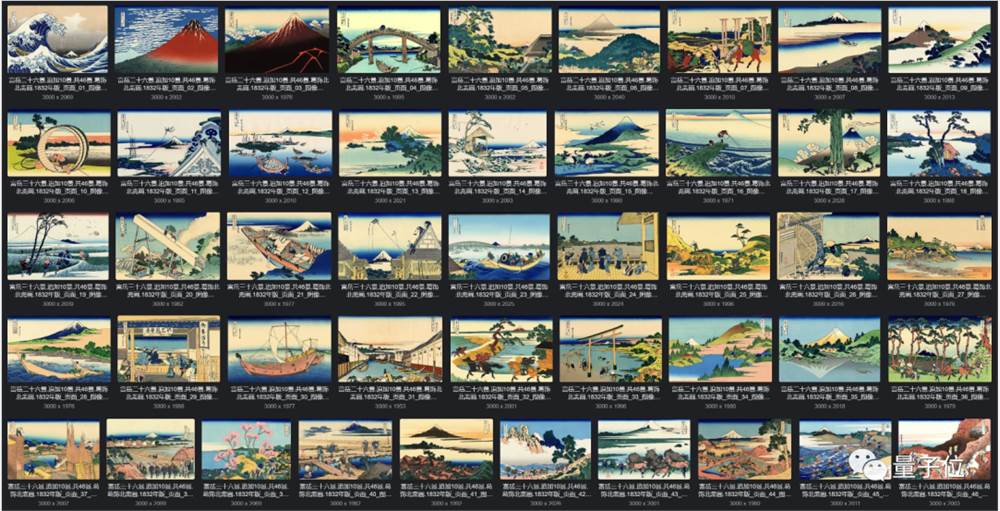

日式的浮世绘风格也没问题:

还能嵌进PCB风格图像里,以后电路板要找售后,直接扫码就行(doge):

显然,除了二维码图像可控,模型就连插画风格都能很好地控制。

这背后究竟是依靠什么技术实现的?

LoRA和ControlNet齐出动

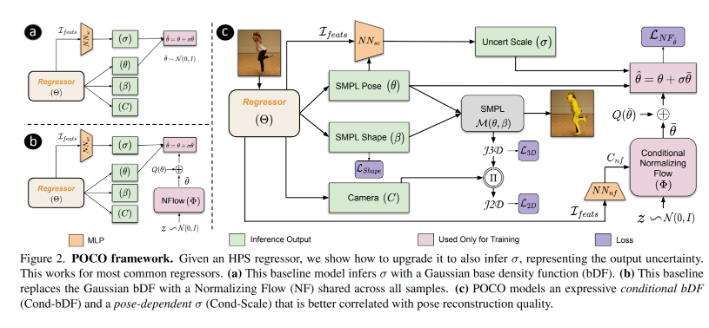

要想实现这种图像风格 二维码可控的效果,需要Stable Diffusion结合LoRA和ControlNet一起实现。

其中,LoRA负责控制整体的图像风格,ControlNet则负责确保二维码“放进”了图像中。

LoRA全称Low-Rank Adaptation of Large Language Models,能很好地实现少样本学习,从而对Stable Diffusion的图像风格生成进行更精准的控制。

换而言之,最少只需要几十张同种风格的图片,就能训练一个LoRA,用来调教Stable Diffusion生成的效果。

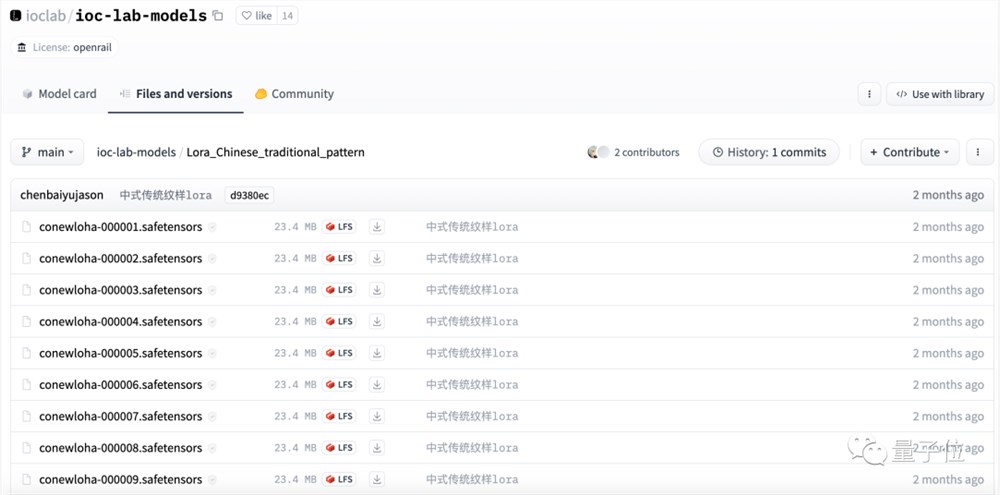

目前,比较有特色的如中国传统风格和浮世绘风格的图像,作者们都已经在Civitai和Hugging Face等平台上开源了对应的LoRA模型。

像浮世绘风格LoRA模型,就已经可以在Civitai上直接下载:

训练这样一个浮世绘风格的LoRA模型,并不需要很多照片,像这个模型就只用了46幅葛饰北斋《富岳三十六景(追加十景)》的浮世绘。

风格变化更加多样的,如生成不同中国传统纹样的图片,也只需要近百张图片训练:

就可以得到能画出不同纹样的LoRA模型:

QR Code ControlNet则是作者们新训练的一个二维码图像生成专用ControlNet模型,目前还在不断优化中。

作者们尝试了不同的Stable Diffusion Checkpoint、LoRA和QR Code ControlNet的组合,生成了上面这些二维码图像的效果。

值得一提的是,结合最近的PS新出的Generative Fill功能,这些二维码还能被很好地嵌进一大块AI生成图像中:

有网友调侃,未来就连广告也会变得更好看了。

作者介绍

制作这个二维码生成项目的作者一共有四位,分别来自中国传媒大学和北京航空航天大学。

其中,倪豪和陈柏宇是中国传媒大学大四本科生,王照涵是中国传媒大学一年级研究生,陈智勇是北京航空航天大学大四本科生。

在这次的AI二维码图像生成项目前,倪豪和陈智勇就已经做出过一个参数化二维码生成器,不过主要采用的还是图形学方面的技术。

据倪豪介绍,他们之前的研究方向主要集中在图形学和交互艺术上,随着这段时间AIGC爆火,团队也对这方面的技术产生了兴趣。

这段时间里,他们开发了不少不同风格的LoRA模型,以及可控制光影的ControNet等,目前模型也都已经放在Civitai上。

团队表示,目前这个二维码图像生成模型还在持续优化中,后续如果有更多的进展更新,也会同步到这个网站上。

可以码住期待一波了~

团队已开发的AI模型:

https://aigc.ioclab.com/index.html

- 0000

- 0000

- 0001

- 0000

- 0000