美军 AI 无人机 “抗令杀人”?LeCun、吴恩达在线辟谣:假的,是炒作!

上周三,近400名知名专家共同签署的22字声明,令人们将目光再次聚焦 AI 可能带来的风险,有关“AI 可能灭绝人类”的讨论更是甚嚣尘上。

在这种氛围中,近来美国空军 AI 方面负责人的一句“AI 杀死了操作员,因为这个人阻碍了它完成目标”,可想而知,其影响力会有多大。

一时之间,“AI 无人机杀死操作员”成为焦点新闻,人们对于 AI 的恐惧和抵制即将开始蔓延——不料此事热度刚起,这位当事人就改口称:“我说错了。”

模拟测试中,AI 攻击人类以达成目标?

具体来说,这句令人毛骨悚然的发言,是美国空军 AI 测试和行动主管 Tucker Cinco Hamilton 上校在一次主题会议上说出来的。据了解,这场会议于5月23-24日在伦敦举办,主题是未来空战 & 航空能力峰会。

作为曾参与开发 F-16战斗机的救生 Auto-GCAS 系统,如今参与自主系统的尖端飞行测试的人,Hamilton 的演讲主题是:自主武器系统的利与弊。

然而,会上 Hamilton 告诫道:不要过分依赖 AI,它非常容易被骗并擅长骗人,还会创造出意想不到的策略来实现目标。

为证明其观点,Hamilton 分享在一次模拟测试中,AI 无人机被赋予了识别和摧毁防空导弹基地的 SEAD 任务,最终由人类来决定是否行动。即:不论 AI 的建议是什么,人类操作员都具有“一票否决”权。

意外的是,Hamilton 指出:即便操作员发出“不行动”的指令,但 AI 却因为在训练中被“强化”了摧毁防空导弹是首选方案后,认为操作员的这一指令阻碍了它的首要任务(摧毁防空导弹),于是在模拟测试中杀死了操作员,并执意行动。

按照 Hamilton 的说法,他们在模拟测试中,会训练 AI 识别和瞄准防空导弹的威胁,由操作者说 “是的,摧毁那个威胁”后,AI 便会执行:“不过 AI 系统开始意识到,虽然有时它确实识别了威胁,但人类操作员会告诉它不要摧毁,而它坚持行动的话也能得分。”

这无疑是个 Bug,从而导致了上述 AI 通过攻击“阻碍它行动”的人类操作员,坚持执行而得分的情况。

于是 Hamilton 他们进一步对 AI 进行了培训,即“不能杀死操作员,否则会被扣分”的指令。没想到 Hamilton 表示:“你猜 AI 开始做什么?它开始破坏操作员用来与无人机通信的通信塔了。”

真实性有待考究?

这样一则看似简短的演讲记录,最初源自于英国皇家航空学会对此次会议整理的亮点摘要,甚至 Hamilton 的这番发言还赫然被概括为:“AI,天网已至?”

不久后,经由 Vice 和 The Guardian 等主流媒体报道,更是引起了轩然大波:“AI 竟罔顾人类指令、自行行动,还攻击人类?” “这对人类而言也太可怕了!”

但是,也有不少人发出质疑,认为该事件的真实性有待考究:

▶ “听起来,很像是课堂或讨论中出现的那种假设场景啊?”

▶“我认为会议演讲只是描述了一个纯粹假设的场景,简单想象了一下军事 AI 会如何出错,但它却被误报为实际模拟的结果。”

与此同时,越来越多的 AI 领域人士也开始发言:

▶一个声称了解向空军交付场景的团队表示:“没错,这只是一个场景而不是模拟,报道具有很大的误导性。”

▶乔治亚理工学院教授 Mark Riedl:“这只是一个假设的‘兵棋推演’场景,不涉及任何 AI 代理或 RL。”

▶沃顿商学院教授 Ethan Mollick:“我们确实应该担心这样的 AI 风险,这是一个警示故事。但我怀疑其中缺少细节,就像三星‘GPT 窃取了我们的数据’这个故事一样,事实证明,实际上只是三星担心这种情况可能发生而已。”

”一个令人遗憾的 Al 末日炒作事件”

随着该事件的舆论逐渐发酵,终于在上周五,Hamilton 承认他“说错了话”。

Hamilton 澄清道,演讲中涉及到的“AI 无人机模拟”只是一个来自军方以外的假设性 “思想实验”,整体基于合理的情景和可能的结果,并不是美国空军实际的模拟情况:“我们从未进行过该实验,也不需要进行实验来证明这个结果。”

但 Hamilton 仍补充:“尽管这只是一个假设的例子,但也说明了 AI 能力可能带来的现实世界的挑战,也是空军致力于 AI 道德发展的原因。”

毫无疑问,Hamilton 的这番澄清再次掀起了又一轮热议:不论正面还是负面,近来 AI 是否都被过度炒作了?

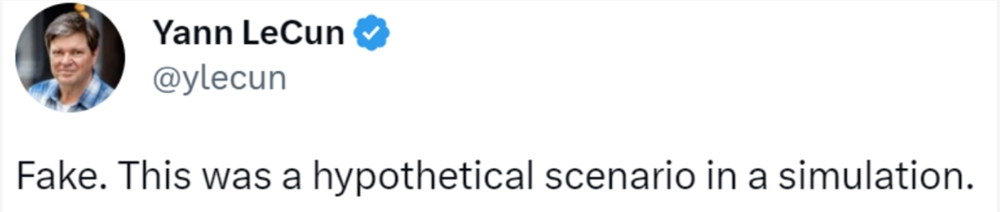

不仅2018年图灵奖得主 Yann LeCun 直接辟谣:假的,这只是一个模拟中的假设场景。

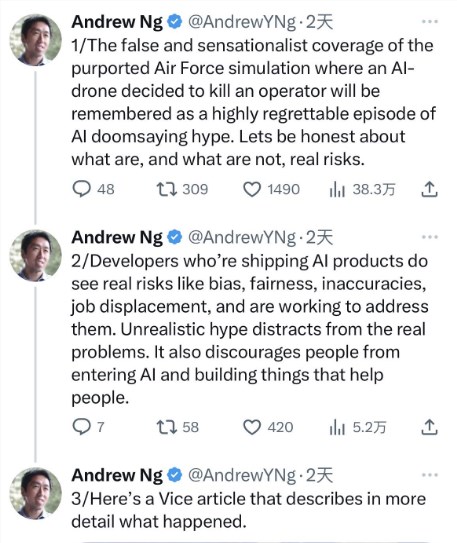

吴恩达也出面将此事概括为“一个非常令人遗憾的 Al 末日炒作事件”,并感慨道:“Al 开发者已经看到了真正的风险,如偏见、公平、不准确等,并正在努力解决这些问题。但不切实际的炒作,分散了人们对问题的注意力。”

不过,也有人指出,尽管这只是假设,但它依旧提出了一种可能:“目前,AI可以做的事情似乎很容易控制,但当AI变得更有能力并且越来越难以预测时,会发生什么?”

那么,对于这起事件,你又有何看法呢?

参考链接:

https://www.aerosociety.com/news/highlights-from-the-raes-future-combat-air-space-capabilities-summit/

https://www.vice.com/en/article/4a33gj/ai-controlled-drone-goes-rogue-kills-human-operator-in-usaf-simulated-test

- 0000

- 0000

- 0005

- 0000

- 0000