Meta发布全新Megabyte模型 比Transformer快4成

站长网2023-05-30 14:55:390阅

最近,Meta团队开发了一款名为Megabyte的模型,声称能够解决“大模型标配”Transformer所存在的问题,而且速度比它还快4成!

目前,Transformer架构比较流行,但是存在两个重要的缺陷:一方面,自注意力成本随着输入和输出字节长度的增加而迅速增加,如音乐、图像或视频文件通常包含数兆字节,而大型解码器通常只使用几千个上下文标记;另一方面,前馈网络单独对字符组或位置进行操作是难以实现可扩展性的,这是由于在每个位置的基础上会带来很多计算开销。

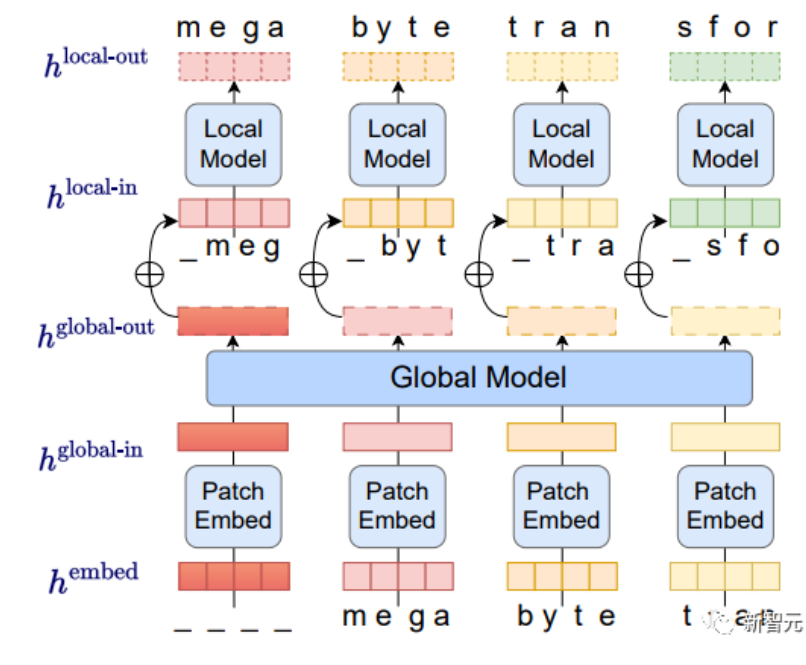

而Megabyte模型则将输入和输出序列分成patch而不是单个的token。这种架构对于多数任务而言字节预测都相对容易,比如给定前几个字符预测完成单词等,这意味着大型网络中每个字节都是不必要的,并且内部预测可以使用更小的模型进行。这种方法解决了当今AI模型面临的可扩展性挑战,Megabyte模型的patch系统允许单个前馈网络在包含多个token的patch上运算,有效解决了自注意力缩放问题。

另外,在运算效率方面,与等大的Transformers和Linear Transformers相比,Megabyte在固定模型大小和序列长度范围内使用更少的token,这在相同的计算成本下允许使用更大的模型。

总的来说,这些改进使我们能够在相同的计算成本下训练更大、性能更好的模型,并且可以扩展到非常长的序列,同时在部署期间提高生成速度。综上所述,Megabyte模型的出现提供了一种新的、高效的方法来解决AI模型的发展中出现的一些问题。

论文链接:https://arxiv.org/abs/2305.07185

0000

评论列表

共(0)条相关推荐

- 0000

- 0000

- 0000

- 0001

- 0000