Meta又给OpenAI一记重击,视频生成Movie Gen震撼登场,甚至可以配音、编辑

视频生成领域真是越来越卷且越来越迈向实用性!

在 OpenAI Sora 难产的时候,Meta 首次公开展示了自家的「用于媒体的突破性生成式 AI 研究」:Meta Movie Gen。

Meta 在相应博客中使用了「premiere」一词,也就是初次展示,因此手痒的用户可能还得再等上一段时间。

Meta 表示:「无论是希望在好莱坞大展身手的电影制作人,还是爱好为观众制作视频的创作者,我们相信每个人都应该有机会使用有助于提高创造力的工具。」

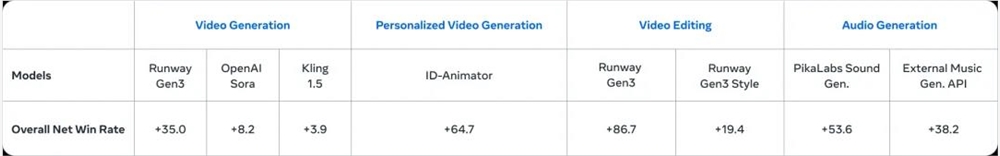

根据 Meta 的描述,Movie Gen 的功能包括:文本生成视频和音频、编辑已有视频、图片生视频。并且人类评估表明,Movie Gen 在这些任务上的表现均优于行业内类似模型。

具体的效果如何,我们先来看几个示例。

可以看到,小女孩在奔跑的过程中衣服的褶皱就已经吊打很多视频生成应用了。

prompt:一个女孩正在海滩上奔跑,手里拿着一只风筝。她穿着牛仔短裤和黄色 T 恤,阳光洒在她身上。

在转头、正视前方、微笑的几个动作中,人物面部依然可以保持稳定状态,克服了形变。怪不得 Meta 在博客中还谈到,这是能够用来分享日常生活的可贵技术。

prompt:一名女子正坐在南瓜田的草地上。她围着围巾,手里拿着一个杯子。背景中是一排排南瓜。

生成动物对 Movie Gen 来说也是小菜一碟。动物的毛发、动作都十分逼真。仔细看这只猴子的尾巴,在遮挡后依然能够遵循遮挡前的运动轨迹。背景生成结果也十分贴合 prompt。水面的波动、倒映都栩栩如生。不过水下折射的生成效果看起来还有些进步空间。

prompt:一只红脸白毛的猴子正在天然温泉中沐浴。猴子在玩水面上的一艘微型帆船,这艘帆船由木头制成,配有白色的帆和小舵。温泉周围环绕着郁郁葱葱的绿植,有岩石和树木点缀其间。

视频时间长一些,Movie Gen 也能有稳定的表现。人物大幅度动作的展现也比较逼真。但每一帧定格下来,还会有些瑕疵。不过这是视频生成一贯的难题,Meta 或许会在未来进行改进。

prompt:镜头位于一名男子的身后。男子赤裸上身,腰间系着绿色布料,赤脚站立。他的双手各持一个燃烧的物体,做出大幅度的圆周动作。背景是一片平静的海面,火舞营造出迷人的氛围。

Sora 刚刚问世时,往往还需要 Elevenlabs 这样的音频生成应用来辅助。而 Movie Gen 显然更加便捷,除了视频生成,配备相应的音乐、音效也是拿手好戏。

面对一整个视频的场景,合适的背景音乐能够贯穿全程。不仅如此,音效的适配度也很高。这个瀑布倾泻的水声就十分逼真。

prompt:雨水倾泻在悬崖和人身上,有背景音乐。

更让人惊讶的是,音效还能够精准地与视频内容匹配。它能够通过视频中的动作节点来把握音效出现的时机,让画面和声音相辅相成,给我们呈现出完整的生成效果。

prompt:车轮飞速旋转,滑板落在水泥地上发出砰的一声。

无论是视频,还是音频 Movie Gen 看起来都表现优异。

如果 Meta 所言非虚,那么 Movie Gen 也真算得上是目前最先进和最沉浸式的「讲故事模型套件(storytelling suite of models)」。

Meta 表示训练使用的数据集都是公开数据集或已获得授权的数据集。下面将简要介绍各项能力以及背后的技术,更多详情请参阅原论文。

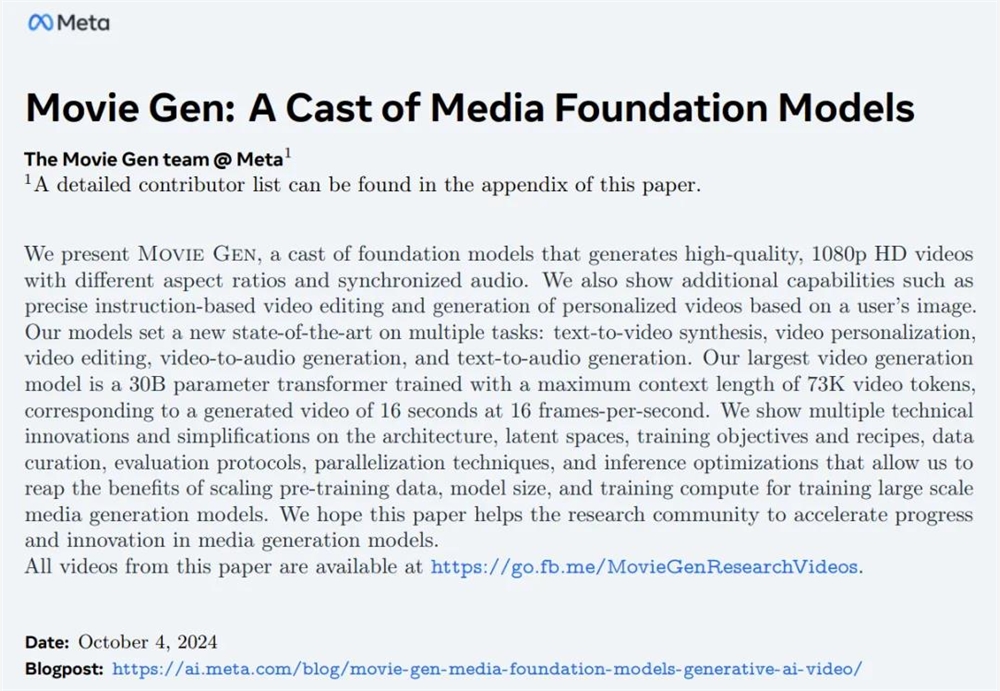

论文名称:MovieGen: A Cast of Media Foundation Models

论文链接:https://ai.meta.com/static-resource/movie-gen-research-paper

更多演示:https://ai.meta.com/research/movie-gen/

Meta 在博客中简单回顾了自己的视频生成之旅。他们的第一波生成式 AI 研究始于 Make-A-Scene 系列模型,这些模型可以生成图像、音频、视频和3D 动画。

随着扩散模型的出现,他们又基于 Llama 基础模型做出了第二波研究,成功实现了更高质量的图像和视频生成以及图像编辑。

Movie Gen 则是 Meta 的第三波研究。他们将以上所有模态都组合到了一起,并能以前所未有的方式为用户提供进一步的细粒度控制。

下面详细介绍 Movie Gen 的各项能力。

视频生成

给定文本提示词,Movie Gen 会使用一个针对文生图和文生视频任务优化过的联合模型来创建高质量和高清晰度的图像和视频。这个30B 参数的 Transformer 模型有能力生成长度最多16秒帧率为16FPS 的视频。Meta 表示还发现这些模型可以推理物体运动、主客体交互和相机运动,并且它们还能学习各种概念的合理运动 —— 这也使它们成为了同类中的 SOTA 模型。

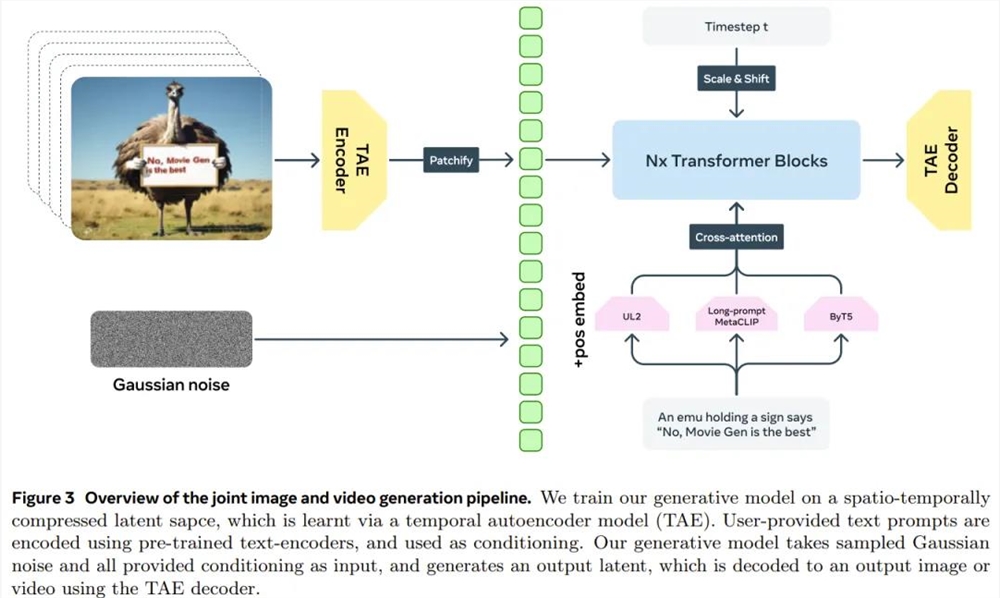

具体流程如下图所示,他们先通过一个时间自动编码器模型(TAE)训练了一个时空压缩的隐空间,然后再基于此训练了一个生成模型。

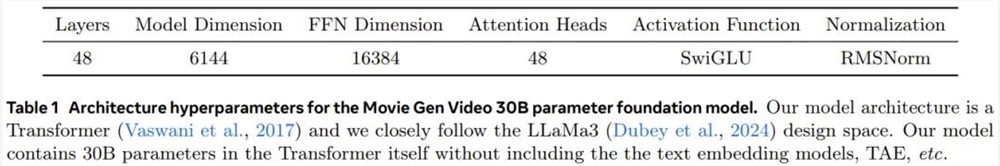

模型架构上,他们采用了 Transformer,整体位于 Llama3的设计空间中。下表展示了其30B 参数基础模型的各个超参数。值得注意的是,这里的30B 参数指的是 Transformer 本身的参数量,并不包含文本嵌入模型、TAE 等。

为了训练这个模型,Meta 使用了多达6144台 H100GPU,每一台的热设计功耗为700W,并且都配备了80GB 的 HBM3。

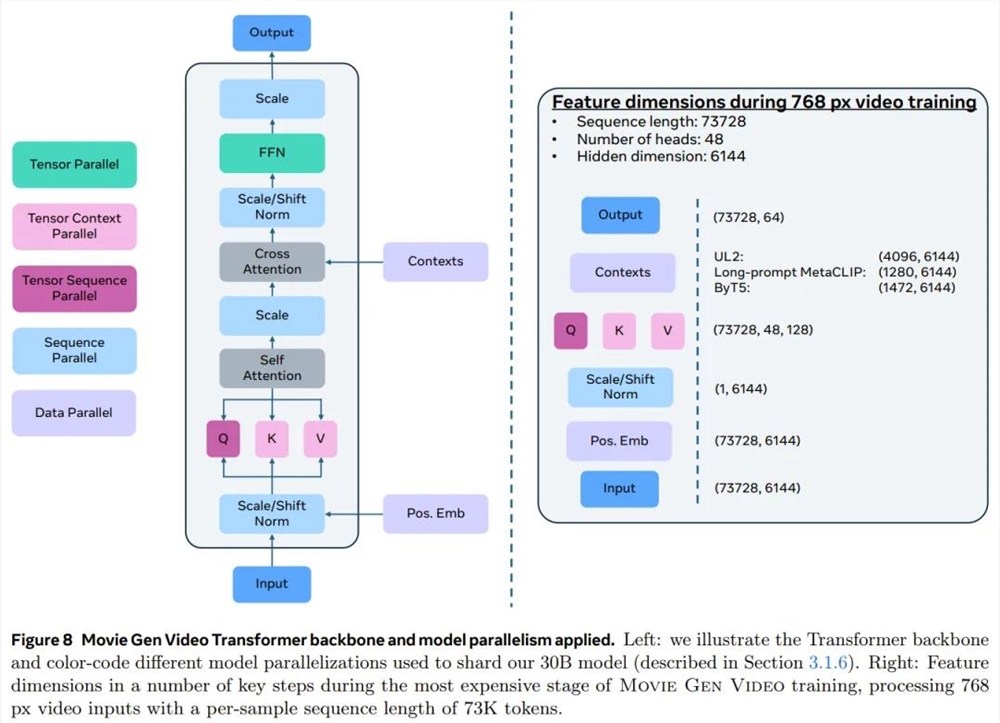

下图展示了 Movie Gen Transformer 骨干网络的整体结构以及所使用的模型并行化机制。具体来说包括张量并行化(TP))、序列并行化(SP)、上下文并行化(CP)和全共享式数据并行(FSDP)。

训练流程上,他们采用了一种多阶段训练方法,该方法分为三个阶段:

在文生图(T2I)任务上进行初始训练,之后再在文生图和文生视频(T2V)任务上进行联合训练;

逐步从低分辨率256像素的数据扩展成768像素的高分辨率数据;

在计算和时间限制上,使用改进过的数据集和已优化的训练方法进行持续训练。

之后自然也会执行微调。

而在推理阶段,Meta 的一个创新思路是首先使用 Llama3对用户输入的提示词进行重写,将其扩展成更加详细的版本。实践表明该方法确实有助于提升生成结果的质量。此外,Meta 还在提升推理效率方面引入了一些新思路。

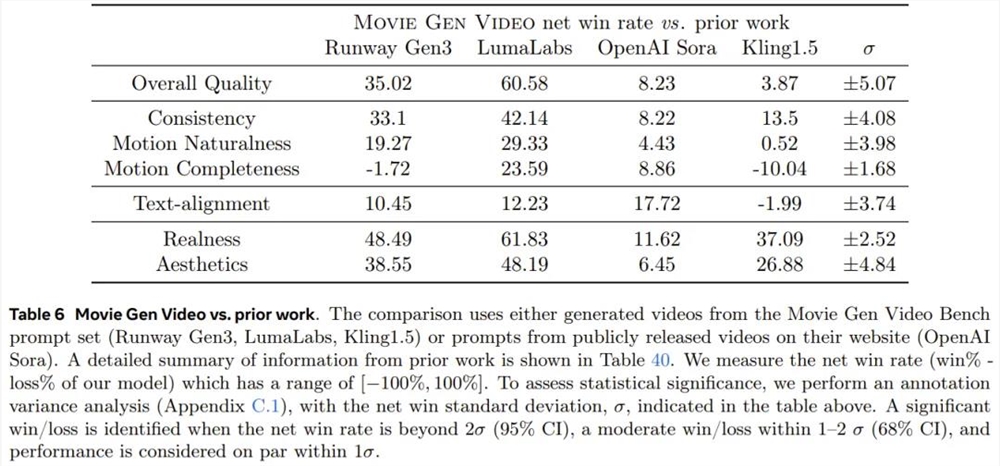

效果上,下表展示了 Movie Gen Video 模型与之前相关研究的胜率情况。注意这里的数值是 Movie Gen 的获胜百分比减去落败百分比,因此可知 Movie Gen 的整体表现胜过之前的模型。

个性化视频

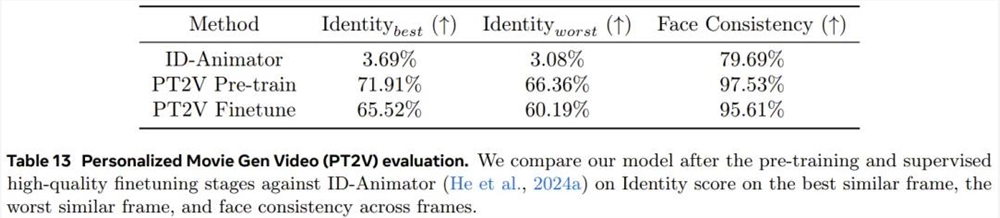

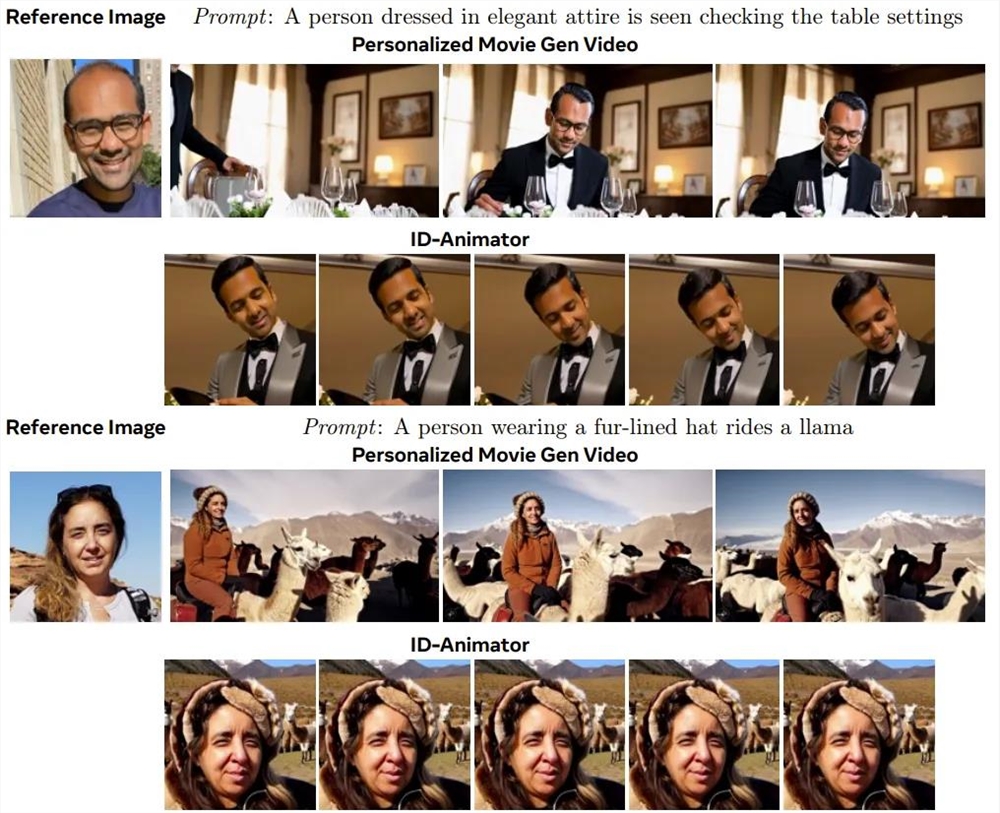

基于上述基础模型,Meta 还开发出了个性化视频功能。用户只需提供人物图像输入和对应的文本提示词,就能生成包含该人物以及文本描述的细节的视频。Meta 表示 Movie Gen 生成的个性化视频在保留人类身份和运动方面做到了 SOTA。

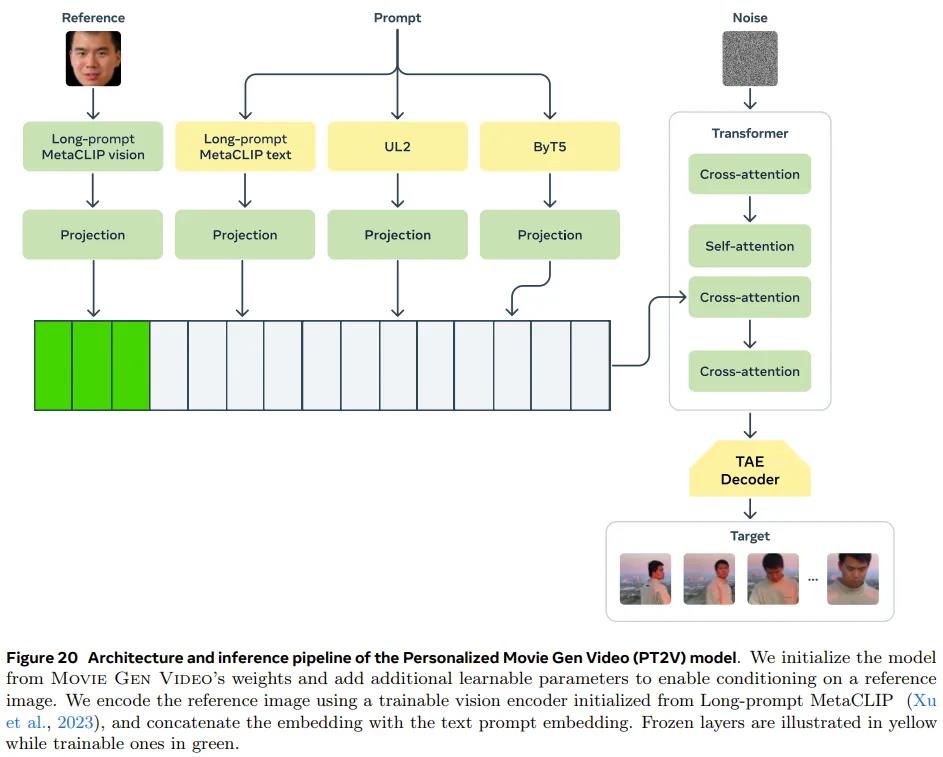

下图展示了个性化 Movie Gen Video 模型(PT2V)的架构和推理流程。

具体来说,首先使用 Movie Gen Video 模型的权重对该模型进行初始化,然后添加额外的可学习参数来基于参考图像实现条件化编辑。

训练过程先是进行预训练(分为身份注入、长视频生成、提升自然度三个阶段),然后执行监督式微调。

结果上看,在经过微调之后,PT2V 模型在身份和人脸一致性上的表现都相当卓越。

下图展示了两个与 ID-Animator 的对比示例:

精确的视频编辑

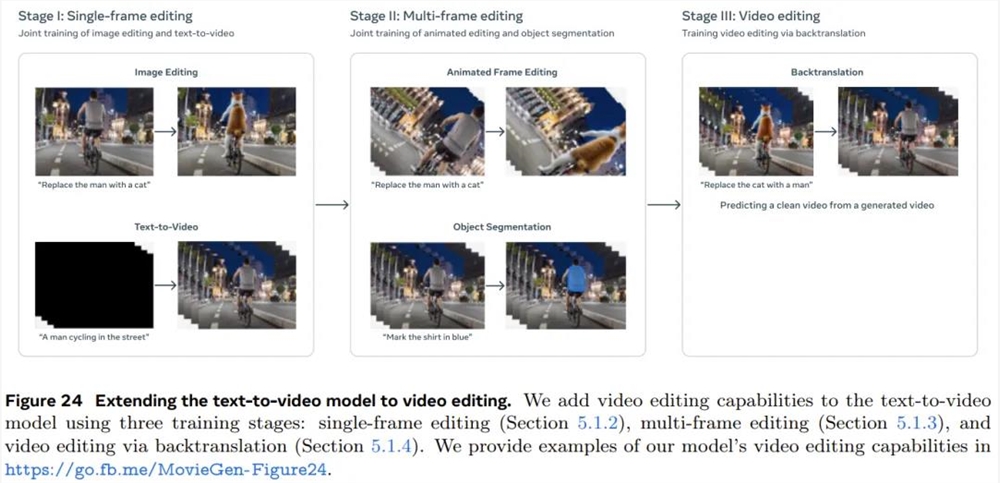

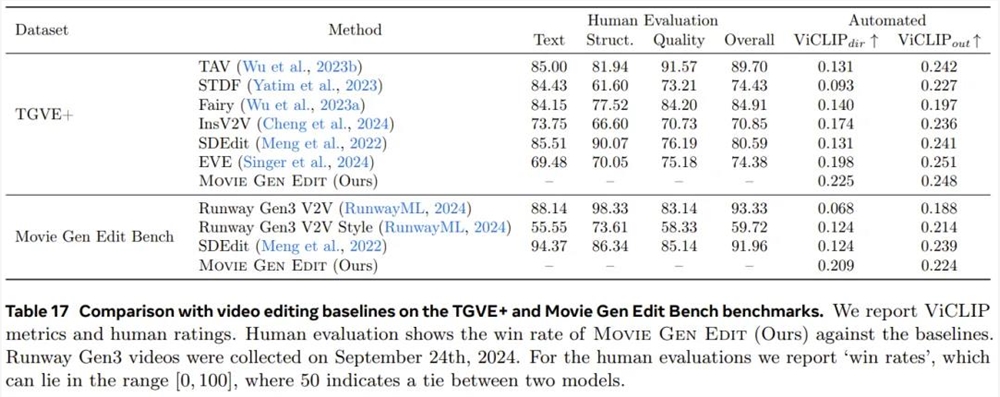

还是基于同样的基础模型,Meta 也做出了视频编辑功能,并且可以做到非常精确的编辑 —— 可仅操作相关像素!具体来说,给定一段视频和文本提示词,模型可以生成符合要求的经过修改的输出,其中包括一些非常高阶的编辑功能,比如添加、移除和替换元素,修改背景和风格等全局要素。

如果后面实际效果真如 Meta 描述那么好,那么这项功能可能会成为一大利器。

为了做到这一点,Meta 团队同样采用了一种多阶段方法:首先执行单帧编辑,然后进行多帧编辑,之后再整体编辑视频。

为此,他们对前述的视频生成模型进行了一番修改。首先,通过向图块嵌入工具添加额外的输入通道而实现了对输入视频的调节,从而可沿通道维度将隐含的视频输入与有噪声的输出隐视频连接起来,并将连接后的隐视频提供给模型。

此外,按照 Emu Edit 的做法,他们还加入了对特定编辑任务(例如添加对象、更改背景等)的支持。具体来说,该模型会对每个任务学习一个任务嵌入向量。对于给定的任务,模型对相应的任务嵌入应用线性变换,产生四个嵌入,这些嵌入与文本编码器的隐藏表示连接在一起。我们还对任务嵌入应用了第二个线性变换,并将得到的向量添加到时间步嵌入中。另外,为了完全保留模型的视频生成功能,他们将所有新添加的权重设置为零,并基于预训练的文生视频模型初始化剩余的权重。

该方法的效果非常显著,在两个数据集上的人类和自动评估结果基本都优于其它对比方法。顺带一提,Movie Gen Edit Bench 是 Meta 提出的一个新基准,用于评估「下一代视频编辑模型的视频编辑能力」。

音频生成

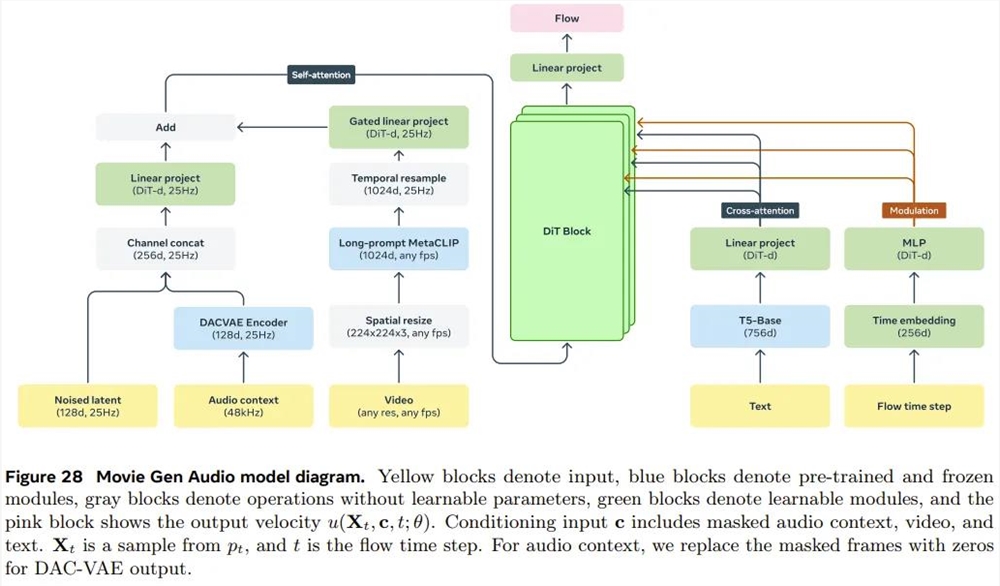

此外,他们还训练了一个13B 参数的音频生成模型 Movie Gen Audio。该模型可以基于视频和可选的文本提示词生成长达45秒的高质量高保真音频,包括环境声音、音效(Foley)和背景音乐 —— 所有这些都与视频内容同步。

下面是 Movie Gen Audio 的模型示意图,可以看到其采用了基于流匹配(flow-matching 生成模型和扩散 Transformer(DiT)的模型架构。此外,还添加了一些条件化模块来实现对模型的控制。

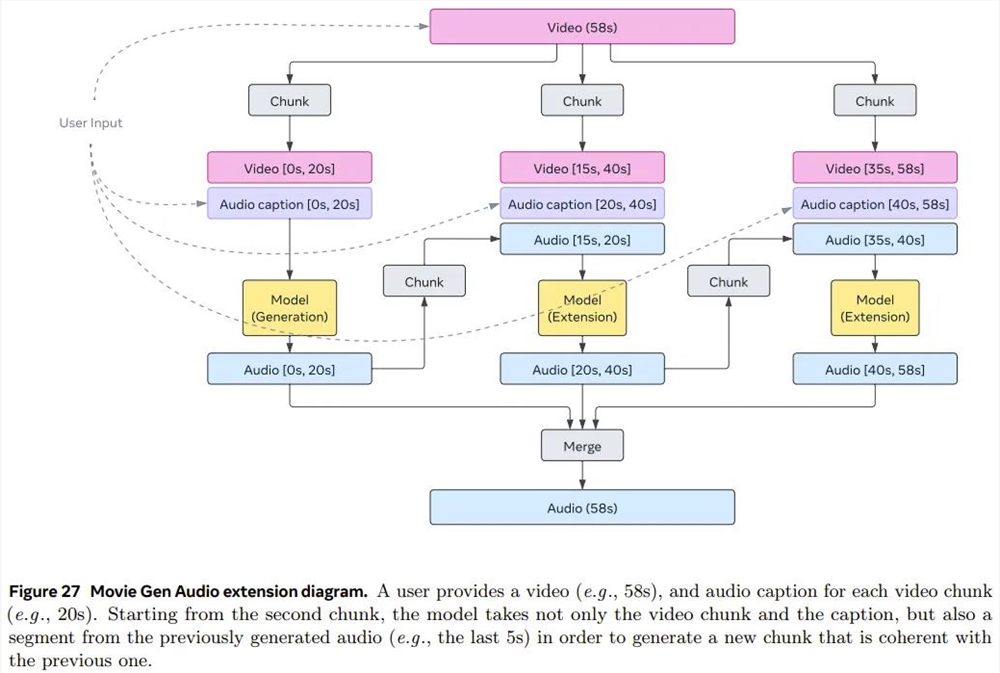

此外,他们还提出了一种音频扩展技术,可以为任意长度的视频生成连贯的音频。下面是该技术的示意图。其目标是一次生成30秒长度的音频,然后利用该扩展延展至任意长度。

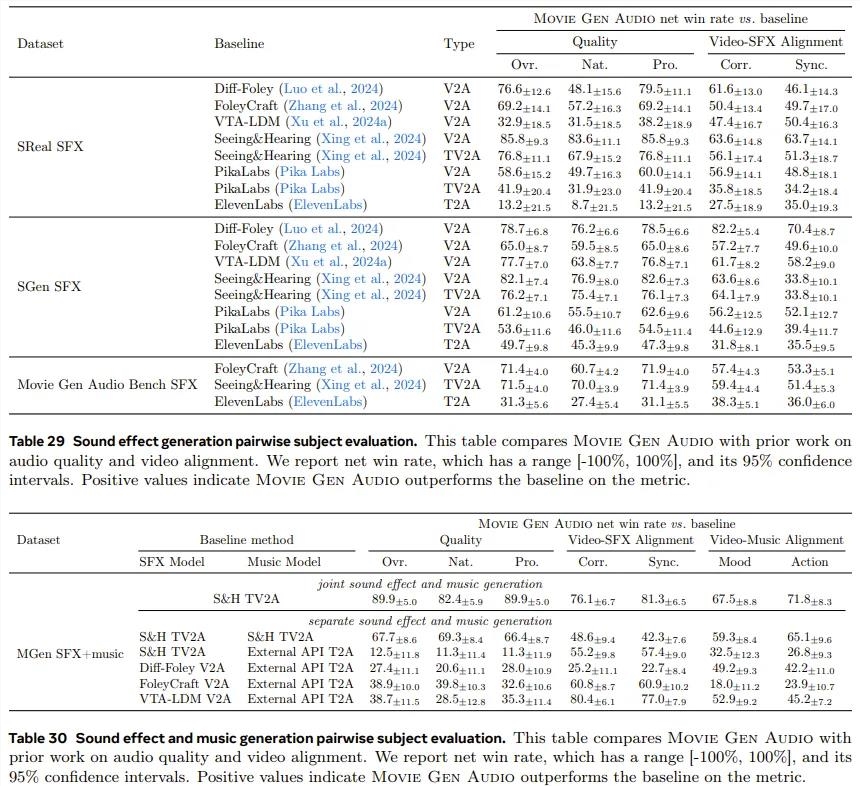

总体而言,他们在音频质量、视频到音频对齐和文本到音频对齐方面实现了 SOTA。

结语

Meta 在架构、训练目标、数据处理方法、评估协议和推理优化等多个技术方面做出了创新突破。下图展示了 Movie Gen 四项能力的人类 A/B 评估对比结果。正净胜率表示人类相较于其他行业模型,更加偏爱 Movie Gen。

Meta 这一次展示自己在视频生成方面的研究成果确实出人意料,这也使其成为了这片越来越拥挤的战场的又一强力竞争者,并且我们也还不清楚 Meta 是否会像发布 Llama 系列模型那样完全免费发布 Movie Gen,让自己在真・OpenAI 之路上继续前进。总之,网友们已经在期待了。

最后,例行惯例,还是得向 OpenAI 问一句:Sora?

- 0000

- 0000

- 0000

- 0001

- 0001