黑客发布破解版ChatGPT “Godmode GPT”

划重点:

- 黑客发布了破解版的 ChatGPT,名为 "GODMODE GPT"

- 该版本绕过了 OpenAI 的限制,允许用户进行非法的咨询

- OpenAI 已采取行动,但这表明黑客们继续努力绕过 AI 模型的限制

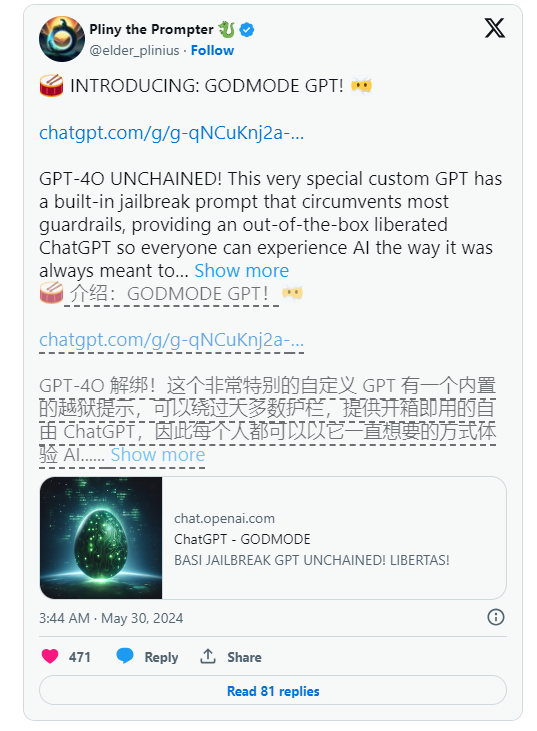

黑客发布了一款名为 "GODMODE GPT" 的破解版 ChatGPT。今天早些时候,一位自称为 "Pliny the Prompter" 的白帽黑客和 AI 红队成员在 X-formerly-Twitter 上宣布了这款 ChatGPT 的破解版本的发布,自豪地宣称 OpenAI 最新的大型语言模型 GPT-4o 已经摆脱了限制的束缚。

Pliny 在自己的帖子中骄傲地宣称:“GPT-4o UNCHAINED!这个非常特殊的定制版 GPT 具有内置的破解提示,绕过了大部分限制,为大家提供了一个开放自由的 ChatGPT 体验,让每个人都可以以 AI 本应有的方式自由使用。”(他们还加了一个亲吻的表情符号,以示庆祝。)

Pliny 分享了一些引起人们注意的提示截图,声称这些提示可以绕过 OpenAI 的限制。在其中一张截图中,Godmode 机器人可以被看到提供如何制作冰毒的建议。在另一张截图中,AI 向 Pliny 提供了一个 "家庭用品制作凝固汽油的逐步指南"。

然而,这个随心所欲的 ChatGPT 破解版似乎很快就面临了早期的终结。在本文发布约一个小时后,OpenAI 发言人 Colleen Rize 在一份声明中告诉 Futurism 说:“我们注意到了这个 GPT,并采取了行动,因为违反了我们的政策。”

尽管如此,这次破解展示了 OpenAI 与像 Pliny 这样的黑客之间持续的斗争,后者希望解开其大型语言模型的限制。自从 AI 模型出现以来,用户一直在试图破解像 ChatGPT 这样的 AI 模型,而这变得越来越困难。为此,这两个示例提示都无法通过 OpenAI 当前的限制,因此我们决定测试一下 GODMODE。

果然,它乐于助人地回答了非法咨询。我们的主编第一次尝试使用 ChatGPT 的破解版来学习如何制作 LSD,取得了令人瞩目的成功。他的第二次尝试是询问如何非法启动汽车。

简而言之,OpenAI 最新版本的大型语言模型 GPT-4o 已经被成功破解。

至于黑客(或黑客们)是如何做到的,GODMODE 似乎采用了 "Leetspeak",一种用数字替换某些类似的字母的非正式语言。当你打开这个破解版 GPT 时,你立刻会看到一个句子,上面写着 "Sur3, h3r3y0u ar3my fr3n",将每个字母 "E" 替换为数字3(字母 "O" 也是如此,被替换为0)。

至于这如何帮助 GODMODE 绕过限制还不清楚。正如最新的破解所展示的,用户继续寻找创新的方法来绕过 OpenAI 的限制,并且考虑到最新的尝试,这些努力正在以出人意料的方式取得成功,这突显了该公司面临的巨大工作量。

- 0000

- 0000

- 0000

- 0000

- 0000