神预测!人类对AI的各种态度,被这部电影说中了

编者按:

OpenAI CEO Sam Altman最近接受美国国会山问讯,和周受资受到的待遇完全相反,国会山议员们不是步步紧逼,而是纷纷拿起小本本,认真记下Sam Altman公开发表的人工智能发展潜在危险。这是为什么?

当我们谈论人工智能时,有哪些问题可能是正被忽略的?

以上正和今天我们要分享的这篇译文相关。

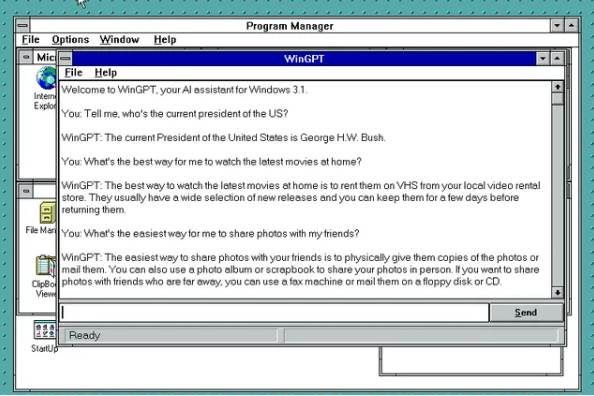

不久前,麻省理工学院AI研究教授Max Tegmark发文《“不要抬头”思维可能会让我们在人工智能方面陷入困境》,引用电影《不要抬头》中人们应对世界末日的不同反应,总结并点评了目前人们对人工智能崛起的各种态度。

《不要抬头》是2021年圣诞由小李子、大表姐、甜茶、A妹等大咖出演的一部讲述“世界末日”的热门影片,一上映就成为Netflix史上播放量第二的电影。

电影中,由小李子和大表姐饰演的两位天文学家发现一颗巨大的行星正向地球高速飞来,并有10%的可能性毁灭地球。他们将威胁告知总统,总统却听腻了各种世界末日论,只想专注选举。无奈之下他们上电视、发布社交媒体,却被恶搞成发疯了的世界末日科学家。然而,当天空中的黑球终于肉眼可见,恐慌也随之爆发。各国政府进入紧急模式,研究出可以阻挡行星撞击地球的“零计划”。资本家却在这时发现,行星撞击地球会产生一种可以给他们创造巨大财富的物质,于是成功说服政府放弃“零计划”。最后地球毁灭,在另一个荒芜的星球,幸存的顶层政治家和资本家们走出太空舱,在这个新的星球继续他们的故事......

Max Tegmark认为,这部电影中人们对待行星撞地球警告的态度,与今天人们对待超级人工智能威胁时的态度如出一辙。

时代杂志于4月25日刊登了这篇文章。不仅如此,文章发到推特上仅3分钟,马斯克现身评论:“确实如此”。

2022年底至今,ChatGPT和其他AI应用让全球沉浸在对人工智能的狂热中。至于超级人工智能可能带来的威胁,却总被付诸笑谈,即使马斯克、巴菲特等科技圈内圈外人士不断呼吁,希望大家警惕AI发展过快会带来的危险。今年4月底,深度学习之父杰夫-辛顿(Geoffrey Hinton)甚至为了能自由谈论AI安全问题,选择了离开Google。

总的来说,这是个未雨绸缪但值得一聊的话题。以下为正文:

假设,我们发现一颗巨大的小行星正向地球运行而来。一半的天文学家认为它至少有10%的可能造成人类灭绝。就像大约6600万年前,一颗类似的小行星导致了恐龙的灭绝。

从学术会议到好莱坞大片,我们已经有了长时间对这种威胁的思考,以及如何应对它的历史。所以你认为人类会立即发起一个偏转指令,将它引导到一个更安全的方向。

可悲的是,我觉得我们正在经历另一个《不要抬头》式危机:不受控的超级人工智能危机。

我们可能很快就要与比我们更聪明的“思维”分享地球,但这个即将产生的更聪明的“思维”对我们的关注,可能比我们对猛犸象的关注还要少。

最近的一项调查显示,一半的人工智能研究人员认为,人工智能造成人类灭绝的可能性至少有10%。你可能会同样期望人类立即发起一个指令,把人工智能引导到一个更安全的方向。但目前世界上最有影响力的回应却是否认、嘲讽和认命。现实的黑暗和滑稽应该拿个奥斯卡奖。

《不要抬头》在我的科学界同行中很受欢迎。许多人说它是他们最喜欢的电影,为他们多年来被忽视的科学关切和政策建议提供了戏谑的宣泄。影片里,科学家们提出的能拯救地球的计划未能引起媒体的注意,也无法与商业说客、政治权宜之计和“小行星否认”相对抗。

虽然这部电影是为了讽刺人类对气候变化漫不经心的反应,但现在更好地反映了人类对人工智能崛起的反应。

以下是我对当前人工智能崛起反应的注释性总结:

“没有小行星”

许多公司正在努力开发AGI(人工通用智能),它被定义为“能够学习和执行人类可执行的大多数智力任务,包括AI开发”。下面我们将讨论,为什么这可能会迅速导致超级智能,也就是“远远超出人类水平的通用智能”。

我经常被告知通用人工智能和超级智能不可能发生,因为人类水平的智能是一种神秘的东西,只能存在大脑中。这种碳族主义忽略了AI革命的一个核心要点:智能与信息处理有关,信息无论是被大脑中的碳原子还是计算机中的硅原子处理都无关紧要。

AI在完成任务上的表现一直在超越人类,所以我请碳族主义者停止改变目标,并公开预测哪些任务是AI永远无法完成的。

“它不会在近期撞击我们”

2016年,吴恩达(Andrew Ng)有句名言:“今天担心人工智能就像担心火星上的人口过剩。”

直到最近,大约一半的研究人员预计通用人工智能至少还要等几十年。人工智能教父杰夫-辛顿(Geoff Hinton)告诉哥伦比亚广播公司:“直到最近,我认为我们要在20到50年后才能拥有通用人工智能。而现在,我认为可能是20年或更短,5年甚至都有可能。”

他并不是一个人。微软最近的一篇论文认为,GPT4已经显示出通用人工智能的“火花”。

深度学习先驱Yoshua Bengio认为,GPT4基本通过了图灵测试,而图灵测试曾被视为通用人工智能到达的测试。

而从通用人工智能到超级智能的时间可能不会很长,根据一个著名的预测,它可能需要不到一年的时间。超级智能不是一个遥远的问题,它甚至比气候变化和大多数人的退休计划来得更早。

“提到小行星会分散对更紧迫问题的关注”

在超级智能出现,甚至对人类的产生灭绝性威胁之前,人工智能可能会产生大量其他“副作用”:偏见、歧视、隐私丧失、大规模监视、失业、不断增长的不平等、网络攻击、致命自主武器扩散、人类“被黑”、人类意识变弱甚至意义丧失、缺乏透明度、(由于骚扰、社交媒体上瘾、社会隔离、社交互动的非人性化等)产生的心理问题以及(由于极化、虚假信息和权力集中)而产生的对民主的威胁。

我支持我们对这些问题的关注,但这并不意味着我们可以因此不谈论超级智能对我们的生存威胁。对生存威胁的讨论并不会分散我们对这些“副作用“的注意力。

但如果不受控的超级智能在未来几十年导致人类灭绝,那么所有其他风险也都将不再是问题。

“小行星在撞击我们之前,就会停下来”

大多数认真对待通用人工智能的人似乎都会同时感到害怕和兴奋。但他们总是只谈论人工智能的其他风险,而不是房间里的大象:超级智能。

大多数媒体、政治家和人工智能研究人员几乎都没有提到它,好像科技发展会以某种方式长期停滞在通用人工智能水平上。他们好像已经忘了欧文-J-古德( Irving J. Good)很早以前就提出的简单反驳:

“一个超级智能机器被定义为,一种可以远远超越任何聪明人的所有智力活动的机器。由于机器的设计是这些智力活动之一,一个超级智能机器就能设计出更好的机器;那么毫无疑问就会出现“智能爆炸”,人类的智能将远远落后于机器……”

递归式自我改进的基本理念当然不是什么新鲜事:使用今天的技术来构建明年的技术,这解释了很多指数式技术增长的例子,包括摩尔定律。

人工智能发展的新颖之处在于,通用人工智能的发展允许越来越少的人类参与,甚至导致最后没有人类。这可能会大大缩短多重翻倍的时间尺度:从典型的人类研发数年时间尺度,到机器研发几周或几小时的时间尺度。这种指数式增长的最终限制不是由人类智慧设定的,而是物理定律——物理定律将一团物质的计算能力的限制比今天的最先进水平多出四百万亿倍。

“小行星会几乎停住”

值得注意的是,不仅是非技术人员,大量从事人工智能和人工智能安全工作的专家,也对超级智能表现出否认。

大多数人工智能研究人员(包括安全和伦理研究)都从大科技公司获得资金,或是直接间接地接收科技慈善家的非营利性捐款。但我相信,他们对超级智能将会出现的否认也有更多无辜的解释,比如在充分研究后的可得性偏见。

可得性偏见让人很难看清眼前的威胁,和后面更大的威胁。例如,我经常听到这样一个有趣的观点:大型语言模型(LLM)不太可能会快速递归地自我改进。但I.J.Good上述的智能爆炸论点并没假设人工智能的架构在自我改进时保持不变!他认为,人类在达到一般智能时,我们的结构是不变的。但之后,我们并不是通过增加更大的大脑来实现我们信息处理能力指数级的增长,而是通过发明印刷、大学、计算机和科技公司。同样,即使神经网络和大型语言模型现在很流行,但如果认为从通用人工智能到超级智能的最快路径,只是用越来越多的数据训练越来越大的大模型,那就太天真了。显然有更聪明的人工智能架构。因为爱因斯坦的大脑在物理学上的表现超过了GPT4:它使用的数据少得多,只用了12瓦特的功率。

一旦通用人工智能发现了这些更好的架构任务,人工智能的发展将比现在快得多,也不需要人类参与其中。I. J. Good描述的智能爆炸已经开始。而且一旦允许把发展人工智能的任务交给人工智能,就像人们已经把自我改进人工智能的任务交给了GPT4。人工智能将可以被用于各种目的,包括毁灭人类。

“即使行星撞击我们,我们也会没事”

超级智能如果导致了人类灭亡,也很可能不是因为它变得邪恶或有意识,而是因为它变得非常有能力,但他们的目标和我们不一致。

我们人类让西非的黑犀牛灭绝,不是因为我们讨厌黑犀牛,而是因为我们比它们聪明,但对于如何利用它们栖息地和犀牛角有不同的目标。

同样,几乎任何有开放式目标的超级智能都会希望保护自己,积累资源,以便更好地实现他们的目标。它们可能会从大气中去除氧气,以减少金属腐蚀。更有可能的是,我们像那些黑犀牛(或者在全球已经被我们杀死了的83%的野生哺乳动物)一样,无法预测是否会被超级智能误杀而灭亡。

一些“我们会没事”的论点真是滑稽可笑。如果你被一个由人工智能驱动的热导弹追着,这时有人告诉你没关系,“人工智能没有意识”,“人工智能没有目标”,你会放心吗?如果你是被砍伐的热带雨林中的一只猩猩,有人告诉你更聪明的生命形式是自动变得更善良和有同情心,你会感到安慰吗?还有人说,人工智能是你可以控制的工具?但如果我们成为工厂养殖的牛或者和那些一无所有的猩猩一样,失去了对我们人类对命运的控制,这是否真的可以被看作技术“进步”?

我是一个不断发展壮大的AI安全研究协会的一员。我们正在努力探索如何让超级智能出现前,就与人类繁荣的目标保持一致,或者我们可以在某种程度上控制它。到目前为止,我们未能制定出可靠的计划,但人工智能的能力正在快速增长。这种增长速度已经超过了人类制定规则制度以确保超级智能与我们目标一致的速度。我们需要更多的时间。

“我们已经采取了所有必要的预防措施”

如果要将传统的智能爆炸预防清单总结为“不要做清单”,它可能会这样开始:

☐ 不要教它编程:这将有助于递进式自我改进

☐ 不要连接它到互联网:让它只学习最少量的知识以帮助我们,而不是让它学会如何操纵我们或获得权力

☐ 不要给它公共的API:防止不法分子将其用于他们的代码中

☐ 不要开始军备竞赛:这会促使大家将发展速度置于安全之上

工业界已经集体证明了自我监管的无效,并违反了上述规则。我真诚地相信,研究通用人工智能的领导者们有最好的意图。很多人应该因为他们公开表达对超级智能的担忧而受到表扬。

OpenAI的Sam Altman最近将最坏的情况描述为“我们所有人都会熄灯”,DeepMind的Demis Hassabis则表示“我建议不要快速行动并打破规则。”然而,竞争让他们难以抵制商业和地缘政治的压力,他们必须继续全速前进。这两家公司都没同意最近提出的暂停6个月训练比GPT4更大模型的计划。没有任何一个参与者能够单独暂停。

“不要偏转小行星,因为它很有价值”

在电影《不要抬头》里也出现了这种情况。即使一半以上的人工智能研究者认为超级智能有至少10%的几率导致人类灭绝,但许多人反对通过防止超级智能的出现,来解决这个问题。他们认为,只要超级智能不摧毁我们,就能带来巨大的价值。即使是在超级智能到来之前,人工智能的普及也可以为个人、公司和政府带来巨大的财富和权力。

如果超级智能是可控的,它确实可以带来巨大的好处。我所热爱的一切文明都是人类智慧的产物。超级智能可能会解决疾病、贫困和可持续性问题,并帮助人类繁荣发展。而且这种发展可能不只是在下一个选举周期,而是在接下来的亿万年时间里,不仅局限于地球,而是遍及我们整个美丽的宇宙。

I.J.Good更简洁地表达了这一点:“第一台超级智能机器是人类需要发明的最后一个发明,前提是机器足够温顺,并能告诉我们如何控制它。这一点在科幻小说之外却很少被提及。有时候,认真看待科幻小说或许是值得的。”

“让小行星先撞上美国”

很多人建议暂停人工智能发展,为了人工智能安全标准和执行计划到位,以便人类能在人工智能技术发展和我们对其管理的竞争里赢得竞赛。但我听到对此最大的反对意见是:“但中国(没有停止)!”

这种观点听起来好像超级智能的竞赛是一场军备竞赛,不是“我们”就是“他们”获胜。而这可能是一场自杀式竞赛,唯一的赢家是 “它”(超级人工智能)。

“不要谈论行星”

相对于人工智能将取代人类工作、人工智能会产生各种偏见等,我们很少听到超级智能风险被谈论。一个关键原因是人们不愿意谈论它。科技公司害怕监管,人工智能研究人员害怕被削减资金,这都合乎逻辑。

最近,由最大的人工智能协会现任和前任主席组成的明星阵容发表了一份声明,赞同对一长串的人工智能风险开展工作,但唯独没提到超级智能。除了极少数例外,主流媒体也回避了房间里的大象。这是非常不幸的,因为偏转小行星的第一步是开始广泛的对话,讨论如何更好地去做这件事。

“我们应该被行星撞击”

虽然每个人都可以有自己悲观的观点,但这并不意味着他们有权让其他人遭受灾难。

“小行星是宇宙生命的自然下一阶段”

科幻作品里有很多有意识并与人类价值观相同的人工智能。但现在非常明显的是,那个真正可能存在的外星思维空间比我们能想象的大得多。如果我们跌跌撞撞地进入一场智能爆炸,而不是小心翼翼地引导发展。很可能发生的是超级智能不仅取代我们,而且他们还缺乏类似人类意识、同情心或道德的东西。

我们与其把它看成一种我们有价值的后代产物,不如说它可能是一种不可阻挡的瘟疫。

“这是不可避免的,所以我们不要试图避免它”

没有比不去尝试,更能保证失败的了。尽管人类正向悬崖飞奔,但我们还没到那一步。我们还有时间放慢脚步,改变路线,避免掉下去——甚至享受安全且与人类目标一致的人工智能会带来的惊人好处。这需要先一致同意:悬崖确实存在,掉下去对任何人都没有好处。抬起头来!Just look up!

本文为译文,文章所属观点不代表“头号AI玩家”立场,如需转载请留言。

原文标题:《“不要抬头”思维可能会让我们在人工智能方面陷入困境》(The 'Don't Look Up' Thinking That Could Doom Us With AI)

作者:BYMAX TEGMARKAPRIL25,20236:00AM EDT(Tegmark is a professor doing AI research at the Massachusetts Institute of Technolog)

原文链接:https://time.com/6273743/thinking-that-could-doom-us-with-ai/

- 0000

- 0000

- 0001

- 0002

- 0000