智源开源最强检索排序模型 BGE Re-Ranker v2.0

智源研究院推出了新一代检索排序模型 BGE Re-Ranker v2.0,支持100 种语言,文本长度更长,并在多项评测中达到了 SOTA(state-of-the-art)的结果。该模型是智源团队在 BGE(BAAI General Embedding)系列基础上的新尝试,扩展了向量模型的 “文本 图片” 混合检索能力。

BGE Re-Ranker v2.0采用分层自蒸馏策略优化推理效率,通过不同尺寸的模型基座(如 MiniCPM-2B、Gemma-2B、BGE-M3-0.5B)支持多语言检索能力。此外,该模型还新增了对 “文本 图片” 混合检索功能的支持,通过引入 CLIP 模型生成的 visual token 实现。

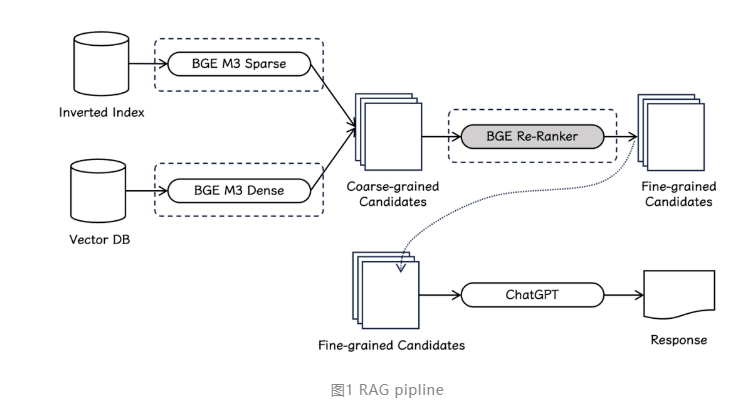

在性能评测方面,BGE Re-Ranker v2.0在英文、中文、多语言主流基准上取得了优秀的检索效果。例如,在 MTEB、C-MTEB、MIRACL、LLaMA-Index 等评测基准中,BGE Re-Ranker v2.0在重排 BGE-v1.5-large 的 top-100候选集时表现优异,提升了检索精度。同时,模型在 RAG 场景下也能够显著提升各种 embedding 模型的召回结果,配合 BGE-M3可以获得最佳的端到端检索质量。

BGE 系列模型的优秀性能和通用性也受到了社区的广泛关注,Vespa、Milvus 等主流向量数据库框架已经集成了 BGE-M3模型,为用户搭建 “三位一体” 的检索流水线提供了便利。

综上所述,智源研究院推出的 BGE Re-Ranker v2.0检索排序模型具有强大的多语言支持、更长文本长度、优秀的检索效果和灵活的 “文本 图片” 混合检索功能,为信息检索领域带来了新的利器。

项目地址:

https://github.com/FlagOpen/FlagEmbedding

https://huggingface.co/BAAI

- 0000

- 0000

- 0000

- 0000

- 0000