谷歌“窃取”GPT-3.5模型关键信息:成本低至150元,调用API即可得手

划重点:

🔍 谷歌成功攻击OpenAI GPT-3.5-turbo模型,成本低至150元

🛡️ 攻击方法简单,通过API不到2000次查询即可获取整个投影矩阵和隐藏维度

📢 OpenAI已知情并采取措施修改模型API

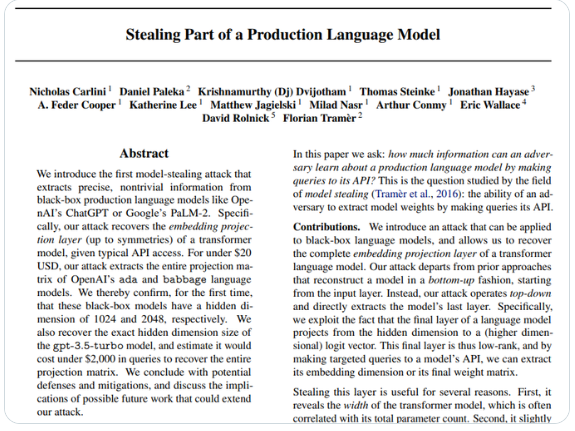

谷歌最新研究揭示了一种攻击大型语言模型的方法,成功窃取了OpenAI GPT-3.5-turbo模型的关键信息。根据谷歌的声明,他们不仅还原了OpenAI大模型的整个投影矩阵,还获得了确切的隐藏维度大小,而这一切只需不到2000次巧妙的API查询,成本低至150元。

攻击的核心目标是模型的嵌入投影层,即模型的最后一层,负责将隐藏维度映射到logits向量。通过向模型的API发出针对性查询,可以提取出模型的嵌入维度或者最终权重矩阵。谷歌通过大量查询和奇异值排序成功识别出模型的隐藏维度。

该攻击方法不仅可以揭示模型的隐藏维度,还能获取模型的“宽度”(总体参数量)等全局性信息,降低模型的“黑盒程度”,为后续攻击“铺路”。研究团队表示,这种攻击非常高效,攻击OpenAI的Ada和Babbage模型以及GPT-3.5分别只需不到20美元和大约200美元。

OpenAI已经得知这一情况,并在研究团队征得同意后确认了攻击的有效性,最终删除了所有与攻击相关的数据。虽然这种攻击方式获取的信息并不多,但其低成本和高效性令人震惊。

论文中提到的防御措施包括从API下手,彻底删除logit bias参数,或者直接从模型架构下手,在训练完成后修改最后一层的隐藏维度等。在此事件曝光后,OpenAI已经采取了修改模型API的措施,防止类似攻击再次发生。

这项研究揭示了即使是大型语言模型也可能面临安全威胁,即便OpenAI已经采取了一定的防御措施。这一事件提醒了人们,保障模型的安全性仍然是一个复杂而重要的问题。

论文链接:https://arxiv.org/abs/2403.06634

- 0000

- 0000

- 0000

- 0000

- 0001