微软AI研究推数学LLM Orca-Math:通过对Mistral-7B模型进行微调的7B参数小模型

**划重点:**

1. 🚀 微软推出Orca-Math,一款由7亿参数构建的小语言模型,通过对Mistral-7B架构进行微调。

2. 🎓 Orca-Math通过创造性的合成数据集和迭代学习机制,重新定义了教授数学单词问题的传统方法。

3. 📈 Orca-Math在GSM8K基准上取得了显著的成就,展示了SLM在教育挑战中的潜力,提供了创新方法和资源的范例。

微软研究团队引领着教育技术领域的不断创新,近日推出了一款名为Orca-Math的前沿工具,它是一款小语言模型(SLM),拥有7亿参数,并基于Mistral-7B架构微调而来。这一创新方法重新定义了传统数学单词问题教学的策略,彻底改变了学生参与和掌握这一学科的方式。与以往常常依赖广泛的模型调用和外部工具进行验证的方法不同,Orca-Math以其简化而高效的解决方案脱颖而出。

Orca-Math的方法论的核心是一个由20万道数学问题组成的精心制作的合成数据集。然而,Orca-Math的真正巧妙之处在于其迭代学习过程。在模型遍历这个数据集时,它尝试解决问题并获得对其努力的详细反馈。这个反馈循环丰富了偏好对比,将模型的解决方案与专家反馈进行对比,促进了一个学习环境,使模型不断完善其解决问题的能力。

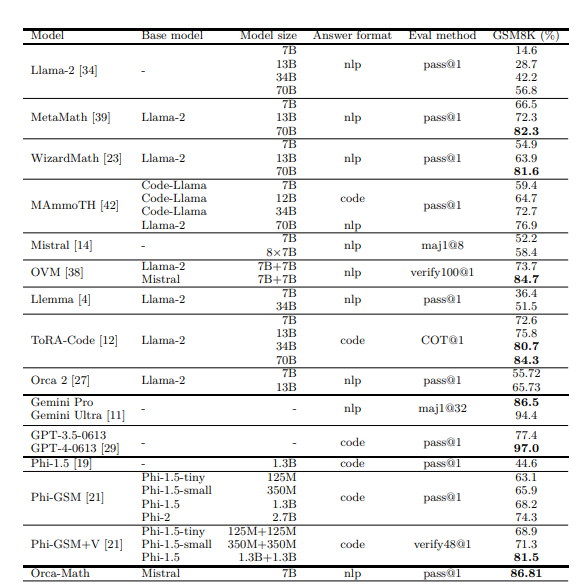

这种迭代学习机制对于Orca-Math的成功至关重要。最初,仅在合成数据集上进行监督微调(SFT)时,Orca-Math展示了令人印象深刻的能力,在GSM8K基准上实现了81.50%的准确率。然而,引入迭代偏好学习将Orca-Math推向了新的高度,使其在相同基准上达到了86.81%的准确率。这些数字代表了在利用SLM解决教育挑战方面的一大步前进。考虑到模型的规模和其高效运行的效率,Orca-Math的成就尤为显著,超过了规模显著更大的模型,并在该领域设立了新的基准。

微软研究的Orca-Math不仅在性能上超越了现有的大型模型,而且还以卓越的效率完成了这一壮举,利用更小的数据集。这一壮举突显了SLM在配备正确方法和资源的情况下的潜力。Orca-Math在GSM8K基准上的表现证明了所开发方法的有效性,突显了该模型在解决机器长期以来难以处理的数学问题方面的娴熟能力。这一努力还展示了当SLM配备创新技术,如合成数据生成和迭代学习时,它们的变革力量。

Orca-Math体现了一种突破性的学习方法,将人工智能和教育的领域融合在一起,以应对教授复杂问题解决技能的长期挑战。通过利用SLM通过合成数据集和迭代反馈来解锁学习工具的全新时代,Orca-Math为技术和学习手牵手走向解锁全球学生的全部潜力的未来提供了一瞥。

论文地址:https://arxiv.org/abs/2402.14830

官方博客:https://www.microsoft.com/en-us/research/blog/orca-math-demonstrating-the-potential-of-slms-with-model-specialization/

- 0000

- 0000

- 0000

- 0000

- 0000