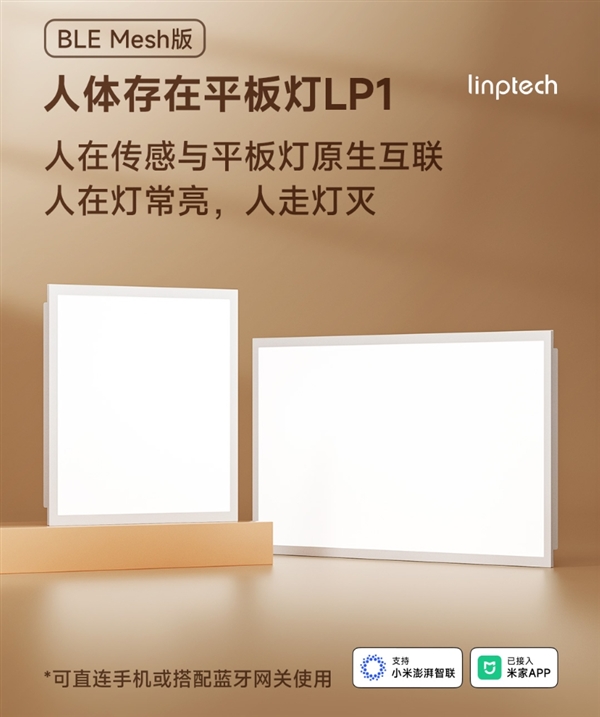

阿里推AtomoVideo文本+图片生视频模型,媲美Gen-2和Pika

划重点:

1. 🌐 AtomoVideo介绍:阿里技术团队推出的文本 图片生成高保真视频模型,通过简单的文本提示和高清图片即可生成逼真高清视频。

2. 🚀 技术创新:AtomoVideo融合多粒度图片注入和时间建模,利用VAE编码器和CLIP编码器提高细节信息和文本语义的一致性,同时在时间维度上进行创新以学习时序动态模式。

3. 📊 评测数据:经深度比较,AtomoVideo在动作连贯性、图片一致性、时序一致性、运动强度等多个评估维度上超越开源模型VideoCrafter、I2VGEN-XL、SVD,媲美商业模型Gen-2和Pika。

阿里巴巴集团近期推出了一款引人瞩目的视频生成模型,命名为AtomoVideo。该模型以文本和图片为输入,能够高效生成高保真视频,与商业模型Gen-2和Pika相媲美。

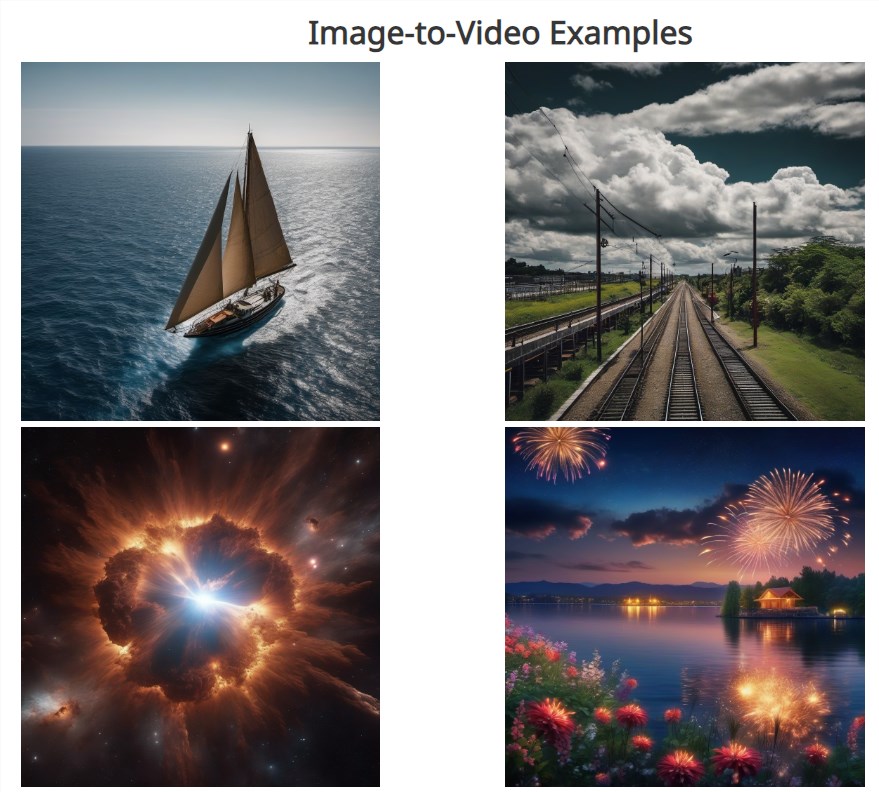

AtomoVideo的使用非常简便,用户只需提供高清图片和简单的文本提示即可在短时间内生成逼真的高清视频,并保留细致的细节。据评测数据显示,AtomoVideo在动作连贯性、图片一致性、时序一致性、运动强度等方面超过了多个开源模型,表现出色。

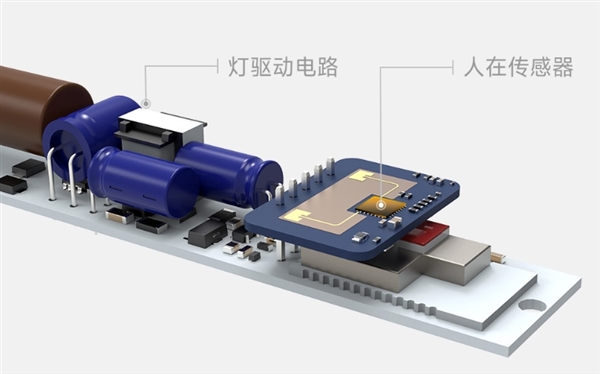

该模型的技术创新主要体现在多个方面。首先,AtomoVideo使用了预训练的Stable Diffusion1.5作为基础模型,并在每个空间卷积和注意力层后新增了1D时序卷积和时序注意力模块。其次,模型融合了多粒度图片注入和时间建模,通过VAE编码器处理输入图片,得到细粒度的图片潜在表征,并与高斯噪声拼接在一起作为UNet的输入。此外,AtomoVideo还利用CLIP编码器进行高层语义表征,通过交叉注意力注入到UNet中,使模型能够同时捕捉到图片的细节信息和文本语义提示,提高生成视频与原始图片的一致性。

在时间维度上,AtomoVideo引入了一维时间卷积和时间注意力模块,在UNet的每一个空间卷积和注意力层之后,赋予了模型学习时序动态模式的能力。除了图片生成视频,该模型还可用于其他视频相关任务,如给定视频的前几帧,对剩余未知帧进行视频扩展预测,为视频添加无缝延续的新内容;基于上下文帧,自动修复受损帧或插值缺失帧,实现自动修复损坏的视频。

在训练阶段,研究人员采用了零终端信噪比和v-预测等策略,显著提升了生成视频的稳定性,无需依赖于噪声先验。通过最小化零终端信噪比来优化模型,在生成过程中更好地控制生成视频的稳定性和质量,以及对生成的细节和一致性的精准掌控。此外,固定了预训练的文本到图片模型的权重,仅训练新添加的时序层和输入层参数,使得AtomoVideo能够无缝集成到目前流行的个性化文生图模型、可控生成模型等,进一步扩展了其应用场景。

为了评估AtomoVideo的性能,研究人员在AIGCBench测试集上与多个开源模型和商业模型进行了深度比较,结果显示AtomoVideo在多个评估维度上表现卓越,尤其在保持较大运动强度的同时实现了优异的时间稳定性。这一创新性的视频生成模型将为AIGC领域带来更多可能性,引领视频生成技术的发展。

论文地址:https://arxiv.org/abs/2403.01800

项目入口地址:https://top.aibase.com/tool/atomovideo

- 0001

- 0000

- 0000

- 0000

- 0000