清华大学团队推出RTFS-Net:革新视听语音分离,百万参数实现高效性能

**划重点:**

1. 🎙️ RTFS-Net是首个采用少于100万个参数的视听语音分离方法,通过压缩-重建策略显著减少计算复杂度。

2. 🌐 针对传统视听语音分离方法的问题,RTFS-Net创新性地解决了时域和时频域方法的挑战,提高了在复杂环境中的性能。

3. 🚀 在三个基准多模态语音分离数据集上,RTFS-Net在大幅降低模型参数和计算复杂度的同时,接近或超越了当前最先进的性能。

清华大学的胡晓林团队最近推出了一项创新性的视听语音分离方法,称为RTFS-Net。这一方法通过采用压缩-重建的策略,不仅实现了百万参数以下的视听语音分离,而且显著减少了计算复杂度,为音视频分离领域带来了新的视角。

传统的视听语音分离方法通常依赖于复杂的模型和大量的计算资源,尤其在嘈杂背景或多说话者场景下性能受到限制。RTFS-Net通过创新性地解决时域和时频域方法的挑战,突破了这些限制。时域方法提供高质量的音频分离效果,但计算复杂度高,而时频域方法虽然计算效率更高,却一直面临缺乏独立建模、未充分利用多个感受野的视觉线索和对复数特征处理不当等问题。

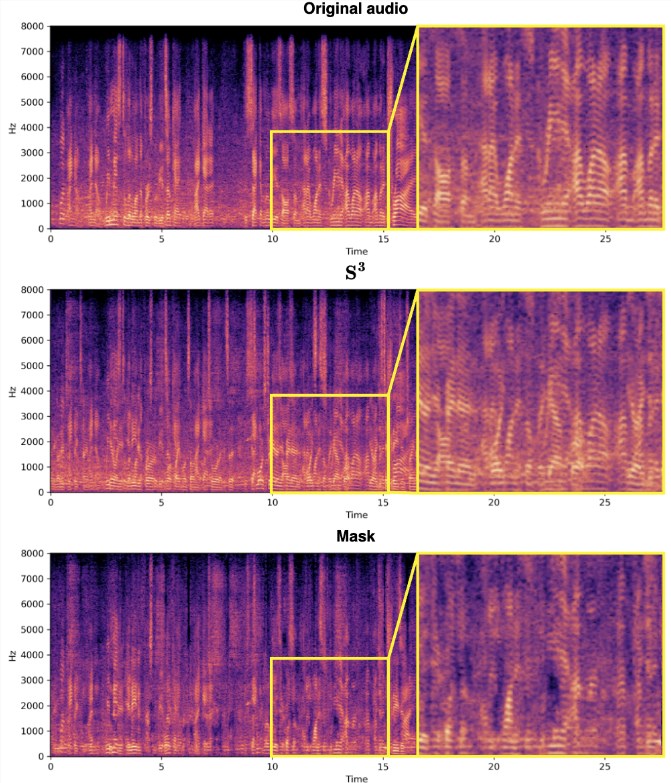

RTFS-Net的关键在于引入了RTFS块,该块通过双路径架构在时间和频率两个维度上对音频信号进行有效处理。具体来说,RTFS块首先进行时间和频率维度的压缩,然后在压缩后的维度上进行独立建模,最后通过融合模块将两个维度的信息合并。这一策略不仅减少了计算复杂度,还保持了对音频信号的高度敏感性和准确性。

此外,RTFS-Net还引入了跨维注意力融合(CAF)模块,有效融合音频和视觉信息,提高了语音分离效果。CAF模块采用深度和分组卷积操作生成注意力权重,动态调整输入特征的重要性,通过对视觉和听觉特征应用注意力权重,实现在多个维度上聚焦于关键信息。

最终,RTFS-Net的实验结果表明,在三个基准多模态语音分离数据集上,该方法在大幅降低模型参数和计算复杂度的同时,接近或超越了当前最先进的性能。通过不同数量的RTFS块的变体展示了在效率和性能之间的权衡,其中RTFS-Net-6在性能与效率方面取得了良好的平衡,而RTFS-Net-12在所有测试的数据集上表现最佳,证明了时频域方法在处理复杂音视频同步分离任务中的优势。

这一创新性的视听语音分离方法为提高AVSS性能提供了新的思路,不仅降低了计算复杂度和参数数量,而且在保持显著性能提升的同时,为音视频分离领域注入了更多创新和高效的架构。

论文地址:https://arxiv.org/abs/2309.17189

代码地址:https://github.com/spkgyk/RTFS-Net(即将发布)

- 0001

- 0000

- 0000

- 0001

- 0000