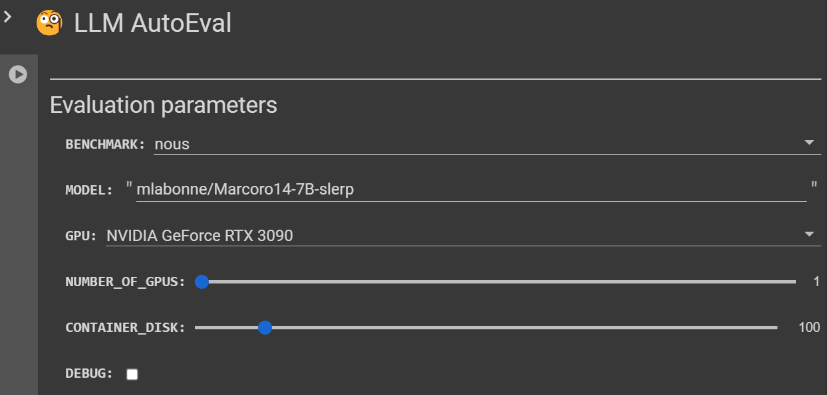

VSP-LLM:可通过观察视频中人的嘴型来识别唇语

VSP-LLM是一种通过观察视频中人的嘴型来理解和翻译说话内容的技术,也就是识别唇语。该技术能够将视频中的唇动转化为文本(视觉语音识别),并将这些唇动直接翻译成目标语言的文本(视觉语音翻译)。不仅如此,VSP-LLM还能智能识别和去除视频中不必要的重复信息,使处理过程更加快速和准确。

VSP-LLM的开发基于AV-HuBERT模型代码,后者是Facebook开发的一个自监督的视觉语音模型。AV-HuBERT能够从视频中学习语音表示,尤其是从人的唇动中识别语音信息。因此,VSP-LLM利用了AV-HuBERT在视觉语音识别方面的先进技术,作为其视觉语音处理组件的基础。

项目地址:https://top.aibase.com/tool/vsp-llm

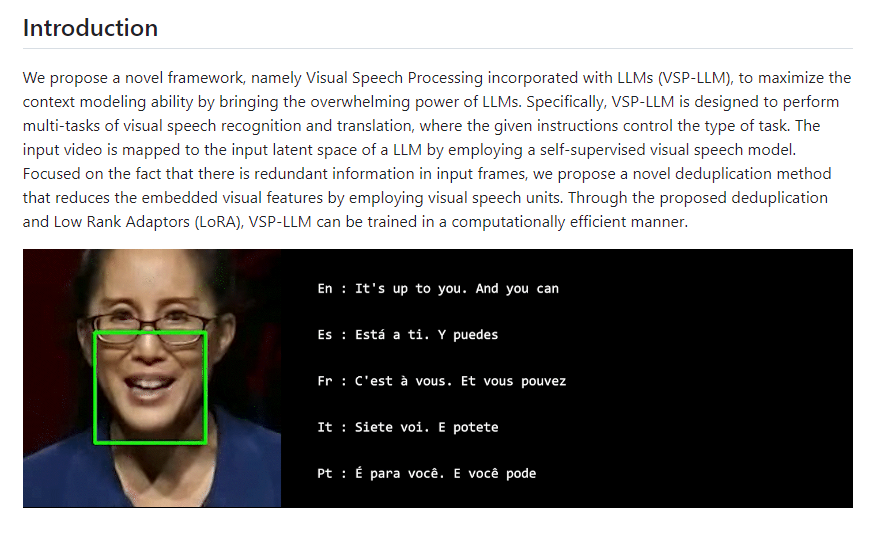

该技术结合了视觉语音处理和大语言模型(LLMs)的新型框架,旨在利用LLMs的上下文理解能力来提高视觉语音识别和翻译的准确性和效率。

VSP-LLM的工作原理包括自监督学习、去除输入帧中的冗余信息、利用大语言模型进行上下文建模、多任务执行和低秩适配器(LoRA)。

首先,通过自监督学习的方式,VSP-LLM训练一个视觉语音模型来理解和识别视频中提取的唇动作。自监督学习使得模型能够在没有明确标注的数据情况下,通过自我生成的反馈来学习和提取有用的信息。

其次,为了提高处理效率,VSP-LLM设计了一种去重方法,通过识别视觉语音单元减少输入帧中的冗余信息,进而减少模型需要处理的数据量。

然后,通过将自监督视觉语音模型提取的信息映射到LLMs的输入空间中,VSP-LLM能够实现视觉到文本的映射,进而利用LLMs的上下文建模能力来理解和翻译视频中的唇动作。

此外,VSP-LLM能够执行多任务,包括将视频中的唇动作识别为具体文本(视觉语音识别)或直接翻译这些唇动作成目标语言的文本(视觉语音翻译)。

最后,为了进一步提升训练的计算效率,VSP-LLM采用了低秩适配器(LoRA)技术,这种优化训练过程的方法能够减少计算资源的需求。

- 0000

- 0002

- 0003

- 0000

- 0000