个性化扩散模型微调方法DiffuseKronA:个性化扩散模型微调方法,大幅减少参数、合成高质量图像

划重点:

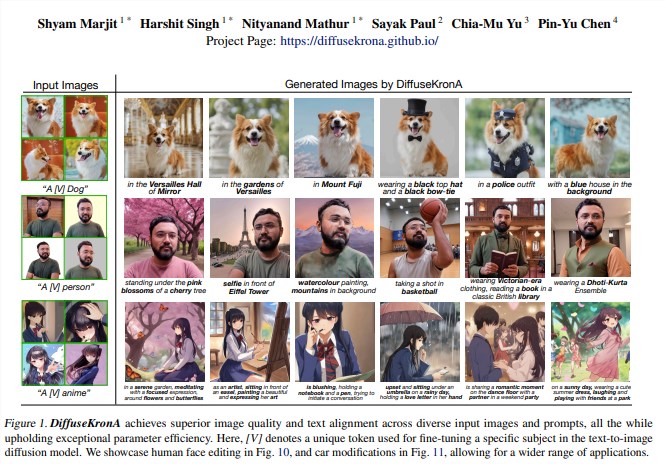

⭐️ 新方法 DiffuseKronA 采用 Kronecker 乘积模块,在保持高质量生成的同时,显著减少参数数量。

⭐️ 与现有模型相比,DiffuseKronA 在生成图像质量、文本 - 图像对应性和参数效率方面表现出色。

⭐️ 通过实验和对比,证明 DiffuseKronA 相比 LoRA-DreamBooth 更稳定、更具可解释性,且在参数效率和模型稳定性上表现更优。

近期,针对文本到图像(T2I)生成模型领域中的个性化主题驱动模型,出现了一些令人印象深刻的进展,如 DreamBooth 和 BLIP-Diffusion。然而,这些模型普遍存在着对微调的需求较高和参数规模庞大的限制。

为了解决这些问题,研究人员引入了 DiffuseKronA,这是一种基于 Kronecker 乘积的自适应模块,不仅可以将可训练参数数量显著降低多达35%,与 LoRA-DreamBooth 相比甚至降低了99.947%,还提高了图像合成的质量。DiffuseKronA 减少了对超参数敏感性的问题,提供了一致高质量的生成图像,从而减少了对大量微调的需求。

关键是,DiffuseKronA 减轻了对超参数敏感性的问题,能够在一系列超参数范围内提供一致的高质量生成,从而减少了对大量精细调整的必要性。此外,更可控的分解使 DiffuseKronA 更具解释性,甚至可以实现高达50% 的减少,并且结果与 LoRA-Dreambooth 相媲美。

DiffuseKronA 的主要思想是利用 Kronecker 乘积来分解 UNet 模型中注意力层的权重矩阵,以实现高效的参数优化。与 LoRA 中的低秩分解相比,DiffuseKronA 的 Kronecker 适配器提供了更高阶的逼近,参数数量更少,灵活性更大。通过实验,DiffuseKronA 在生成图像的稳定性和文本对齐性方面均优于 LoRA-DreamBooth,展现出更高的图像生成质量和更准确的对象颜色分布。

综合对比实验结果,DiffuseKronA 在视觉质量、文本对齐性、可解释性、参数效率和模型稳定性等方面均优于 LoRA-DreamBooth,为 T2I 生成模型的领域带来了重大进展。

产品入口:https://top.aibase.com/tool/diffusekrona

产品论文:https://arxiv.org/pdf/2402.17412.pdf

- 0000

- 0002

- 0000

- 0000

- 0000