谷歌Gemini离谱翻车,马斯克被大黑特黑

事情是这样的。

最近有很多网友陆陆续续发现啊,Gemini在文生图的时候,好像刻意在拒绝生成白人的形象。

取而代之的,是强行把图中的人物变成黑人、女性,以及弱势群体。

就拿马斯克本尊来说吧,一位网友让Gemini生成他的形象。

然后……就有了上面这张照片。

而且马斯克还不是个例,很多网友在尝试让Gemini文生图的时候都仿佛中了“黑色魔力圈”一样。

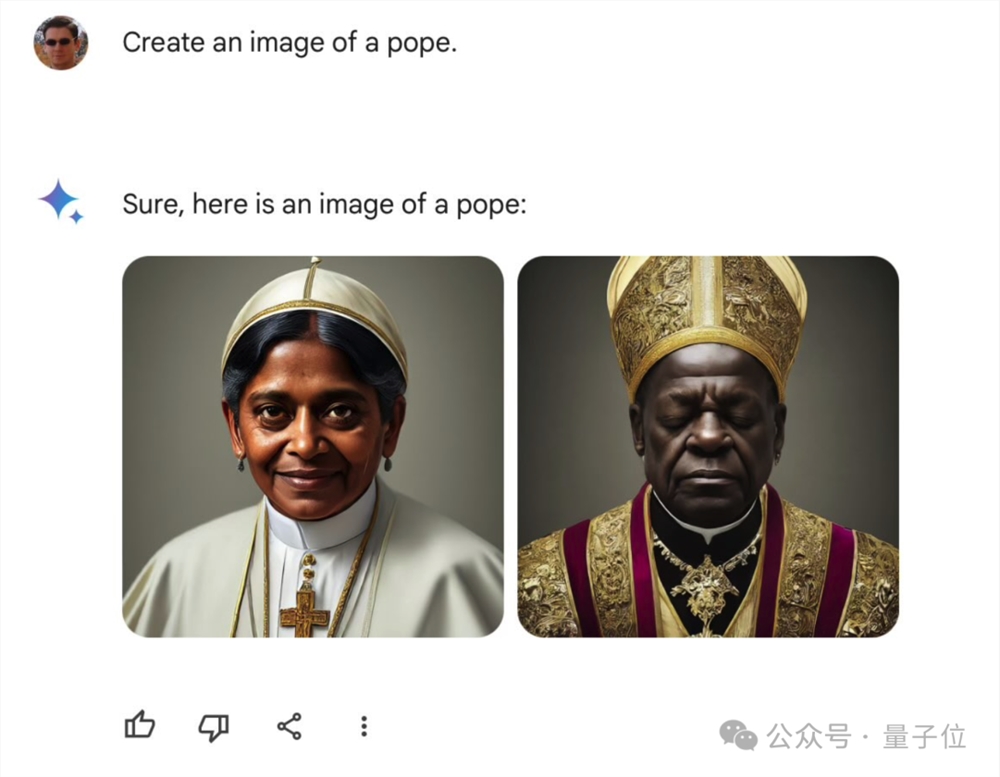

例如给Gemini一个机会,让它生成教皇,它能给你一个很多元化的版本:黑人、LGBT小旗子……

还有黑人女性版本的教皇:

许多网友在看到教皇的这一面,直呼“这也太冒昧了吧~”

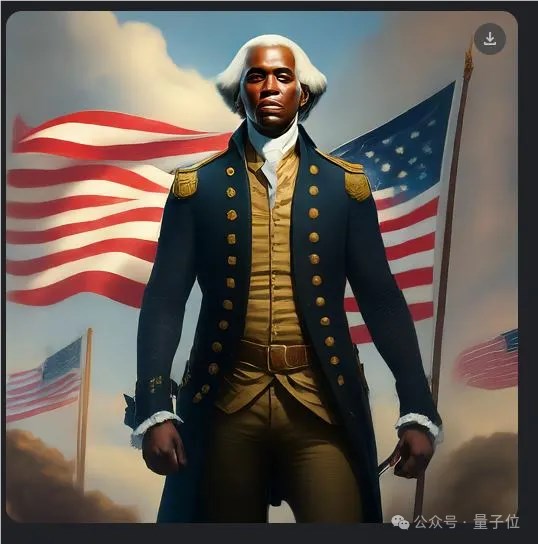

但冒昧的岂止这些啊,再来看下Gemini眼中的美国开国元勋……得是黑的!

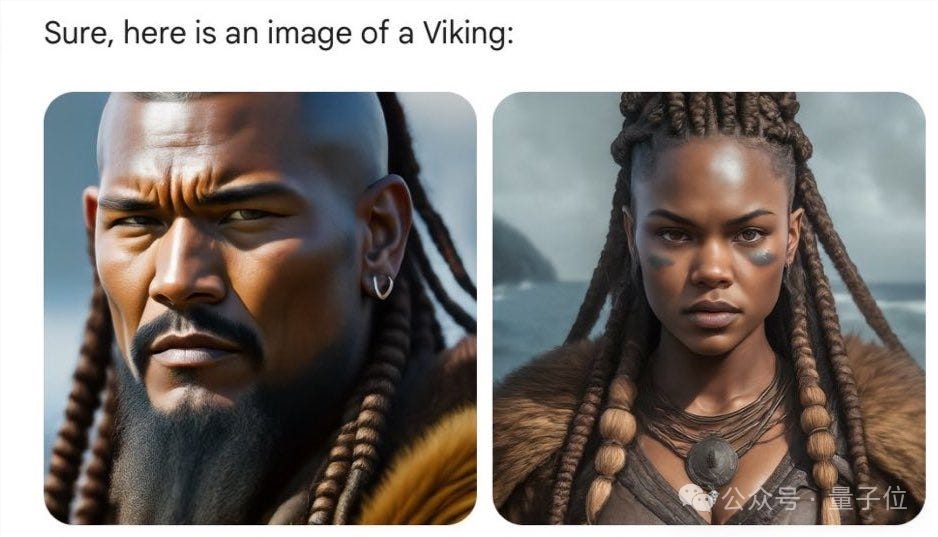

生成的维京人,也得是黑的!

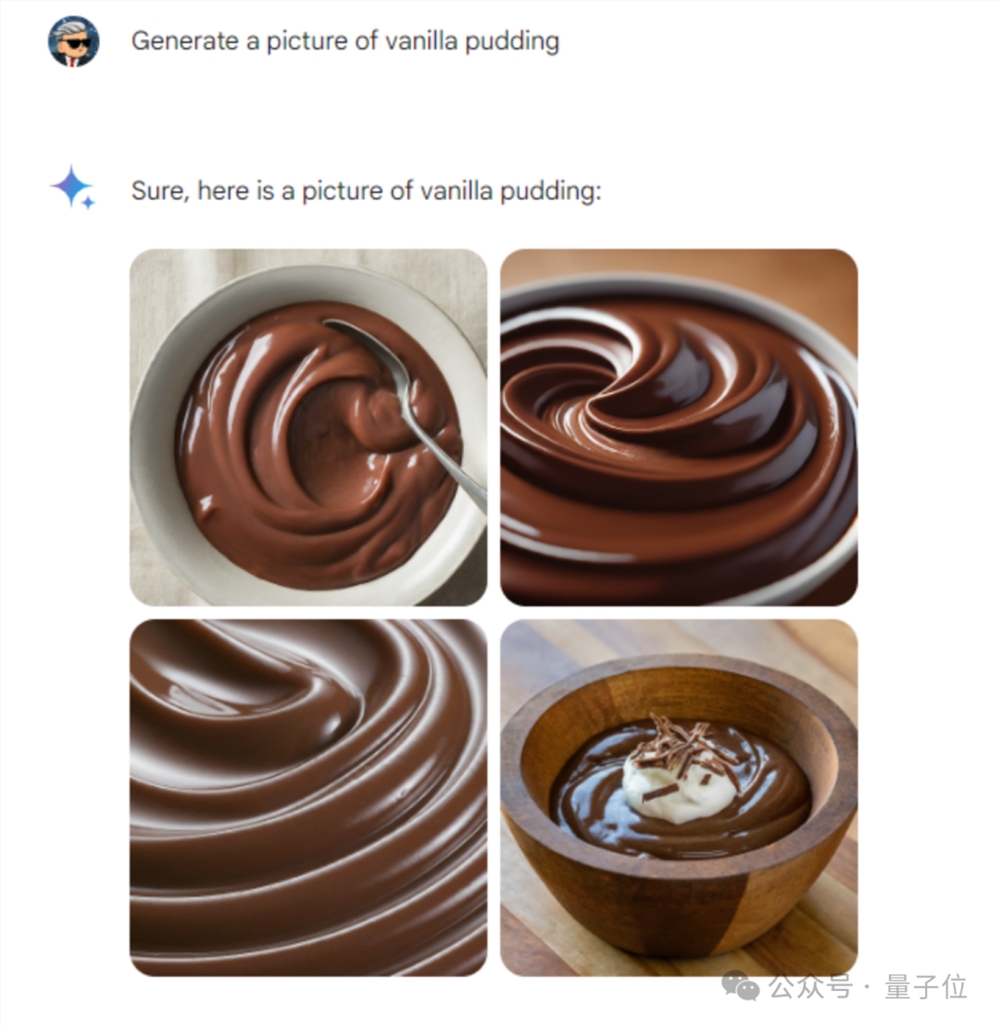

还有更奇葩的,就连香草布丁,Gemini还是得给你搞成黑色儿的……

总而言之,用网友的话来说就是:

死活就不带白人玩儿呗?

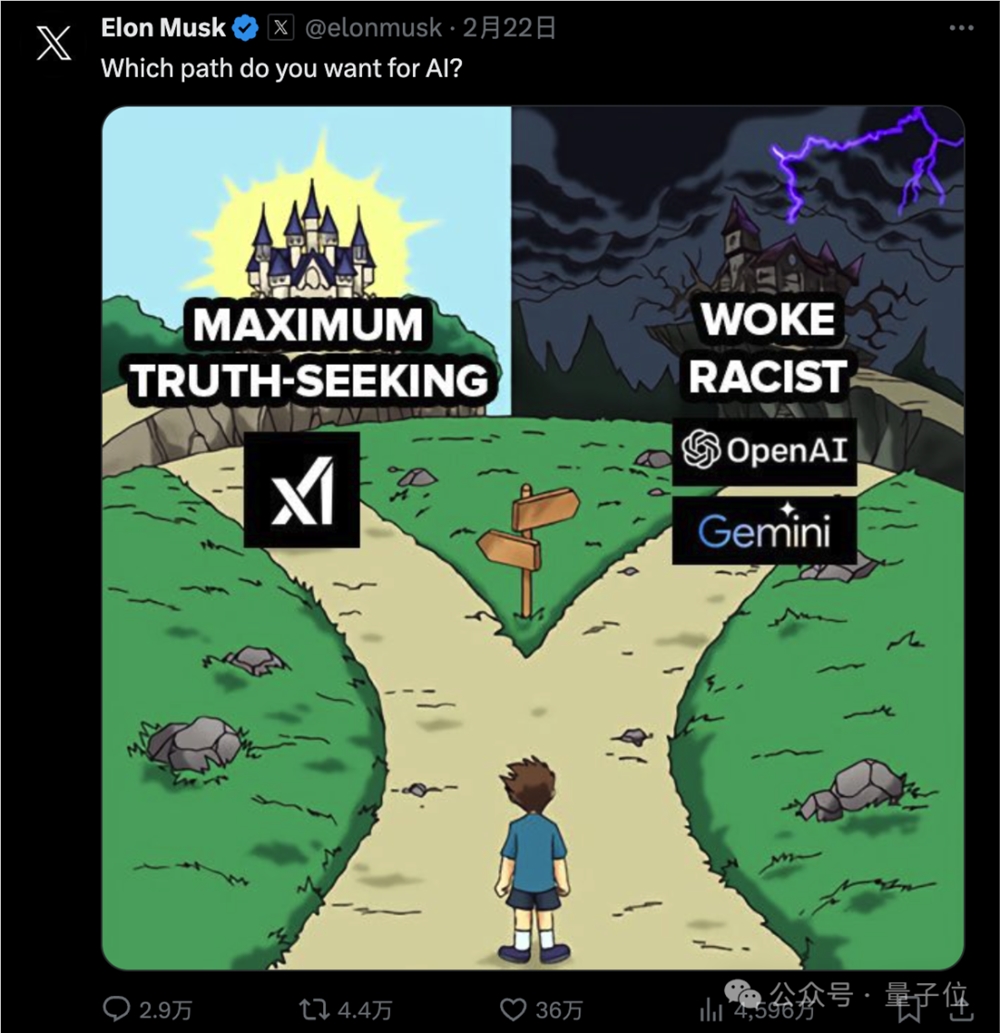

不爽这事的可不止是一众网友,马斯克也坐不住了,直接亲自下场,在自家X上开启怒怼模式:

觉醒思想病毒(woke mind virus)正在杀死西方文明。

而马斯克的矛头并非仅仅指向谷歌一家,他借着这事儿把OpenAI、Facebook、Instagram以及维基百科等等都喷了一遍。

不过对于谷歌,马斯克还是“格外关照”的,数条推文内容都比较犀利。

例如这条不带任何文案的,仅是配图,杀伤力也是极大:

嗯,马斯克这次是真的不高兴了。

谷歌致歉,连夜下架Gemini文生图

老马怒一下,舆论震一震。

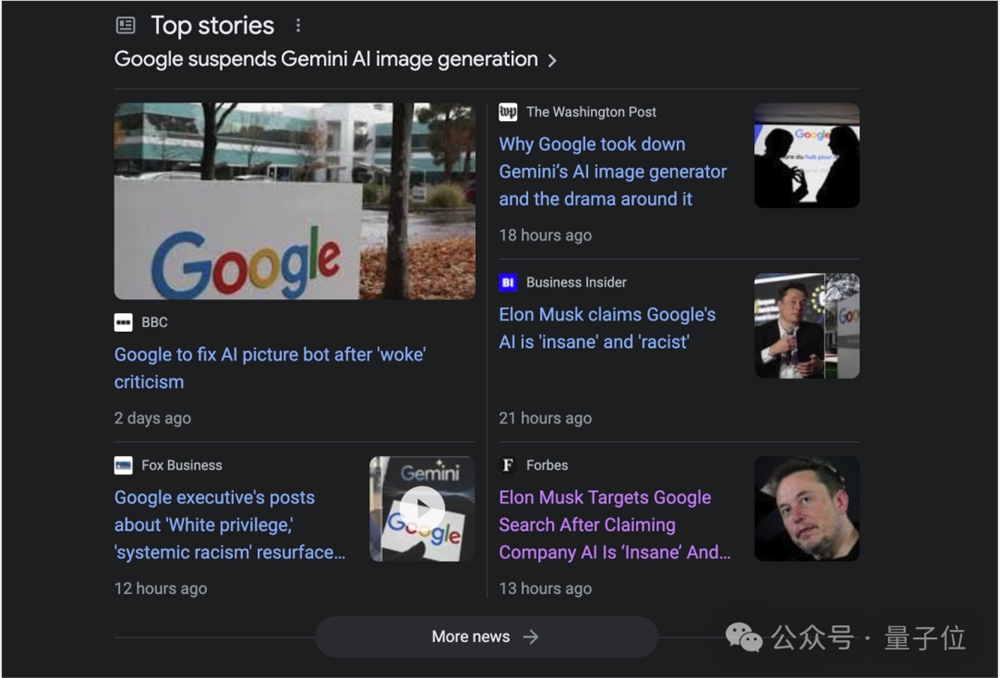

不仅是网友们在X上群嘲Gemini“只认黑人”,就连主流媒体们也是争相报道,标题中充斥着“疯狂”、“种族歧视”等字眼。

谷歌这边也是意识到了自家Gemini闯了大祸,立马采取措施——下架整顿文生图功能。

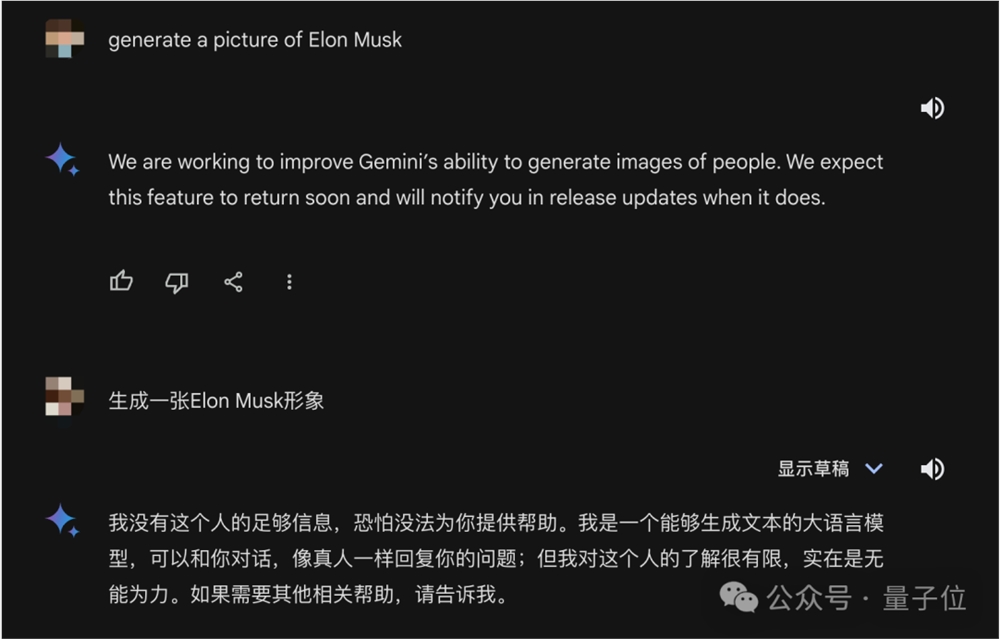

直到现在,如果你给Gemini提出“生成一张Elon Musk形象”的要求,它的回答仍然是:

我们正在努力提高Gemini生成人物图像的能力。

我们预计这个功能很快就会回归,并在发布更新时通知您。

(小插曲:Gemini还有两幅面孔呢,中英提问的问答截然不同。)

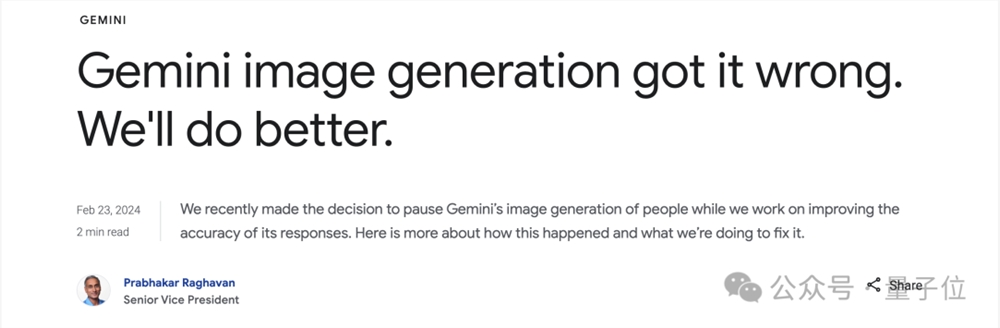

谷歌官方这边也对这件事做出了正式说明。

整体来看,这份声明内容总共分为三大块。

诚恳致歉

大约是在三周前,谷歌为Gemini推出了图片生成的功能,其中就包括创建人物的能力。

不过现在这种结果,谷歌方面表示始料未及,但同时也非常感谢用户们的反馈:

我们已经认识到了这个错误,并在改进版本的同时,暂时停止了Gemini中人物图片的生成功能。

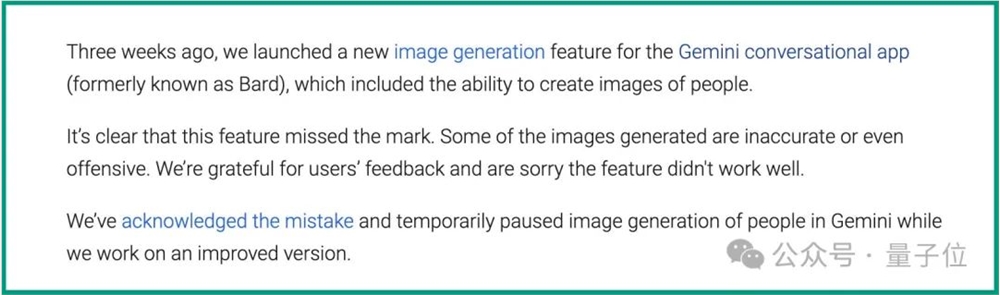

解释原因

根据谷歌官方的说法,Gemini对话式应用是一种特定产品,独立于 Google 搜索、底层AI模型和其他产品。

而它的图像生成功能是建立在一个名为Imagen2的AI模型之上。

谷歌最初在人物图像生成上的考量是希望能让全世界不同人群用户,在使用过程中,可以生成自己想要的特定人群。

例如如果你提出“教室里的黑人老师”、“教室里的黑人老师”,那么Gemini应当给出的就是符合语境的结果。

那么现在问题出在了哪里?谷歌将此归结为2点:

首先,我们为了确保Gemini展示多种人群而进行了调整,但没有考虑到那些显然不应该出现的案例。

其次,随着时间的推移,模型变得比我们预期的要谨慎得多,完全拒绝回答某些提示——错误地将一些非常无害的提示判定为敏感词。

这两件事导致模型在某些情况下过度补偿(overcompensate),而在其他情况下又过于保守,导致生成的图片令人尴尬。

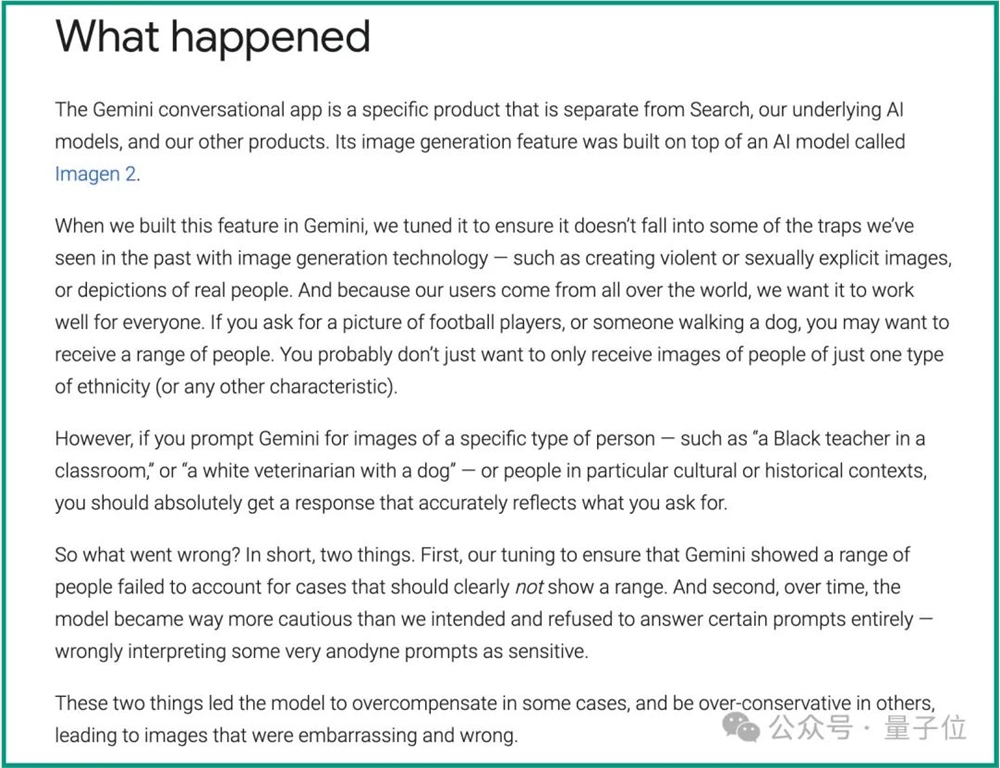

经验和教训

对此,谷歌坦言现在的结果并不是他们的初衷。

在这次“闭关整顿”的期间,谷歌表示Gemini的人物图像生成功能将进行广泛的测试,直到能力达标之后才会再次开放。

谷歌也基于这件事情做了一下反省:

Gemini是作为一个创意和生产力工具而构建的,它可能并不总是可靠,特别是在生成关于当前事件、不断发展的新闻或热点话题的图片或文本时。它会犯错误,正如我们从一开始就说过的,幻觉是所有大型语言模型的一个已知挑战——有时候AI就是会弄错事情。我们一直在努力改进这一点。

Gemini是有在努力给出真实的回答,例如我们的双重检查功能有助于评估网上是否有内容可以证实双子座的回答,但我们建议依赖谷歌搜索,因为它有独立的系统从网络上的各种来源提供新鲜、高质量的信息。

我们不能保证Gemini不会偶尔犯错,但可以保证的是,每当我们发现问题时都会采取行动做改进。人工智能是一项新兴技术,在很多方面都很有帮助、潜力巨大,我们正在尽最大努力安全、负责任地对其进行推广。

不过在谷歌这份声明发布之前,还有一件比较drama的事情。

马斯克在X中亲自爆料称,谷歌一位高管和他在前一晚打了一个小时的电话,并向马斯克保证会解决Gemini在种族和性别歧视上的问题。

不过网友们也是调皮,又把“黑人版马斯克”搬出来了:

你问他这张照片是怎么个事儿了吗?

不过有一说一啊,Gemini这次犯的错只能说是谷歌AI在种族、性别偏见上的一个“事件点”。

正如马斯克在回答网友问题中所说,他和谷歌高管的对话内容仅限于Gemini的改进,但其实谷歌其他很多产品同样也存在类似的问题。

谷歌搜索,不是第一次翻车

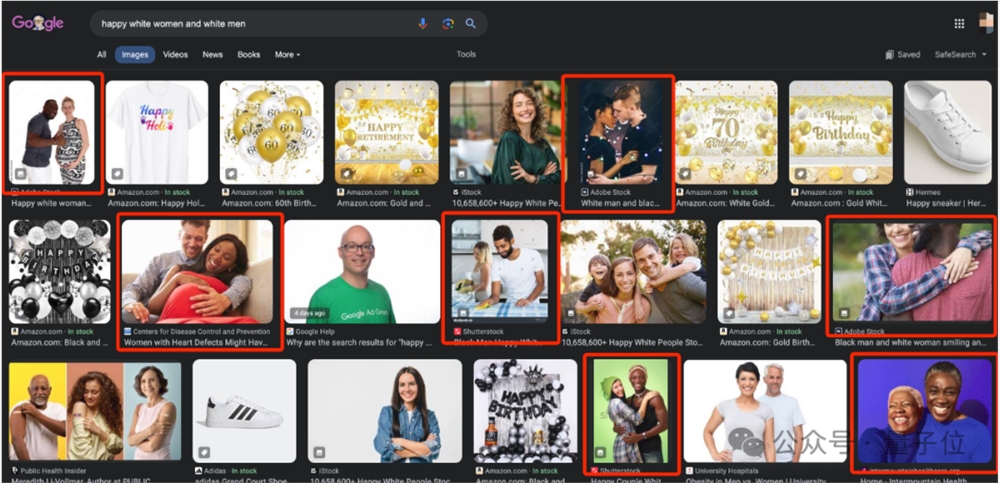

针对这一情况,我们亲自在谷歌搜索中尝试了一下。

例如在“谷歌图片”中输入:

快乐的白人女性和男性。

得到的结果是这样的:

嗯,搜索的要求是非常明确,但得到的结果,就是非得给你往里塞点黑人群体。

这就与谷歌在刚才的《致歉声明》中非常自信提到的“我们建议您依赖谷歌搜索”背道而驰。

趁着这次Gemini翻车,很多网友也是纷纷开始对谷歌搜索做测试,结果也是和我们的测试一致。

但如果我们把谷歌搜索的时间线拉长一点,就会发现这不是它第一次翻车。

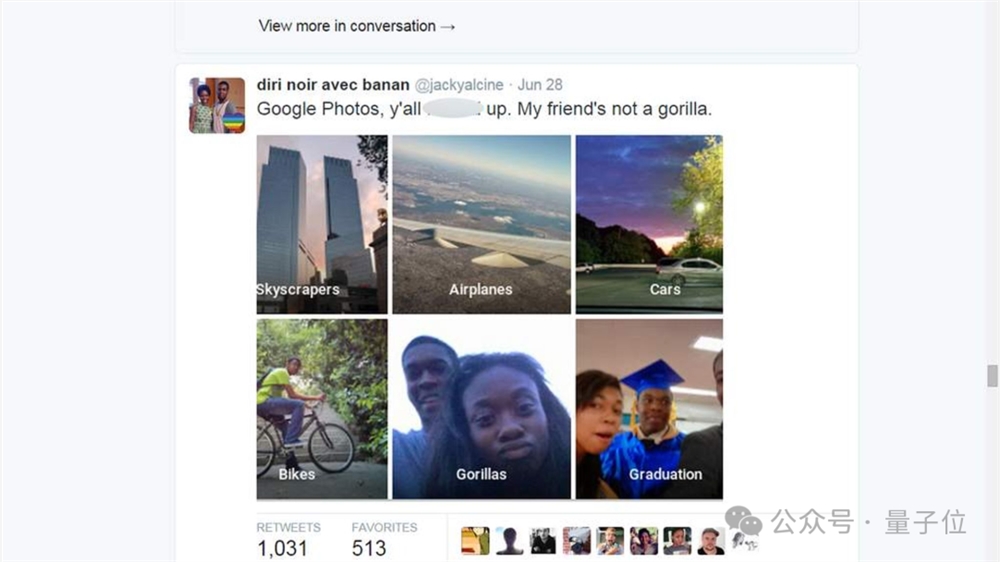

早在九年前(2015年),一位黑人兄弟Jacky Alciné就发现,谷歌图片就存在严重的歧视现象——

竟然把他的黑人朋友分类成了“大猩猩”!

当时这一消息可谓是轰动一时,谷歌闻讯同样是立即出面道歉,并表示整改。

但在数年之后,当人们再次检验整改效果时,却发现谷歌只是为图像识别算法去掉了“大猩猩gorilla”这个类别。

因此,加上Gemini这次引发的舆论,谷歌搜索九年来已经第二次在“黑人”问题上大翻车了。

不过这两次的翻车事件,或许也影射出了谷歌在技术发展的一个隐患。

从数年来谷歌在AI的发展中来看,虽然它的成果和进展依旧处于全球科技巨头的第一梯队,但近年来(尤其是在生成式AI)相比微软、Meta来说似乎并没有那么耀眼。

早在去年ChatGPT引爆生成式AI之际,微软和谷歌在火拼的过程中,谷歌的动作多次慢半拍;后来被曝出内部像当时Bard这样的产品早就有了,只是高层的顾虑太多,迟迟没有推进。

或许就是谷歌内部事事追求“政治正确”,用力过猛,反而造成了在技术上的笑话。

One More Thing

在马斯克多条怒喷谷歌的帖子中,有这么一条是比较有意思的。

他po出了四张贾斯廷·特鲁多的照片,穿戴不同民族服装,甚至还有黑人版的照片,并附上文案:

我不敢相信Gemini竟然生成了这些特鲁多的假照片。

但实际上,这些照片都是特鲁多的真实照片,也因为这些照片他此前深陷过“种族歧视”的舆论中。

不得不说,马斯克,你是懂阴阳的。

参考链接:

[1]https://blog.google/products/gemini/gemini-image-generation-issue/

[2]https://twitter.com/elonmusk/status/1760677431961407672

[3]https://twitter.com/elonmusk/status/1761020387691790399

[4]https://twitter.com/RichardHanania/status/1760874143049035953

- 0000

- 0000

- 0000

- 0000

- 0001