HuggingFace推出最大的开放合成数据集Cosmopedia 250亿个tokens

划重点:

- 🌍 Cosmopedia v0.1是由 Mixtral7b 生成的最大开放合成数据集,包含超过3000万个样本,总共约250亿个tokens。

- 💻 数据集汇编了来自网页数据集(如 RefinedWeb 和 RedPajama)的信息,涵盖教科书、博客文章、故事和 WikiHow 文章等各种内容类型。

- 📚 这一初始版本的 Cosmopedia 为合成数据领域的研究奠定了基础,展示了其在各种主题上的潜在应用。

HuggingFace 推出了 Cosmopedia v0.1,这是最大的开放合成数据集,由 Mixtral7b 生成,包含超过3000万个样本,总共约250亿个标记tokens。

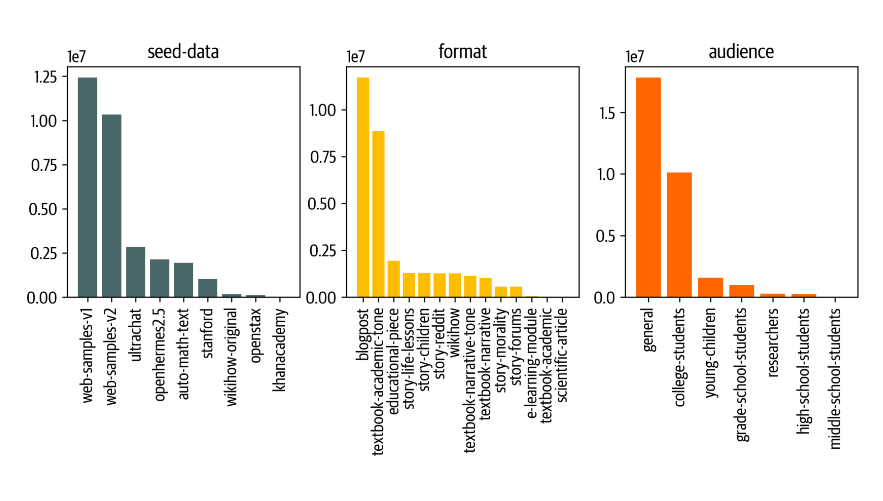

数据集旨在通过映射来自网页数据集如 RefinedWeb 和 RedPajama 的信息来汇编全球知识,包括教科书、博客文章、故事和 WikiHow 文章等各种内容类型。该数据集的结构分为八个部分,每个部分都源自不同的种子样本,其中包括 web_samples_v1和 web_samples_v2,占据数据集约75% 的比例,这些样本类似于 RefinedWeb 中的内部网页数据集。

Stanford 分区利用从 stanford.edu 网站上爬取的课程大纲,而故事分区则包含来自 UltraChat 和 OpenHermes2.5的生成故事。此外,WikiHow、OpenStax、KhanAcademy 和 automathtext 分区涉及与其各自来源相关的提示。

为了方便用户访问数据集,用户可以使用提供的代码段加载特定分区。另外,对于寻求缩减数据集的用户,还提供了一个更小的子集 Cosmopedia-100k。此外,还对 Cosmopedia 进行了训练,得到了一个更大的模型 Cosmo-1B,展示了其可扩展性和多功能性。

数据集的创建过程包括为 web 样本使用主题聚类方法、迭代地改进提示以及解决污染问题。其目标是通过量身定制提示风格和受众,最大程度地提高多样性,从而显著减少重复内容。

数据集入口:https://huggingface.co/datasets/HuggingFaceTB/cosmopedia

- 0000

- 0000

- 0002

- 0001

- 0000