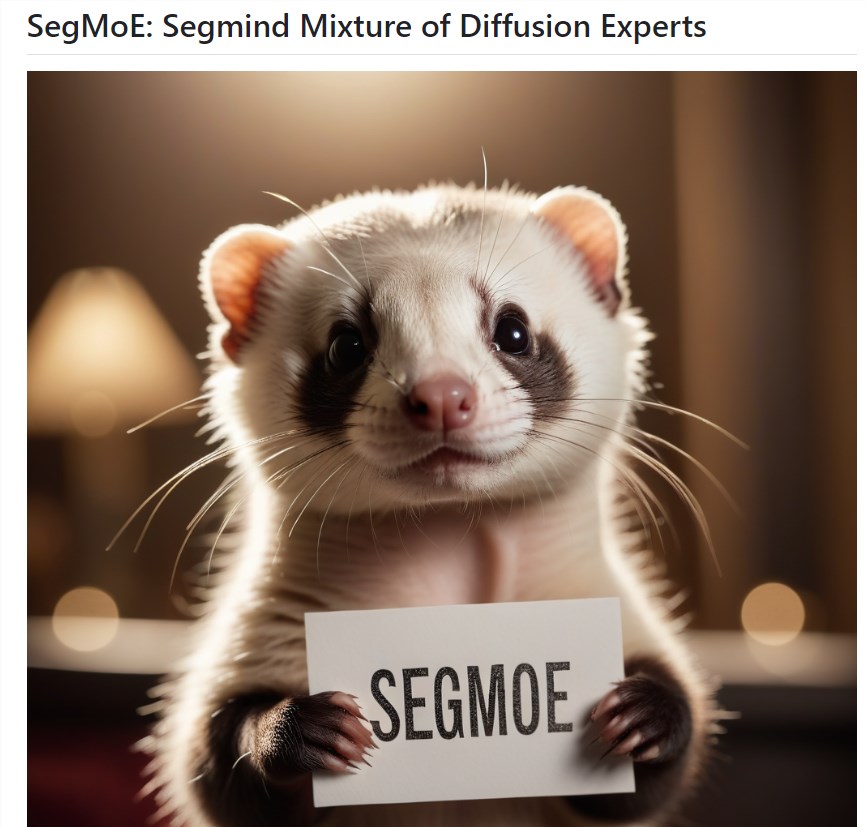

模型混合新方法SegMoE 无需训练即可混合多个SD模型

站长网2024-02-05 10:20:510阅

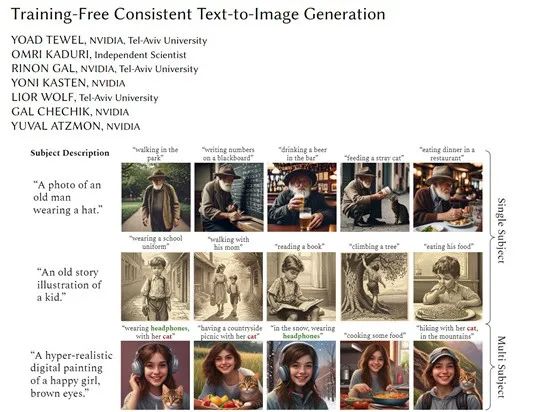

SegMoE 是一种无需训练就可以混合多个SD模型组成一个新的模型,类似LLM的MoE模型。据称,他们提供了三个已经混合好的模型,分别由2个SDXL、4个SDXL和4个SD1.5模型组成。

项目地址:https://top.aibase.com/tool/segmoe

然而,单纯从他们提供的测试图片,不太能看出混合模型和普通模型的质量差异。除了已经混合好的模型之外,他们还提供了混合模型的相关代码和教程。

这些混合模型的优势在于可以同时适应多种风格,但是问题在于模型整体并没有表现出明显比内部单个专家模型更好的质量。此外,显存占用和生成速度也存在问题。

因此,尽管SegMoE 提供了一种新颖的模型混合方法,但仍然需要进一步的改进来提高其性能和效果。

0000

评论列表

共(0)条相关推荐

- 0001

- 0000

- 0001

- 0000

- 0000