Nomic AI发布开源嵌入模型Nomic Embed,击败OpenAI的Ada-002

**划重点:**

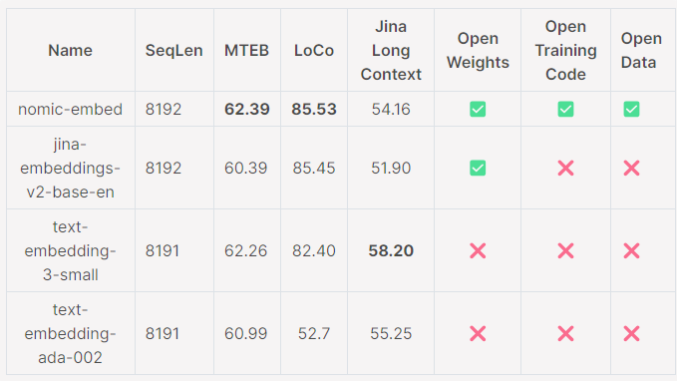

1. 🏆 Nomic Embed在短文和长文任务中胜过OpenAI的Ada-002和text-embedding-3-small模型。

2. 🔍 模型支持最大8192的上下文长度,通过Massive Text Embedding Benchmark (MTEB)和LoCo Benchmark表现优异。

3. 📢 Nomic Embed提供完整的可复制、可审计的模型,可通过Nomic Atlas Embedding API免费使用,也适用于企业级应用。

Nomic AI最新发布的开源嵌入模型Nomic Embed正式亮相,以卓越的性能超越了OpenAI的Ada-002和text-embedding-3-small模型。这一消息是由THE DECODER的在线记者Matthias Bastian于2024年2月1日发布的。

Nomic Embed在短文和长文任务中表现出色,成为Massive Text Embedding Benchmark(MTEB)和LoCo Benchmark的佼佼者。值得一提的是,该模型支持最大8192的上下文长度,为处理更为复杂的任务提供了强大的能力。

然而,Nomic Embed在Jina Long Context Benchmark上略显不足。尽管如此,该模型通过发布模型权重和完整训练数据,实现了对模型的全面审计,为用户提供了极高的可信度。

Nomic Embed不仅具备卓越性能,还提供了Nomic Atlas Embedding API,用户可以免费获得一百万个令牌,用于生产工作负载。此外,企业用户还可以选择使用Nomic Atlas Enterprise套餐,更好地满足企业级需求。

Nomic AI的这一突破性开源项目是对人工智能领域的一项重要贡献。

项目网址:

https://huggingface.co/nomic-ai/nomic-embed-text-v1

https://docs.nomic.ai/reference/endpoints/nomic-embed-text

- 0000

- 0000

- 0000

- 0000

- 0001