CodeFuse微调框架MFTCoder升级v0.3.0版本 支持Mixtral等模型

MFTCoder 是蚂蚁CodeFuse开源的一种多任务微调框架,可以在多个任务上同时进行微调。它通过结合多种损失函数解决了多任务学习中的挑战。MFTCoder 具备高效训练特征,包括高效的数据 Tokenization 模式和支持 PEFT 微调,能提升微调训练速度并降低资源需求。

MFTCoder 在 v0.3.0版本中进行了重磅升级。

首先,它支持了 Mixtral 等更多的主流开源 LLMs 模型,如 Mistral、Deepseek-coder、Chatglm3等。这些模型经过 MFTCoder 微调后,在代码能力上有了显著的提升。

其次,新版本适配了最新的 transformers v4.36.0和 FlashAttention2v2.3.6,使得 MFTCoder 可以更好地利用最新的 Attention 实现,如 sliding_window Attention,进一步提升模型性能。

第三,MFTCoder-accelerate 框架在原有支持 Accelerate DeepSpeed 的基础上,增加了对 FSDP 的支持,提供了更多的选择。

最后,MFTCoder 引入了 Self-Paced Loss 作为新的收敛均衡技术,可以调整不同任务的权重,控制不同任务的收敛速度,实现多任务同时收敛。

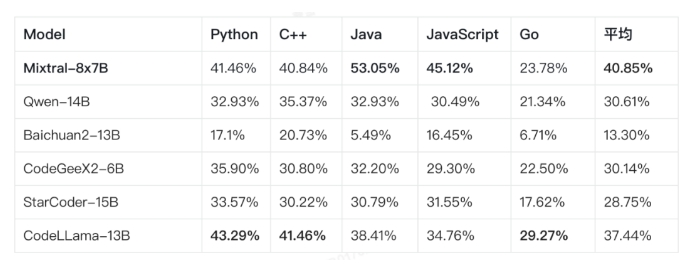

通过多任务微调,CodeFuse-Mixtral-8x7B 在各种语言的 Pass@1评测中的性能得到了显著提升,达到40.9% ->52.8%。这使得 CodeFuse-Mixtral-8x7B 成为当前开源的非代码大模型中代码能力领先的模型之一。

项目地址:https://github.com/codefuse-ai/MFTCoder/tree/main/mftcoder_accelerate

- 0000

- 0000

- 0000

- 0000

- 0000