智源推Vision Mamba 高效处理视觉任务,内存能省87%

要点:

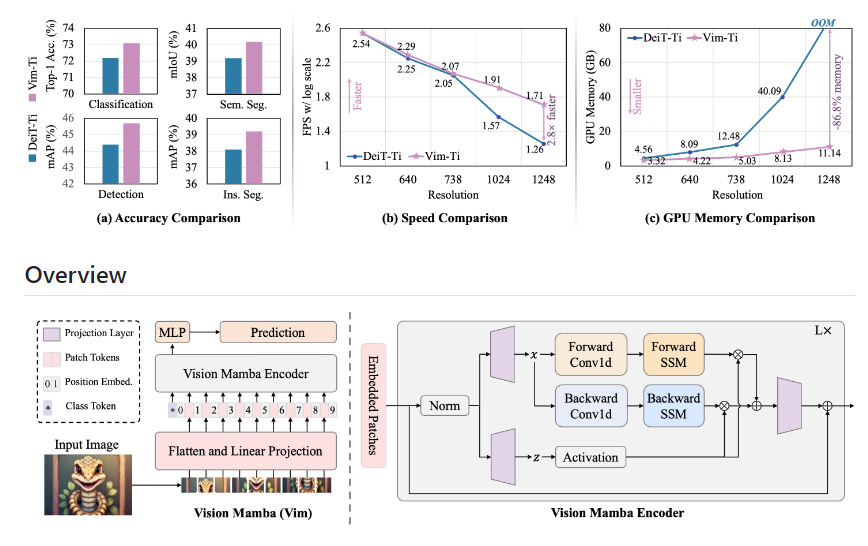

1. Vision Mamba在图像分类任务、对象检测任务和语义分割任务上性能更高,同时提高计算和内存效率。

2. Mamba的提出引发了对状态空间模型的兴趣,并在语言建模中取得成功。

3. Vision Mamba块整合了双向序列建模和位置嵌入,实现了高效的视觉任务处理。

Vision Mamba 是一种新的视觉模型,通过引入状态空间模型(SSM)来进行视觉建模,并在 ImageNet 分类、COCO 对象检测和 ADE20k 语义分割任务上实现了更高的性能。

项目地址:https://github.com/hustvl/Vim

与传统的基于 ConvNet 的网络相比,Vision Mamba 在 ImageNet 分类任务中表现更好,并且比基于 Transformer 的视觉模型 DeiT 具有更高的分类准确率。此外,Vision Mamba 在 GPU 内存和高分辨率图像推理时间方面也更加高效。

Vision Mamba 使用双向序列建模和位置嵌入来解决视觉任务中的单向建模和缺乏位置感知的问题。通过将图像转换成展开的二维 patch,并在每个 patch 上进行线性投影和位置嵌入,Vision Mamba 能够更好地捕捉图像中的视觉上下文和位置信息。

在实验中,Vision Mamba 在 ImageNet-1K 数据集上进行了基准测试,并与传统的基于 ConvNet 的网络、基于 Transformer 的视觉模型和基于 SSM 的骨干网络进行了比较。结果表明,Vision Mamba 在分类、语义分割和对象检测等任务上都具有优越的性能。同时,Vision Mamba 在高分辨率图像和长序列多模态应用中具有线性扩展的优势。

Vision Mamba 是一种高效的视觉模型,通过引入状态空间模型和位置嵌入来提高视觉任务的性能。它在各种任务中都展现出了比传统模型更好的表现,并且具有更高的计算和内存效率。Vision Mamba 的出现为视觉基础模型的发展带来了巨大的潜力。

- 0000

- 0000

- 0003

- 0000

- 0000