书生·浦语2. 0 正式开源 支持200K超长上下文

要点:

1、新一代大语言模型书生·浦语2.0支持200K超长上下文,综合性能领先。

2、书生·浦语2.020B版本性能在同量级模型中表现优异,数学推理方面超越ChatGPT。

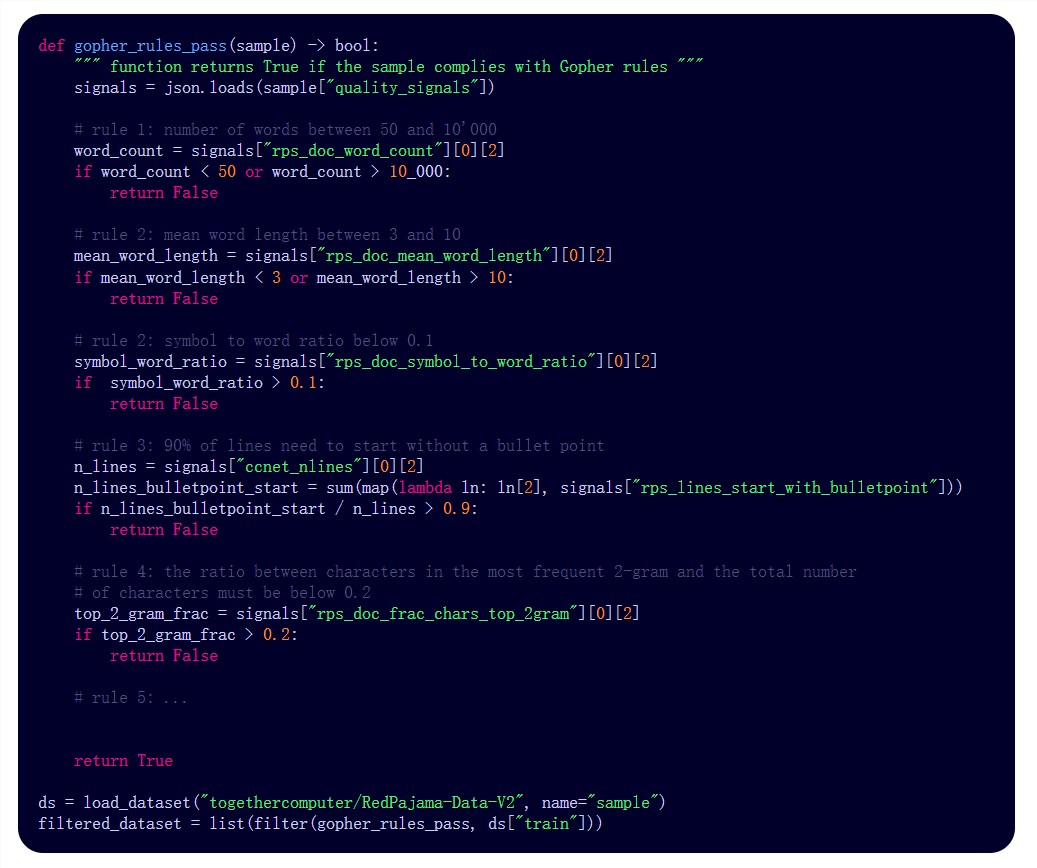

3、InternLM2的数据清洗过滤技术大幅提升模型训练效率。

新一代200亿「书生·浦语2.0」是一款开源的大语言模型。它支持200K超长上下文,且20B版本在数学推理方面的性能超越了ChatGPT。该模型使用了第三代数据清洗过滤技术,大幅提升了模型训练效率。

InternLM2可以支持200K超长上下文,约30万字文本,在「大海捞针实验」中实现了完美的召回率。相较于初代InternLM,新一代大模型轻量级及中量级性能表现优异,尤其在数学推理方面超越ChatGPT。

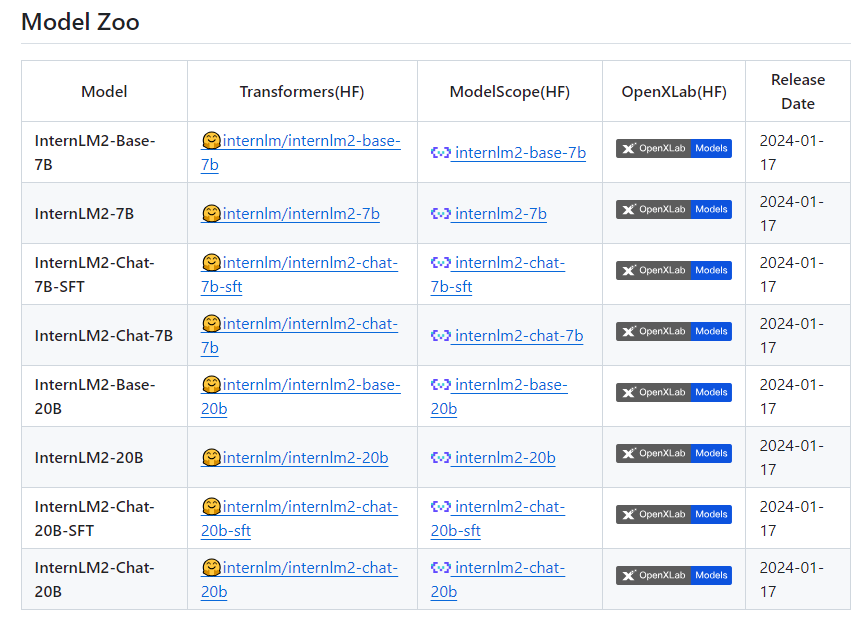

项目地址:https://top.aibase.com/tool/internlm2

新一代大语言模型书⽣·浦语2.0的性能表现领先于同量级开源模型,书⽣·浦语2.0综合性能全面领先。为促进AI生态发展,推动大模型在各行业的应用落地,书生·浦源大模型挑战赛同日启动。上海AI实验室秉持着「以高质量开源赋能创新」理念,继续提供InternLM2免费商用授权。

InternLM2的数据清洗过滤技术已经历三轮迭代升级,仅使用约60%的训练数据即可达到使用第二代数据训练1T token的性能表现,模型训练效率大幅提升。第三代数据清洗过滤技术大幅度提升模型训练效率。InternLM2在大规模高质量的验证语料上的Loss分布整体左移,表明了其语言建模能力的实质性增强。

这款新一代的大语言模型在各项能力上获得了全面进步,相比于初代InternLM,在推理、数学、代码等方面的能力提升尤为显著,综合能力领先于同量级开源模型。且轻量级及中量级版本性能在同量级开源模型中表现优异,超越了ChatGPT。整体表现上,InternLM2达到了与ChatGPT比肩的水平。

- 0000

- 0000

- 0002

- 0001

- 0002