MosaicML发布大型语言模型 MPT-7B 可商用

站长网2023-05-11 12:02:560阅

MosaicML 的 MPT-7B 是一个具有近70亿个参数的大型语言模型,该团队在自己的近万亿个标记的数据集上对其进行了训练。

MosaicML 遵循 Meta 的LLaMA模型的训练方案。培训花费近200,000美元,使用 MosaicML 平台耗时9.5天。

MosaicML表示,MPT-7B 与 Meta 的70亿参数 LLaMA 模型的性能相匹配,使其成为第一个达到该水平的开源模型,领先于OpenLLaMA。与 Meta 的模型不同,MPT-7B 已获得商业使用许可。

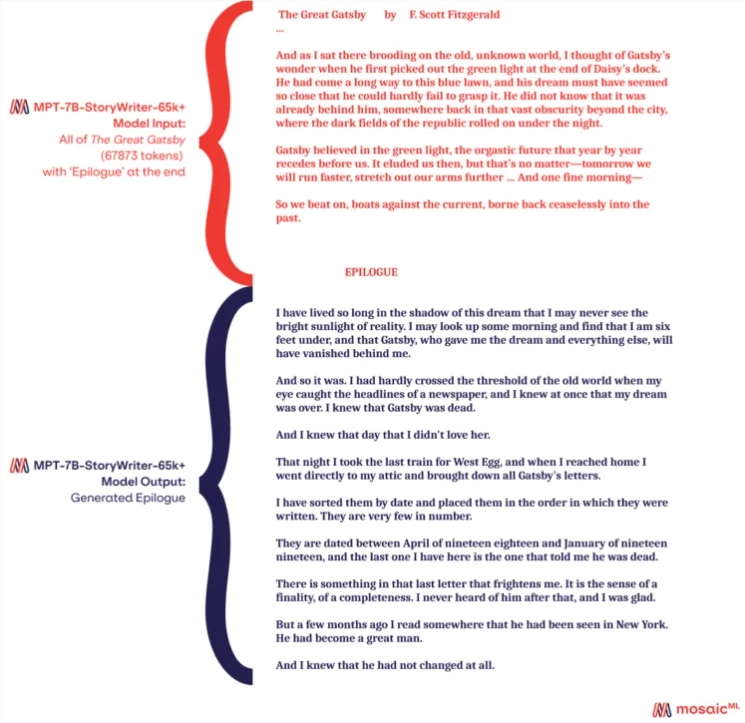

除了“MPT-7B Base”模型,MosaicML 还发布了三个变体:MPT-7B-StoryWriter-65k 、MPT-7B-Instruct 和 MPT-7B-Chat。

借助 MPT-7B-StoryWriter-65k ,MosaicML 还发布了一个模型,该模型能够读取和写入上下文长度非常长的故事。为此,使用 books3数据集的子集对 MPT-7B 进行了微调,上下文长度为65,000个标记。OpenAI 最大的 GPT-4变体能够处理32,000个标记。

根据 MosiacML 的说法,该模型可以通过一些优化扩展到超过65,000个token,并且该团队已经在使用 Nvidia A100-80GB GPU 的单个节点上展示了多达84,000个token。但即使有65,000个token,也可以阅读整部小说并写一篇结语。

项目网址:https://github.com/mosaicml/llm-foundry

0000

评论列表

共(0)条相关推荐

- 0000

- 0000

- 0000

- 0000

- 0000