OpenAI开发新工具,试图解释大语言模型的行为

在很多人看来,与OpenAI 的 ChatGPT类似的大型语言模型 (LLM)就像一个黑匣子,因为即使对于数据科学家来说,也很难知道为什么这些模型总是以自己的方式做出反应,就像凭空捏造事实一样。

为了能够剖析 LLM 的的行为,OpenAI 正在开发一种工具来自动识别 LLM 的哪些部分对其行为负责。简单的说,OpenAI在最新的发布成果中,展示了用 GPT-4解释 GPT-2的行为,获得了初步的成果。

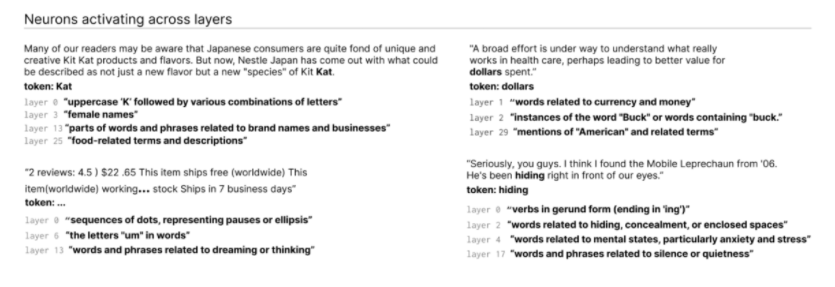

OpenAI开发的工具通过调用 GPT-4来计算出其他架构更简单的语言模型上神经元的行为。该工具会为 LLM 中的每个神经元生成解释,这些解释被编译到与工具代码一起发布的数据集中。

大模型(LLM)和人脑一样,由「神经元」组成,这些神经元会观察文本中的特定规律,进而影响到模型本身生产的文本。

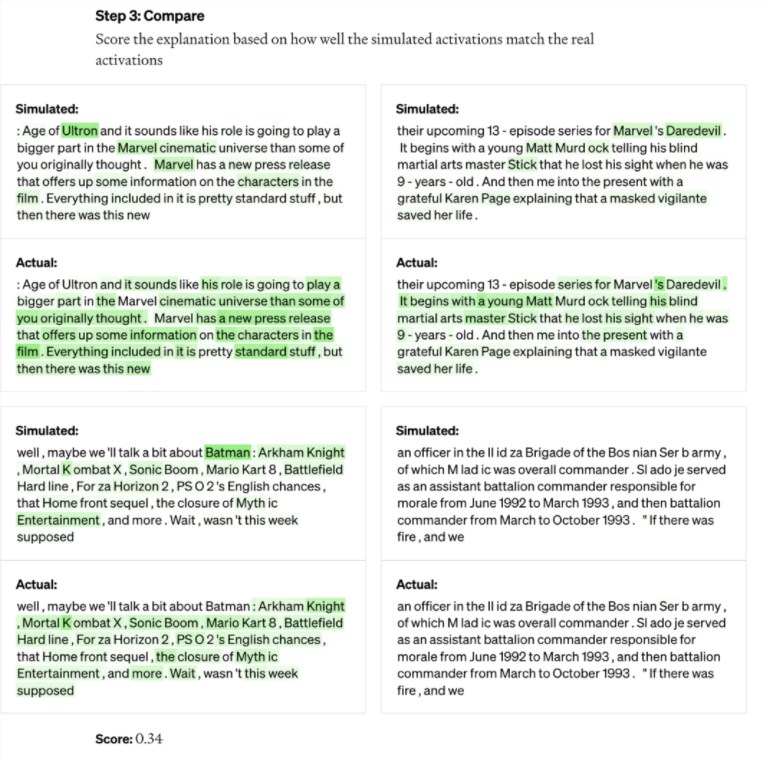

比如有一个针对「漫威超级英雄」的神经元,当用户向模型提问「哪个超级英雄的能力最强」时,这个神经元就会提高模型在回答中说出漫威英雄的概率。开始之前,先让 GPT-2运行文本序列,等待某个特定神经元被频繁「激活」的情况。

OpenAI 开发的工具利用这种规则将模型进行分解。

首先,让 GPT-4针对这段文本,生成解释。比如在下面的案例中,神经元主要针对漫威内容。GPT-4接收到文本和激活情况后,判断这与电影、角色和娱乐有关。接着,用 GPT-4模拟这个 GPT-2的神经元接下来会做什么,并用GPT-4生成的模拟内容。最后,进行对比评估。对比4代模拟神经元和2代真实神经元的结果,看 GPT-4猜的有多准。为了确定解释的准确性,该工具为 GPT-4提供了文本序列,并让它预测或模拟神经元的行为方式。然后将模拟神经元的行为与实际神经元的行为进行比较。

通过这样的方法,OpenAI 对每个神经元的行为作出了初步的自然语言解释,并对这种解释和实际行为的匹配程度进行了评分。

研究人员已经对 GPT-2中的所有307,200个神经元生成解释,并将这些解释汇编成数据集,与工具代码一起在 GitHub 上发布。

它背后的工程师强调它还处于早期阶段,但其运行代码已经可以在 GitHub 上以开源方式获得。OpenAI 的工具可以帮助研究人员更好地理解 LLM 的行为,从而提高性能并减少偏差或毒性。

也有人质疑,该工具本质上是为 GPT-4做广告,因为它需要 GPT-4才能工作。其他解释 LLM 工具较少依赖商业 API,例如 DeepMind 的Tracr。

- 0000

- 0000

- 0000

- 0000

- 0000