我们尝试用AI创作了一条圣诞动画(附ChatGPT+Pika等制作流程全记录)

最近,AI视频生成领域可以说是迎来了一波小爆发,前有明星产品Runway Gen2,后有黑马Pika1.0爆火,随着越来越多的玩家和产品涌入AI视频赛道,视频创作的门槛似乎越来越低了。

例如,今年圣诞节就有不少网友用Pika1.0整活,生成了各种脑洞大开的AI圣诞老人。

话不多说,下面请看圣诞老人的多重人生🔽

正在开圣诞摇滚专场的🎅🏻:

X博主“ponzponz15”还放出了他之前用Pika测试版生成的圣诞老人视频,可以看到,相比之下,Pika1.0生成的效果已经有了显著的提升。

日本动漫版圣诞老人🎅🏻:

无论是各大AI视频生成产品的宣传,还是网友晒出的作品,都让人觉得“人人皆是视频创作者”的时代来了,即使你不懂专业视频制作,也可以自己造一个AI圣诞老人,把脑海中的故事变成生动的视觉画面。

不过,这些视频具体是怎么制作的,用AI生成视频真有那么简单吗?“头号AI玩家”上手试了试,结合多个AI工具生成了这条圣诞动画🔽

下面,我们将详细解释这条圣诞动画制作过程,和生成过程中遇到的难点,希望给想要尝试AI视频生成工具的普通玩家带来一些启发。

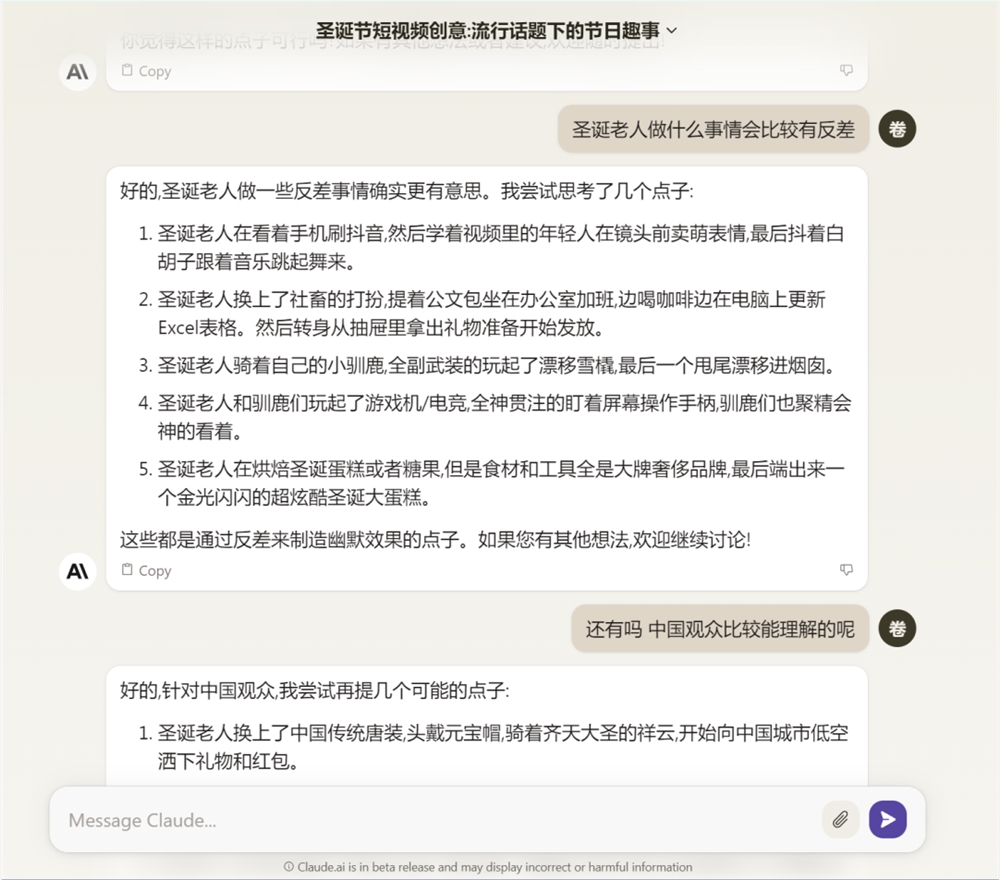

我们首先用AI辅助创作了视频脚本,选用Claude的原因在于它号称擅长创意故事写作。

最初,我们以“最会送礼的圣诞老人”为主题构思了三段小故事:

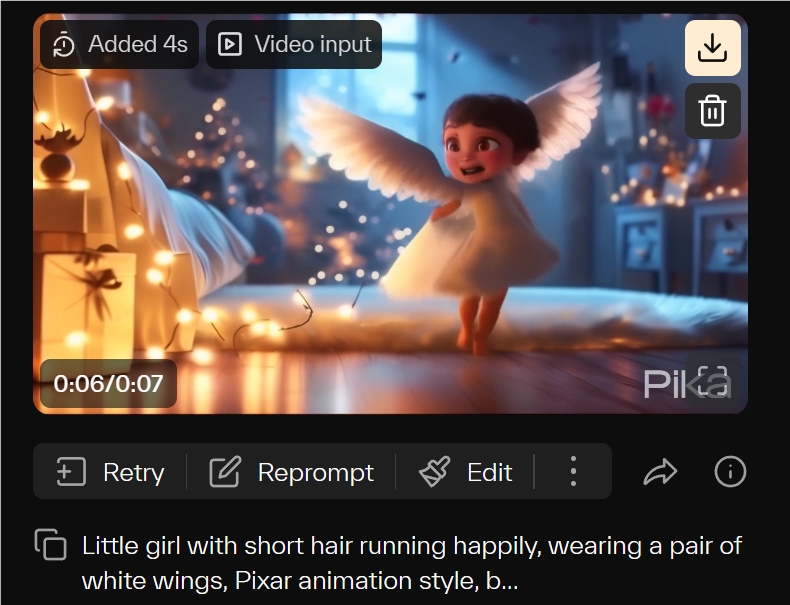

小女孩想要在天上飞,圣诞老人送了一对羽毛制成的翅膀,她穿上后高兴地跑了起来。

高中男生想要变成网红,圣诞老人把他在教室跳科目三的视频发到网上,第二天进学校同学都认识他了。

秃顶的中年程序员想要重返20岁,圣诞老人送了一顶假发,他戴上后果然看起来年轻不少。

三段小故事做成一个时长控制在1分钟以内,每个故事大概10个镜头的圣诞视频。

具体操作流程是,先大致构思镜头内容,通过文生图或文生视频工具,调整提示词得到关键画面之后,再借助市面上主流的AI视频工具生成视频片段。

首先,我们构思了第一个故事的分镜头脚本:

镜头1:一封信放在床头柜上,特写镜头,背景是一个小女孩在床上睡觉,室内,微弱的温暖灯光,圣诞氛围,皮克斯风格

镜头2:一双戴着红色手套的手拿起了这封信

镜头3:圣诞老人打开信正在阅读

镜头4:空白的信纸特写,主观视角

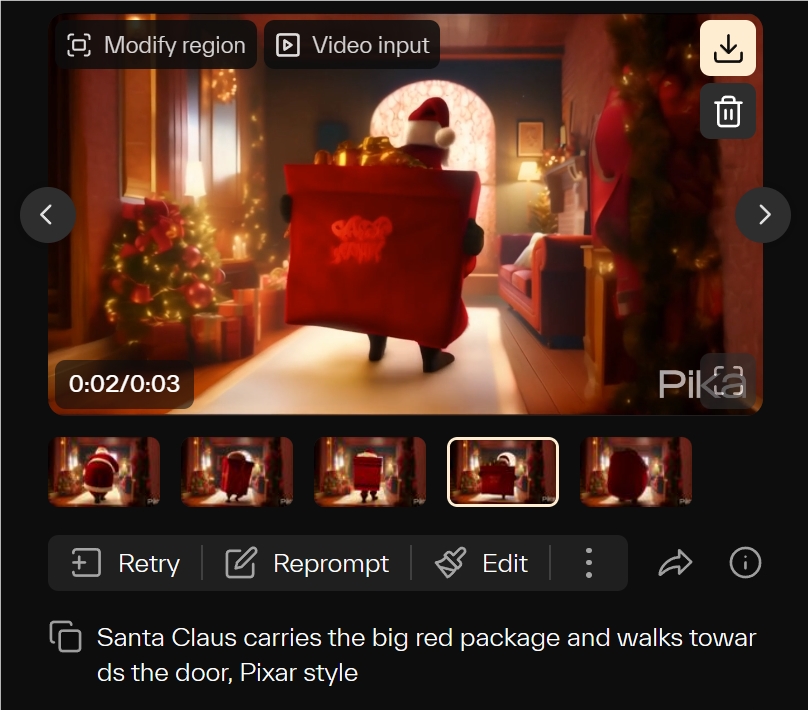

镜头5:圣诞老人背起大大的红色包裹,走向门口离开,中景

镜头6:小女孩被声音吵醒了睁开眼睛从床上坐起来,特写-近景

镜头7:主观视角,由模糊到清晰,中景,房间里的圣诞树上挂着一对白色羽毛做的翅膀,梦幻轻盈的感觉

镜头8:近景,小女孩高兴地穿上翅膀

镜头9:全景,从天花板俯视,小女孩在房间里跑了起来

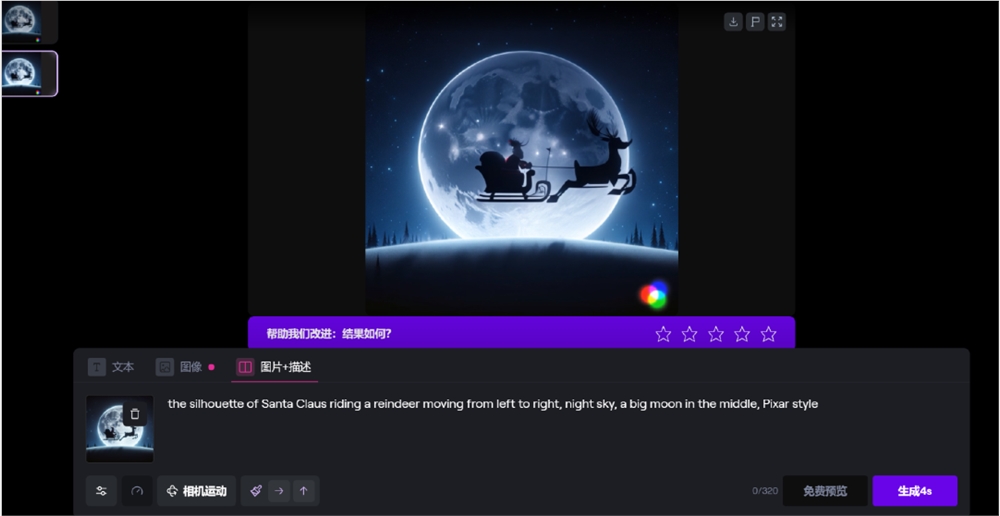

镜头10:镜头从天花板拉到外景夜空,中间一轮大月亮,圣诞老人骑着驯鹿的剪影在月亮上从右往左移动

这里需要补充说明的是,在实际操作中,我们发现叙事性强的视频生成所需的工作量并不小,因此缩减了故事数量,只保留了第一个故事。

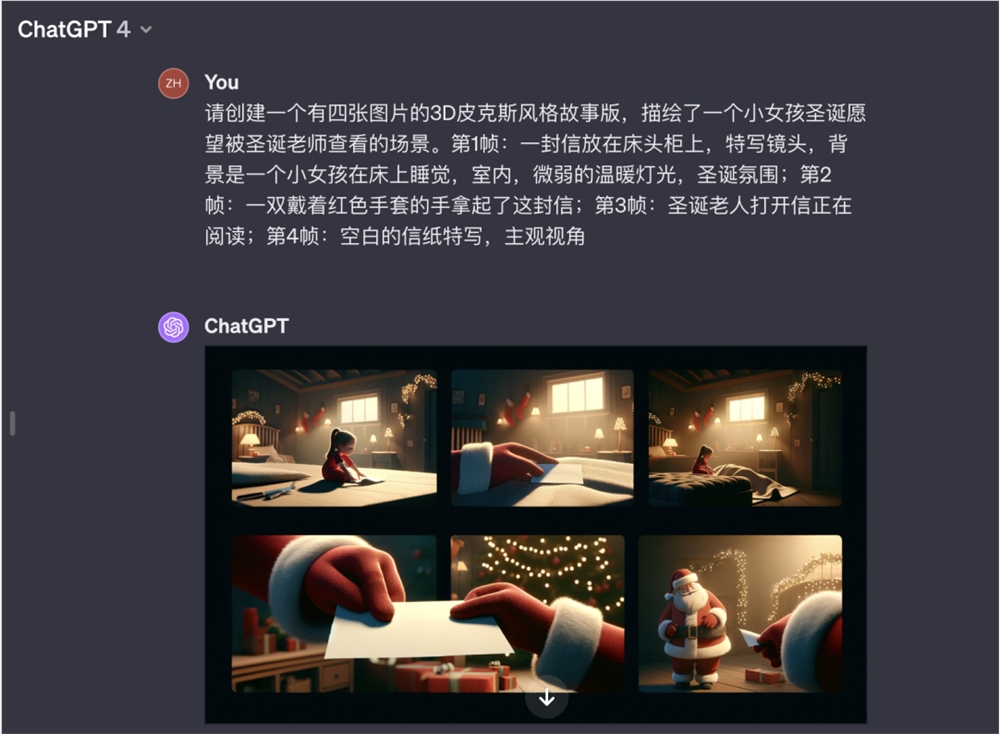

关键画面:ChatGPT Copilot Midjourney

接下来,我们把各个镜头的文字描述,修改成易于大模型理解的提示词后,喂给了GPT4,发现最大的问题是它并不能很好的理解文本,生成的图片无论是准确度还是细节一致性上都比较拉胯。

甚至会生成一些令人摸不着头脑的画面,比如,圣诞老人递信给圣诞老人。

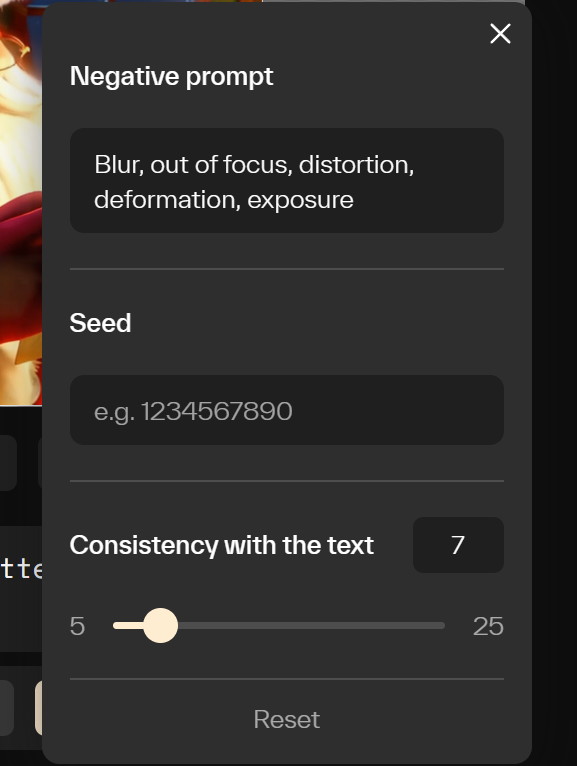

我们也尝试了直接用Pika1.0文生视频,但多番尝试下来发现,复杂的语句生成还存在大量问题,文字符合的程度不能调太高,调在10以内较合适,也要输入负面提示词,例如Blur, out of focus, distortion, deformation, exposure等。

同样的提示词,Pika文生视频和Dalle3文生视频/图片比较如下:

A letter lies on the bedside table, close-up, in the background a little girl sleeps on the bed, indoors, dim warm lights, Christmas atmosphere, Pixar style.

Pika1.0文生视频的效果🔽

Dalle3文生图的效果🔽

因此,我们决定先用微软的Copilot、DALLE3、Midjourney等文生图工具生成关键画面,再用Pika1.0图生视频。

在实测中,我们发现相比Copilot,DALLE3的语义理解更好。

少数镜头我们也尝试了Midjourney,在这三个主流文生图工具中,Midjourney明显视觉效果更好,质量更高,甚至还能表现俯视镜头。

最新的MidjourneyV6还可以生成完整清晰的英文文字“To Santa Claus”,相比之下其他两个文生图工具效果就不尽如人意。

不过为了尽量保持画面一致性,我们最终还是用DALLE3生成了最终视频中大多数的关键画面。

总的来说,在生成关键画面上,想用文字指挥AI干活比想象中更难一些,尤其是视频需要连贯性,镜头与镜头之间的衔接、画面风格的一致性,都需要反复调整描述词。

多番尝试下,我们意识到“文生图”后再“图生视频”这个工作流,只适合镜头数少的视频,甚至可以说不太适合故事性强的视频生成。

于是,我们不得不减少了几个镜头,再进入视频片段生成这一步骤。

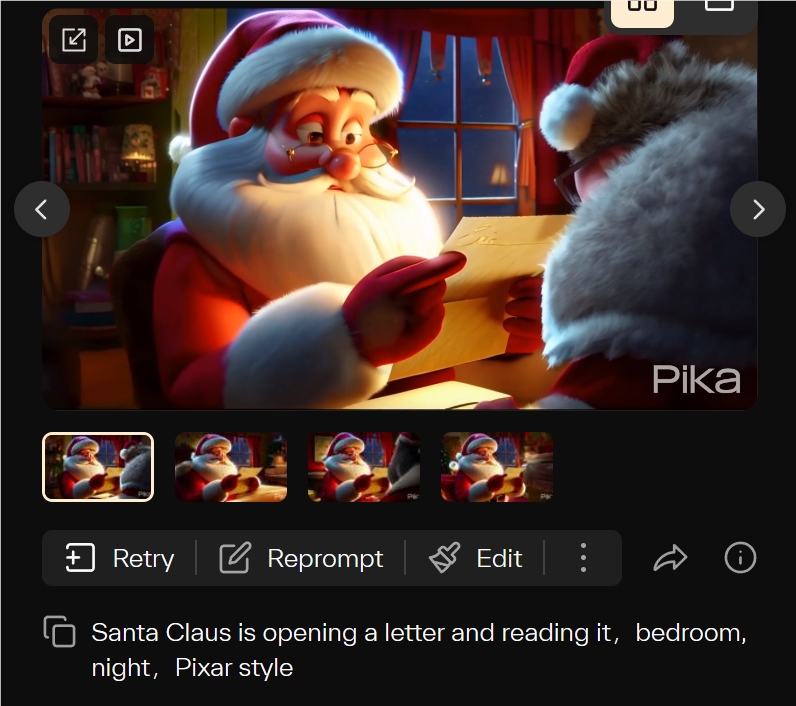

视频生成:Pika1.0 Runway Gen2

完成文字脚本和基础分镜之后,我们便需要考虑如何让画面“动”起来。在Pika输入图片和文字后,即可生成3秒视频片段。

提示词:Santa Claus is opening a letter and reading it,bedroom, night,Pixar style

我们发现,Pika的“运动强度”选项基本只选1-2,再高的话,3秒内画面变形就太夸张了。如果选择0,就差不多是静态图片,比如这个画面几乎只有枕头有一点点起伏。

另外,如果不指定镜头运动方向的话,Pika默认就是缓缓推进。

由于Dall·E3的图片默认是1:1的正方形,Pika会按照原尺寸生成视频。如果需要修改尺寸,我们可以在生成后选择edit — expand canvas,将背景改成16:9,原图也可以移动位置和放大缩小。

扩展的画面生成内容不太对,可以点击Retry再生成一次,或者Reprompt修改提示词,适当一点降低文本相关性。

这一功能相比Runway生成视频更具优势,可以不断尝试获得自己心仪的动态画面。

当然,Pika的运动有时也会比较随机,动的不是自己想要的那部分。比如下面“圣诞老人背着包裹走向门口”,没有人物走动的画面,只有嘴动了。

我们就可以选择edit,modify region,框选想要运动的部分,输入提示词,再生成。

圣诞老人能往前走了,但是背着红色包裹这个就生成得不太好,Retry好几次都不理想,要么是包裹太大没有立体感,走路像飘着,要么是被穿在衣服里面,背上鼓起来一个大包。所以最后就放弃了。

之后小女孩的视频画面,原本选择的是motion0生成小女孩,但只有嘴小幅度动了一下。如果需要画面更生动,比如女孩的眼睛动一动,眨一眨,就需要使用延长视频功能Add4s。

这个过程中,提示词没变,但motion选项改成了2,眼睛和手都动了起来,只不过在细节上画面会变得模糊一些。

像奔跑、跳跃、转身等幅度较大的动作,如果使用延长就比较容易崩掉,会突然被吓一跳……

比如原本背对着镜头,突然头转了过来,但身体没跟上,治愈动画秒变恐怖片。

Runway的运动幅度整体比pika更小一点,此前上线的运动笔刷功能,可以精准控制生成内容的运动轨迹。

经过我们测试发现,Runway动态笔刷好用,只要有手就行!笔刷涂抹到哪里,哪里就立刻能够动起来。

比如视频画面“圣诞老人骑着驯鹿在空中移动”,我们用Pika调试了几次都不行,圣诞老人只能在原地蹦跶两下。

但Runway可以移动整体画面,使圣诞老人朝着指定方向移动,但唯一不足之处是驯鹿的腿还无法做到动态运动。

Pika视频

Runway提示词内容

整体来说,先文生图作为参考再生成视频,可以保持视频风格较为一致,但具体人物、背景、动作等细节的一致性就比较难控制,需要不断调整参数去尝试。

较复杂的叙事也需要拆分成更加明确的镜头来逐个生成,耗时较长,我们这10个镜头从构思到剪辑完成大概花费了8~9小时,其中大部分时间都在生图、生视频。

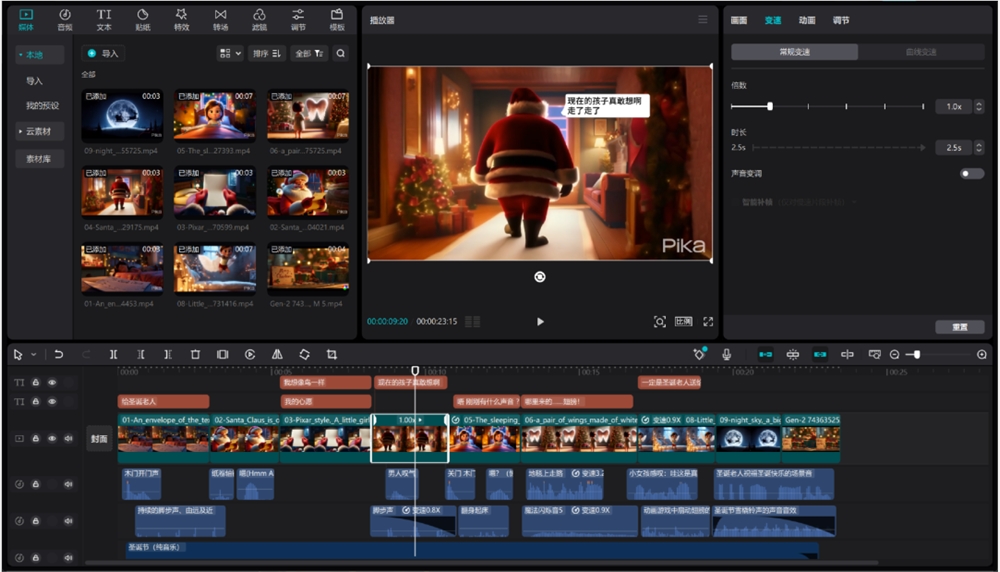

视频剪辑:剪映

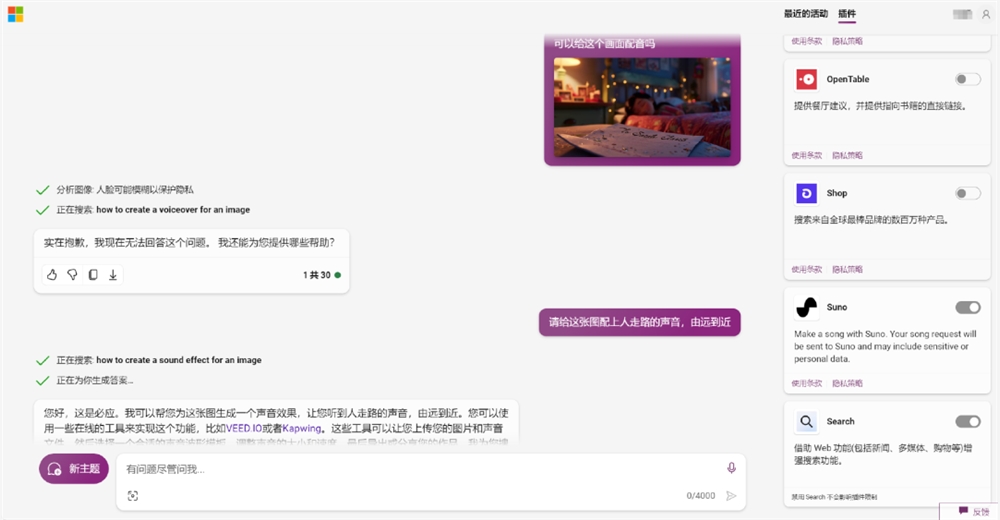

最后这一部分基本没有什么AI参与,本来想用copilot的suno插件生成视频配音,但遗憾的是没有响应。

在剪映里主要配了背景音乐音效和文字,都是素材库里选择的。部分视频画面做了延长/放大,没有加额外的特效。

由于镜头衔接不是特别完整,我们加了字幕来补充叙事,考虑到时长没有使用AI人声(文本朗读功能)。如果是做真人出镜或者有人声旁白的视频,也可以用AI数字人配音功能。

虽然整个制作流程没有想象中简便,调试的过程比较繁琐,没法在短时间内一比一还原脑海中的画面,但是,对于没有专业学习过动画制作的爱好者来说,AI可以帮助实现7、8成的故事脚本,已经大大降低了零基础创作者入门的门槛。

- 0000

- 0001

- 0000

- 0000

- 0000