南洋理工大学研究人员推出研究人员发布Upscale-A-Video:利用文本提示提升视频超分辨率

**划重点:**

1. 🌐 视频超分辨率面临多种挑战,NTU研究人员采用潜在扩散框架中的本地-全局时间一致性策略,通过文本提示引导纹理创作,实现真实细节的卓越提升。

2. 🔄 通过本地微调和全局潜在传播模块,研究团队解决了CNN模型在生成真实纹理方面的限制,提高了视频局部和整体结构的稳定性。

3. 🎥 研究结果展示Upscale-A-Video在超分辨率性能上表现卓越,通过对比人工智能生成和真实视频超分辨率,呈现出更高的视觉逼真度和更精细的细节。

近日,新加坡南洋理工大学(NTU)的研究人员成功发布了一项名为"Upscale-A-Video"的视频超分辨率技术,通过开创性的文本引导潜在扩散方法,旨在提升低质量视频的视觉质量。

视频超分辨率领域面临着在真实场景中常见的多样且复杂的降质问题,包括但不限于降采样、噪音、模糊、闪烁和视频压缩等因素。传统的基于卷积神经网络(CNN)的模型在缓解这些问题方面取得了一定进展,但由于生成能力有限,容易产生过度平滑的纹理,导致生成的视频缺乏真实感。

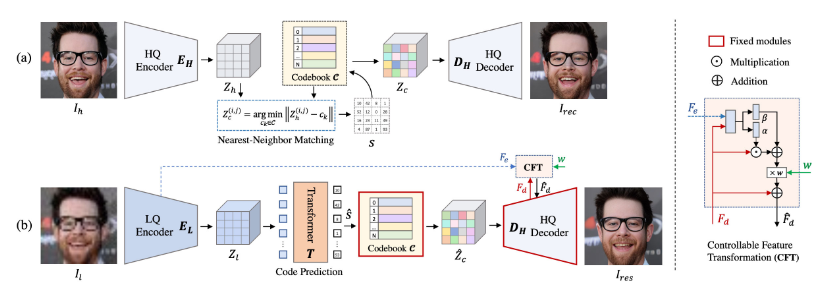

为了应对这些挑战,NTU的研究团队采用了本地-全局时间一致性策略,结合了潜在扩散框架。在本地层面,预训练的放大模型经过微调,集成了额外的时间层,包括3D卷积和时间注意力层,显著提高了本地序列的结构稳定性,减少了纹理闪烁等问题。同时,引入了一种新颖的流引导的递归潜在传播模块,以全局的方式进行操作,通过逐帧传播和潜在融合确保了较长视频的整体稳定性。

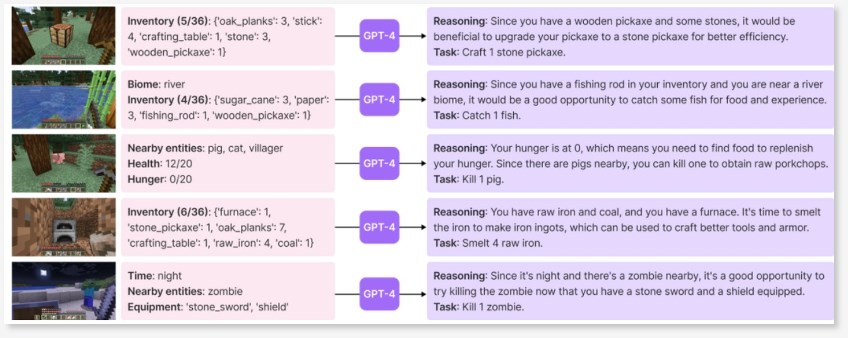

研究中探索了引入文本提示来引导纹理创建的创新方法,使模型能够生成更真实和高质量的细节。此外,通过向输入注入噪音,增强了模型对于重度或未知降级的鲁棒性,为恢复和生成之间的平衡提供了控制。较低的噪音水平优先考虑恢复能力,而较高水平则鼓励更精细的细节生成,实现了保真度和质量之间的权衡。

研究的主要贡献在于设计了一种强大的方法来解决真实场景视频超分辨率的问题,将本地-全局时间策略与潜在扩散框架相融合。通过引入时间一致性机制和对噪音水平和文本提示的创新控制,该模型在基准测试中表现出卓越的视觉逼真度和时间一致性。

NTU的研究不仅在技术上取得了显著进展,更为实现视频超分辨率的真实性和高质量提供了新的可能性。

- 0000

- 0000

- 0001

- 0000

- 0000