Together AI发布AI模型StripedHyena-7B 性能超越Llama-27B

划重点:

1. 🌐 StripedHyena-7B引领人工智能领域,提供计算效率和性能升级的替代选择。

2. 🚀 采用独特混合结构,StripedHyena在训练、微调和生成长序列时表现出色。

3. 💡 未来研究重点:构建更大的模型、引入多模态支持、提高StripedHyena模型的性能。

Together AI最新发布了StripedHyena-7B,这一人工智能模型领域的创新力量引起了广泛关注。该模型的基础版本为StripedHyena-Hessian-7B(SH7B),同时还推出了聊天模型StripedHyena-Nous-7B(SH-N7B)。StripedHyena基于上一年创建的一系列有效的序列建模架构(如H3、Hyena、HyenaDNA和Monarch Mixer)的重要经验教训。

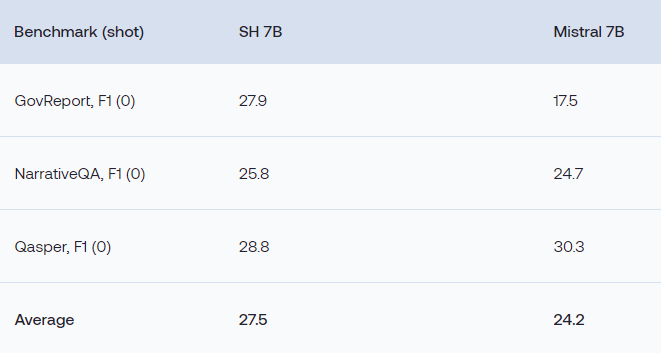

研究人员强调,StripedHyena在训练、微调和生成长序列过程中处理效率更高,具备更快的速度和更高的内存效率。通过采用独特的混合技术,StripedHyena将门控卷积和注意力结合成了所谓的Hyena运算符。在短序列任务中,包括OpenLLM排行榜任务,StripedHyena在性能上超越了Llama-27B、Yi7B以及最强大的Transformer替代品,如RWKV14B。

该模型在处理短序列任务和处理长提示的各种基准测试中都进行了评估。通过对Project Gutenberg书籍进行的困惑度缩放实验显示,困惑度在32k处饱和,或在此点以下减少,表明该模型能够从更长的提示中吸收信息。

StripedHyena通过将注意力和门控卷积组合成Hyena运算符的独特混合结构实现了高效性。研究人员采用创新的嫁接技术对这种混合设计进行了优化,使其在训练过程中能够进行体系结构修改。

研究人员强调StripedHyena的关键优势之一是其在训练、微调和生成长序列等各种任务中的提速和内存效率。在端到端训练的32k、64k和128k行上,StripedHyena相对于优化的Transformer基线(使用FlashAttention v2和自定义内核)分别提高了30%、50%和100%。

未来,研究人员希望在StripedHyena模型的多个领域取得重大进展。他们计划构建更大的模型,以处理更长的上下文,拓展信息理解的界限。此外,他们计划引入多模态支持,通过允许模型处理和理解来自文本和图像等各种来源的数据,提高模型的适应性。

StripedHyena模型有望通过引入额外的计算(例如在门控卷积中使用多个头部)在性能上超越Transformer模型。这种受线性注意力启发的方法在H3和MultiHyena等架构中被证明在训练期间提高模型质量,并为推断效率提供优势。读者可以查看该项目的博客和项目详细信息,对此研究给予所有研究人员应有的赞誉。

项目网址:https://huggingface.co/togethercomputer/StripedHyena-Hessian-7B

博客:https://www.together.ai/blog/stripedhyena-7b

- 0003

- 0000

- 0000

- 0001

- 0000