南大提出全新框架VividTalk 一张照片一段声音秒生超逼真视频

要点:

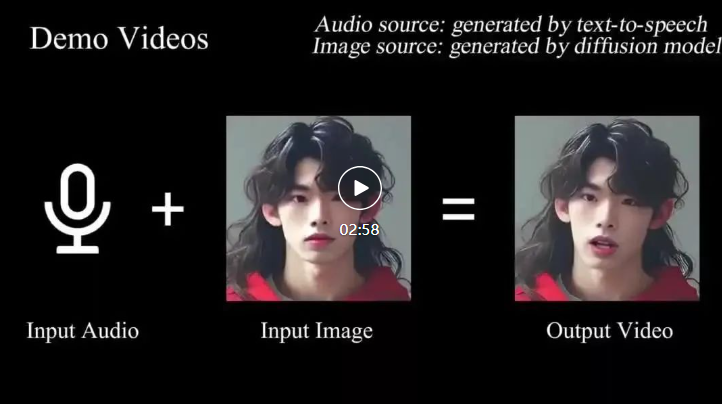

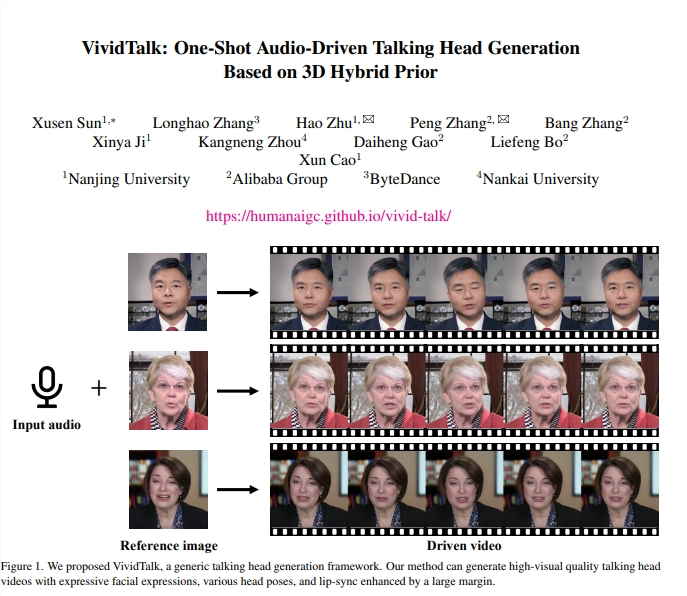

南大等机构研究人员提出的通用框架,名为VividTalk,能通过一段音频和一张照片生成高质量、富有表现力的说话视频,实现口型和音频的无缝对齐。

框架采用两阶段生成,第一阶段考虑面部运动和blendshape分布之间的映射,利用多分支Transformer网络建模音频上下文,第二阶段渲染内外表面的投影纹理,实现全面建模运动。

VividTalk在实验中展现出优越的生成质量和模型泛化性,支持多语言,能够生成具有丰富表情和自然头部姿势的口型同步头部说话视频。

近日,南大等机构的研究人员推出了一项引人注目的研究成果——VividTalk框架,其能够通过一段音频和一张照片实现令人惊叹的说话视频生成。这一通用框架采用了两阶段生成方法,首先通过考虑面部运动和blendshape分布之间的映射,利用多分支Transformer网络建模音频上下文,生成3D驱动的网格。

论文地址:https://arxiv.org/pdf/2312.01841.pdf

框架的第一阶段注重嘴唇运动和面部表情的生成,使用blendshape和顶点偏移作为中间表征,以提供全局粗略的面部表情运动和局部细粒度的嘴唇运动。为了更合理地学习刚性头部运动,研究人员巧妙地将问题转化为离散有限空间中的代码查询任务,并构建了可学习的头部姿势代码本。这一创新性的方法使得从音频到头部姿势的学习变得更加准确和高效。

第二阶段则在生成器中使用了双分支motionvae来建模2D密集运动,通过投影纹理表示在2D域中进行运动转换,提高了网络性能和生成视频的质量。VividTalk框架在实验中取得了显著的成果,能够生成具有表情丰富、自然头部姿势的口型同步视频。实验数据集的丰富性和优化的训练方法使得该框架在生成质量和模型泛化方面表现优越。

这一框架的推出代表了在语音合成领域的一次重要突破。VividTalk不仅支持多语言,而且在生成效果上也胜过了其他同类方法。这项研究成果将有望在虚拟人物、语音合成和视频制作等领域产生深远的影响。

- 0000

- 0000

- 0000

- 0000

- 0000