Meta发布高效SAM模型EffcientSAM 速度提升20倍!

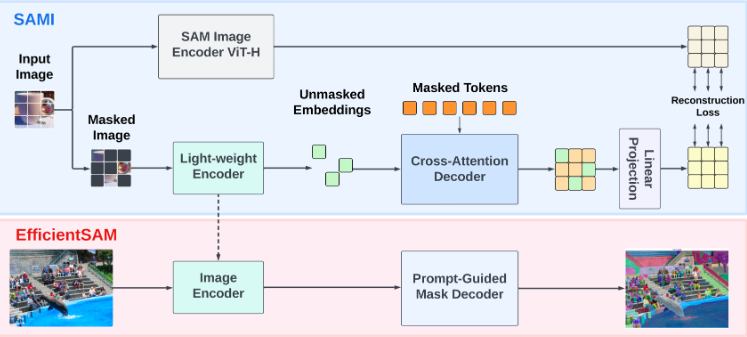

继万物皆可分割的SAM模型后,Meta又发布了更高效的EfficientSAM模型。EfficientSAM是一项创新性的工作,旨在降低SAM模型的计算复杂性,使其在更广泛的实际应用中表现出色。该模型通过引入掩码图像预训练(SAMI)成功降低了SAM模型的计算复杂性,实现了速度提升20倍、参数减少20倍,同时性能仅损失约1.5mIoU。

该方法的关键步骤包括在ImageNet上进行SAMI预训练,然后在SA-1B上进行SAM微调,通过SAM图像编码器和掩码解码器构建轻量级的EfficientSAM模型。在多个视觉任务上的综合评估表明,EfficientSAM在图像分类、目标检测、实例分割和语义目标检测等方面的性能表现均优于其他快速SAM模型。

项目地址:

https://yformer.github.io/efficient-sam/

在线demo地址:

https://6639e86fff1fc7b618.gradio.live

该研究的创新点在于提出了SAMI预训练方法,该方法通过学习从SAM图像编码器重建特征,实现了有效的视觉表示学习。相比其他掩码图像预训练方法,SAMI在零样本实例分割等任务上保持了更好的性能。通过EfficientSAM的引入,研究团队取得了在COCO/LVIS等数据集上显著的性能提升,为SAM模型的实际应用提供了更广泛的可能性。

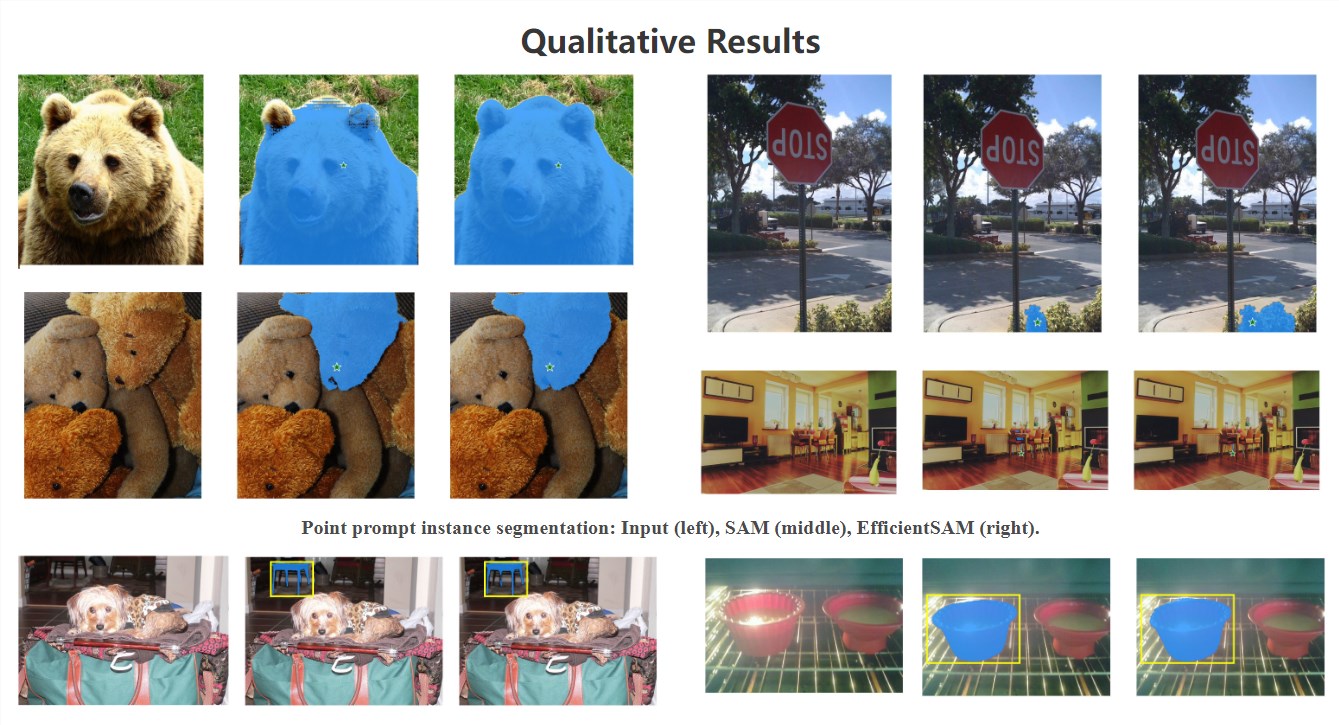

论文以清晰的结构呈现了EfficientSAM的框架、方法和实验结果。通过定量和定性的结果展示,读者可以直观地了解EfficientSAM相对于传统SAM模型的优越性。研究团队的BibTeX引用提供了对该工作的标准引用方式。总体而言,EfficientSAM通过降低SAM模型的复杂性,为实际的分割任务提供了更高效、更轻量的解决方案。

在实验结果中,EfficientSAM不仅在零样本实例分割任务中取得了显著的进展,而且在图像分类、目标检测等多个任务上也展现出了优越性能。论文通过图示结果直观地展示了EfficientSAM相对于SAM模型的优势,无论是在点提示实例分割还是盒提示实例分割等任务上,EfficientSAM都呈现出更精准的分割效果。

EfficientSAM的提出为SAM模型的进一步应用提供了新的可能性,特别是在计算资源有限的实际场景中。通过SAMI预训练方法的引入,研究团队成功平衡了性能和计算复杂性之间的关系,为轻量级分割模型的发展贡献了有价值的经验。

- 0000

- 0000

- 0000

- 0000

- 0000