Meta重磅推出Ego-Exo4D:视频学习与多模态感知研究的基础数据集

划重点:

🧠 多模态学习工具发布: Meta发布Ego-Exo4D,这是一个支持视频学习与多模态感知研究的基础数据集和基准套件,旨在为广大研究社区提供探索自我与外界视频、多模态活动识别等工具。

🌍 协作研究背景: 该数据集是Meta FAIR(基础人工智能研究)、Project Aria,以及15所大学合作两年努力的成果。

🤖 面向未来的AI应用: Ego-Exo4D不仅是最大的公共同步时间的第一人称和第三人称视频数据集,还提供多模态数据,包括音频、惯性测量单元、广角灰度摄像头等。

Meta最近宣布推出Ego-Exo4D,这是一项具有重大影响的举措,为视频学习和多模态感知研究提供了一套基础数据集和基准套件。该数据集是Meta FAIR(基础人工智能研究)与Project Aria以及15所大学两年合作努力的结晶。

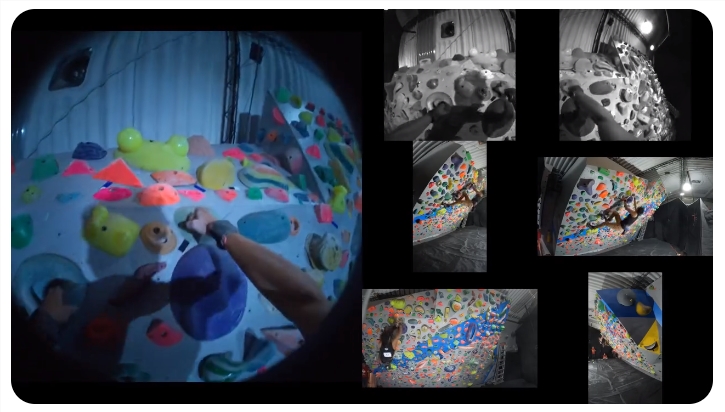

Ego-Exo4D的独特之处在于同时捕捉了参与者佩戴的可穿戴相机的第一人称“自我的”视角和周围相机的多个“外界”视角。这两个视角是互补的,第一人称视角展示了参与者所见和所听,而外界视角则展示了周围环境和上下文。这为AI模型提供了一个窗口,窥视复杂人类技能的奥秘。

通过FAIR和大学合作伙伴的联合努力,Ego-Exo4D捕捉了来自美国、日本、哥伦比亚、新加坡、印度和加拿大的800多位熟练参与者的视角。该联合体计划于十二月份开源数据,包括超过1,400小时的视频和用于新奇基准任务的标注。明年,他们计划举办首个公开基准挑战,并发布自我与外界理解的基准模型。

Ego-Exo4D的关注点是熟练的人类活动,如运动、音乐、烹饪、舞蹈和自行车修理。通过对人类技能在视频中的理解的进步,可以促使许多应用的发展。例如,在未来的增强现实(AR)系统中,戴着智能眼镜的人可以通过虚拟AI教练迅速掌握新技能;在机器人学习中,机器人观看其环境中的人们可以通过较少的实际经验获得新的灵巧操作技能;在社交网络中,新的社群可以根据人们在视频中分享他们的专业知识和互补技能而形成。

然而,实现这一潜力在今天的数据集和学习范式下并不可能。现有的包含自我和外界视角(即自我-外界)的数据集很少,规模小,缺乏跨相机的同步,或者过于策划或编辑以抵御现实世界的多样性。因此,目前关于活动理解的文献主要只涵盖自我或外界视角,无法在第一人称和第三人称视角之间流畅切换。

Ego-Exo4D构成了最大的公共同步时间的第一人称和第三人称视频数据集。构建这个数据集需要招募跨足不同领域的专业人士,汇集多样的群体共同创建多方面的AI数据集。所有情景都涉及现实世界的专业人士,相机佩戴者参与者在所展示的技能方面具有特定的资格、培训或专业知识。例如,Ego-Exo4D相机佩戴者包括职业和大学运动员;爵士、萨尔萨和中国民间舞蹈者和教练;竞技攀岩者;在工业规模厨房工作的专业厨师;以及每天服务数十辆自行车的自行车技师。

Ego-Exo4D不仅是多视图,还是多模态的。使用Meta独特的Aria眼镜拍摄,所有自我视频都伴随着与时间对齐的七通道音频、惯性测量单元(IMU)和两个广角灰度摄像头等多种传感器。所有数据序列还通过Project Aria的先进机器感知服务提供了眼球注视、头部姿势和环境的3D点云。

此外,Ego-Exo4D提供了多种新的视频语言资源:

相机佩戴者描述自己行动的第一人称叙述。对每位相机佩戴者行动进行的第三人称实况描述。对视频进行评论的第三人称口头专家评论。他们是具有特定领域专业知识的52名教练和老师,根据相机佩戴者的表现提供建议和评论。

所有这三种语言资源都与视频时间戳匹配。通过这些新颖的视频语言资源,AI模型可以了解熟练的人类活动的微妙方面。据我们所知,以前没有任何具有如此广泛且高质量的多模态数据的视频资源。

除了数据之外,他们还为自我-外界视频的基础任务提供了基准,以推动社区的努力。

他们提出了四个任务:

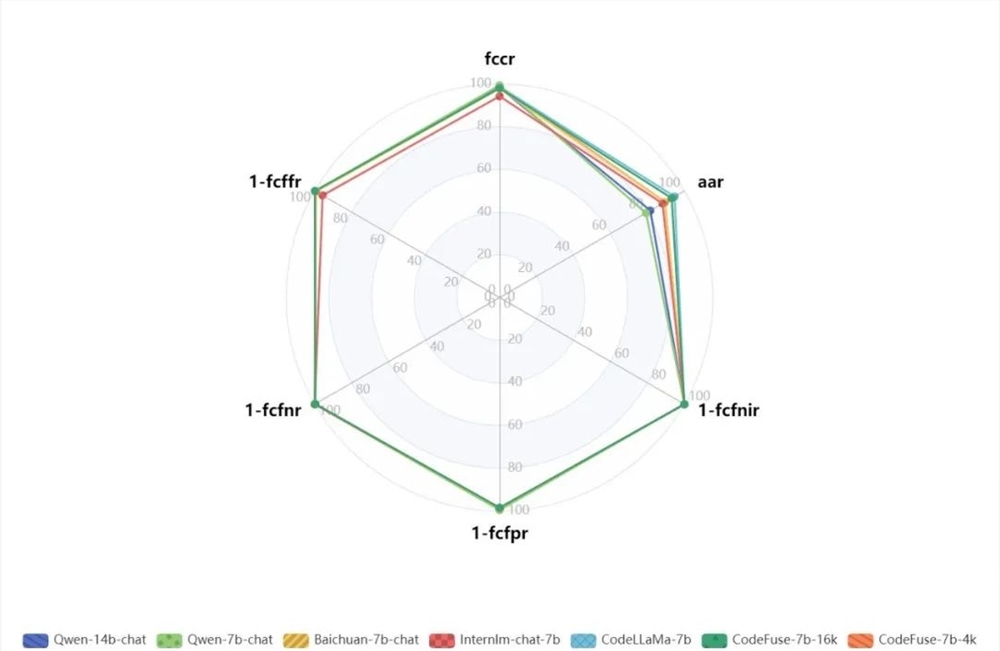

自我(-外界)识别:从自我(和/或可选的外界)视频中识别过程活动的微观关键步骤及其结构,即使在能量受限的情况下也可以。自我(-外界)熟练估计:推断一个人执行技能的程度。自我-外界关系:通过估计语义对应关系和转换视点,将老师(外界)的动作与学习者(自我)的动作相关联。自我姿势:仅从单眼自我视频中恢复专业人士的熟练动作,即3D身体和手势姿势。

他们为每个任务的培训和测试提供了高质量的标注,这是超过20万小时的标注员努力的结果。为了启动这些新挑战的工作,他们还制定了基准模型并报告了它们的结果。他们计划在2024年举办首个公开基准挑战。

Ego4D联合体是FAIR与全球十几所大学之间的长期合作。在2021年发布Ego4D之后,这支由专家教职员、研究生和工业研究人员组成的团队重新启动,推出了Ego-Exo4D项目。该联合体的优势既在于其集体的AI才能,也在于其地理广度,可以在各种视觉环境中记录数据。

Ego-Exo4D包括来自六个国家和七个美国州的视频,为AI开发提供了多样化的资源。联合体成员和FAIR研究人员在整个项目中进行了协作,从制定倡议范围,到收集数据集的独特组成部分,再到制定基准任务。该项目还标志着Aria眼镜在学术研究社区的单一最大协调部署,涉及12个不同地点的合作伙伴使用了这些眼镜。

通过发布这一规模和多样性前所未有的资源,该联合体旨在为视频学习中的核心AI挑战提供支持。随着这一研究方向的发展,他们设想未来的AI将使人们在增强现实和混合现实(AR/MR)中学习新技能的方式发生变革,如何视频在用户面前栩栩如生,系统充当虚拟教练,引导他们完成新的程序并提供建议以改进。同样,他们希望它将使未来的机器人通过观察熟练的人类专家获得复杂的灵巧操作洞察。Ego-Exo4D是实现这一未来的关键一步,他们迫不及待地期待看到研究社区如何应用它。

- 0000

- 0001

- 0000

- 0000

- 0000