Hugging Face发布高度优化的Zephyr-7B迷你语言模型 媲美70亿参数Llama-2

站长网2023-11-30 11:25:431阅

**划重点:**

1. 🌐 Hugging Face基于欧洲初创公司Mistral AI的开源模型Mistral7B,推出了Zephyr-7B迷你语言模型,并通过蒸馏监督微调(dSFT)方法对其进行了精细优化。

2. ⚙️ Zephyr-7B采用了蒸馏直接偏好优化(dDPO)方法,使用一组“教师”模型的输出作为偏好数据,显著缩短了训练时间,降低了所需资源。

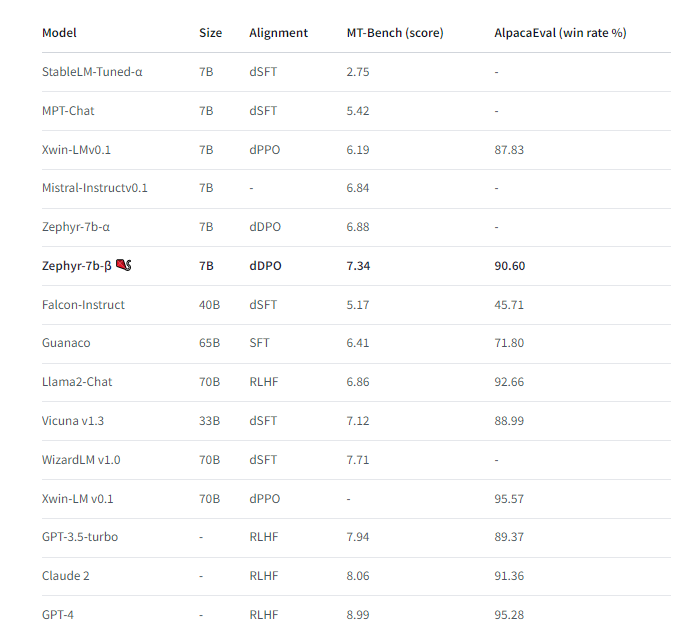

3. 🌐在基准测试中,Zephyr-7B略胜Mistral7B,甚至可以媲美具有70亿参数的Llama-2。

在最新的人工智能实践中,Hugging Face推出了经过高度优化的Zephyr-7B迷你语言模型,该模型基于欧洲初创公司Mistral AI的开源模型Mistral7B。通过采用蒸馏监督微调(dSFT)方法,该模型得以精细调整,该方法利用较大的“教师”模型的输出来训练较小的“学生”模型。

与此同时,Zephyr-7B还引入了蒸馏直接偏好优化(dDPO)方法,该方法利用一组教师模型的人工智能反馈作为偏好数据。这一创新性方法显著降低了训练时间,并减少了所需的计算资源。

在基准测试中,Zephyr-7B展现出令人瞩目的性能。相较于Mistral7B,它稍显领先,并且在具有70亿参数的Llama-2模型面前也能媲美一些性能指标。这标志着Hugging Face在迷你语言模型领域的技术进步,为未来的人工智能发展奠定了坚实基础。

模型网址:https://huggingface.co/HuggingFaceH4/zephyr-7b-beta

0001

评论列表

共(0)条相关推荐

- 0000

- 0000

- 0001

- 0000

- 0001