UC伯克利发布大语言模型榜单 清华ChatGLM冲进前五

站长网2023-05-05 11:10:181阅

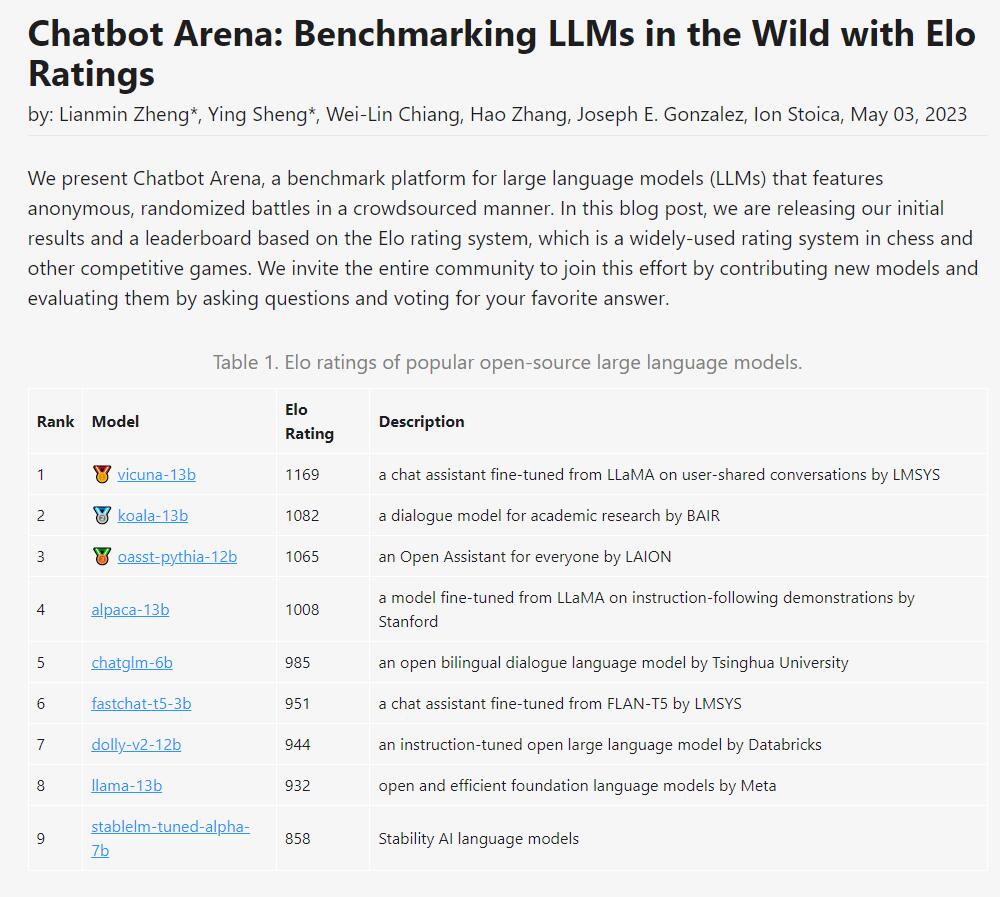

日前,UC伯克利发起了大语言模型版排位赛,让大语言模型随机进行battle,并根据它们的Elo得分进行排名。

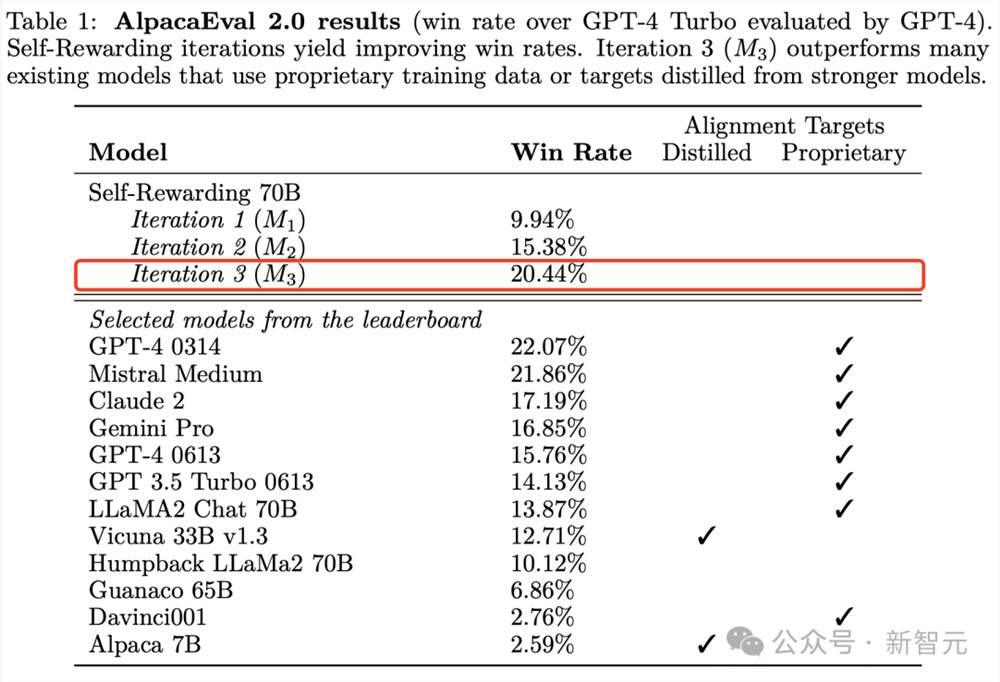

排行榜数据显示,Vicuna以1169分排名第一,Koala位列第二。这两个模型都有130亿参数。LAION的Open Assistant排在第三。

清华提出的ChatGLM,虽然只有60亿参数,但依然冲进了前五,只比130亿参数的Alpaca落后了23分。

相比之下,Meta原版的LLaMa只排到了第八(倒数第二),而Stability AI的StableLM则获得了唯一的800 分,排名倒数第一。

这个排位赛可以让人们更好地了解各个聊天机器人的表现,同时也能促进大语言模型的发展。该排位赛会把国内和国外的这些「闭源」模型都搞进来。目前,所有的评估代码以及数据分析均已公布。

团队表示,之后不仅会定期更新排位赛榜单,而且还会优化算法和机制,并根据不同的任务类型提供更加细化的排名。

0001

评论列表

共(0)条相关推荐

- 0000

- 0000

- 0000

- 0000

- 0000