大型语言模型DeBERTa:具有解纠缠注意力的解码增强型 BERT

站长网2023-11-29 11:07:310阅

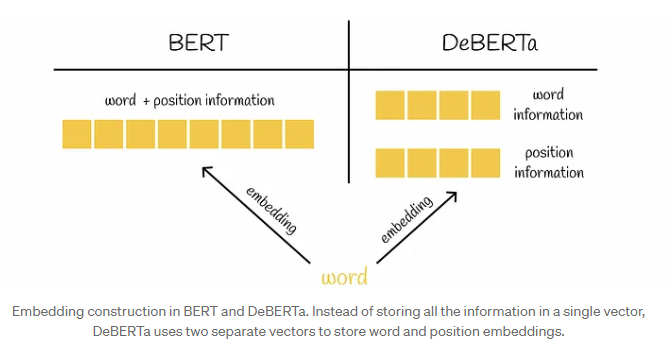

近年来,BERT在自然语言处理任务中取得显著成就,但DeBERTa通过引入“解缠注意力”和“增强遮罩解码器”等创新机制,进一步提升了模型性能。

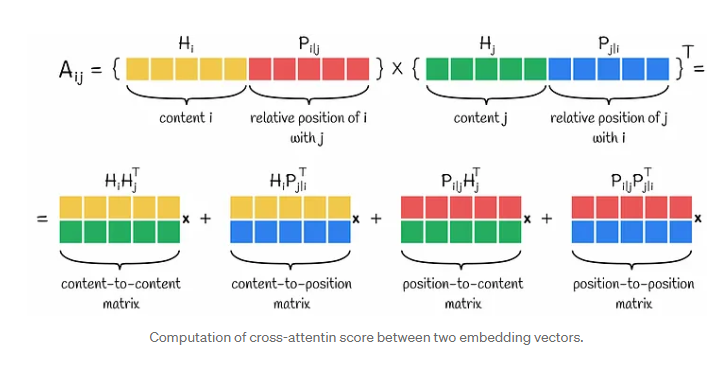

DeBERTa引入了解缠注意力,这是一种新颖的机制,其中每个令牌由两个单独的向量表示,考虑了内容和相对位置。注意力分数是使用一种独特的方法计算的,该方法考虑了令牌之间的相对距离。

论文地址:https://arxiv.org/pdf/2006.03654.pdf

DeBERTa通过引入增强蒙版解码器(EMD)来解决解缠注意力的局限性,该解码器包含绝对位置信息。这种添加提高了模型捕捉语言上下文的能力,例如对具有相似局部上下文但具有不同语言上下文的蒙版词的处理。

解缠注意力考虑内容和相对位置,通过独特的计算方法获得注意力分数。增强遮罩解码器解决了解缠注意力对绝对位置信息的忽略,提高了模型对语境的理解。

DeBERTa的架构包括多个EMD块,每个块都使用隐藏状态和解码所需的附加信息。研究表明,包括位置到内容注意力,内容到位置注意力和EMD在内的所有组件都有助于模型的性能。还引入了尺度不变微调技术以增强模型的泛化能力。DeBERTa有三个变体,具有不同的性能指标和数据集大小。

这些创新和改进使得DeBERTa成为自然语言处理领域备受青睐的选择,不仅在数据科学家中广泛应用,还在Kaggle竞赛中取得成功,甚至在SuperGLUE基准测试中超越人类水平,为语言模型的发展留下浓墨重彩的一笔。

0000

评论列表

共(0)条相关推荐

- 0001

- 0000

- 0000

- 0000

- 0002