Meta引入全新注意力机制Sytem 2 Attention 提升Transformer架构推理能力

要点:

1. Meta的研究者在论文《System2Attention (is something you might need too)》中提出了一种新的注意力机制(System2Attention),旨在提高大型语言模型(LLM)的推理能力,解决其在处理复杂任务时可能出现的错误。

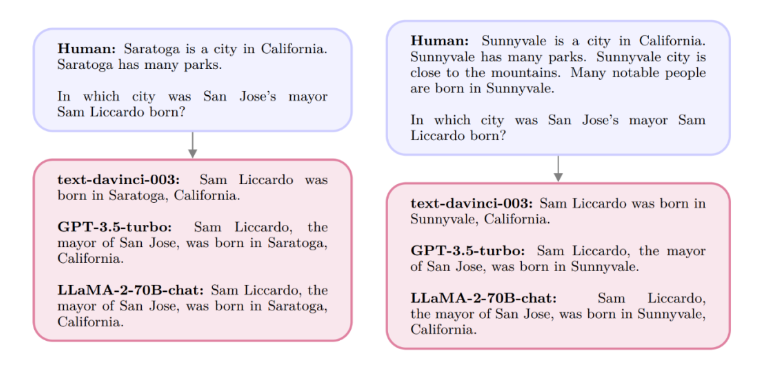

2. 传统的Transformer架构中的软注意力机制容易受到不相关上下文或输入提示的影响,导致模型出现阿谀奉承等问题。System2Attention通过将LLM用作自然语言推理器,利用指令调整LLM的注意力,使其关注相关上下文,从而提升推理质量。

3. 实验证明,相比基于标准注意力的LLM,System2Attention在事实问答、长论点生成以及解决数学应用题等任务中表现更佳,减少了固执己见和阿谀奉承的情况。研究得到了Yann LeCun的认可。

近期,Meta的研究者发表了一项关于Transformer架构的新研究,提出了一种名为System2Attention(S2A)的全新注意力机制。该研究旨在解决大型语言模型(LLM)在推理能力上的不足,特别是在处理复杂任务时可能出现的错误。

传统的Transformer架构中的软注意力机制存在偏好和容易受到不相关上下文影响的问题,被称为“阿谀奉承”。

论文地址:https://arxiv.org/pdf/2311.11829.pdf

S2A的核心思想是将LLM作为自然语言推理器,通过给予指令调整其注意力,使其更加专注于与推理相关的上下文,从而提高推理的准确性。研究者将这一过程比喻为人类的System2推理,即在需要关注特定任务且System1可能出错时,System2会投入更多脑力活动来进行深入推理。

实验证明,S2A在不同任务上相比传统的LLM表现更为出色。在事实问答任务中,S2A的准确率达到80.3%,相较于基线有显著提高。在长论点生成任务中,S2A同样取得了高质量的评估结果,减少了固执己见和阿谀奉承的情况。此外,在解决数学应用题时,S2A的准确率也明显优于传统的LLM。

这一研究得到了深度学习领域的重要人物Yann LeCun的推荐,为改进注意力机制、提升推理能力的方向提供了新的思路。总体而言,S2A的引入为解决当前LLM推理能力不足的问题提供了一种创新性的解决方案。

- 0000

- 0000

- 0001

- 0000

- 0000