英伟达提出新技术Tied-LoRA 减少模型训练参数

站长网2023-11-24 13:59:540阅

要点:

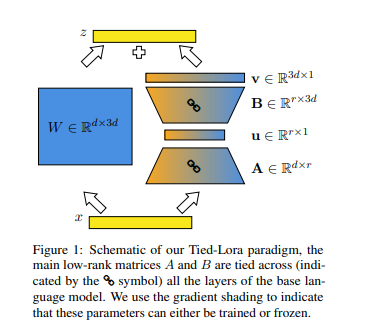

1. Nvidia的研究人员提出了一种名为Tied-LoRA的新技术,旨在改善低秩适应(LoRA)方法的参数效率。

2. Tied-LoRA利用权重绑定和选择性训练,在性能和可训练参数之间寻找最佳平衡。

3. 在对不同任务和基础语言模型进行实验后,研究人员发现在效率和性能之间存在权衡,Tied-LoRA方法可以使用比标准LoRA方法少13%的参数获得相当的性能。

近期,Nvidia的研究人员提出了一种名为Tied-LoRA的新技术,旨在改善低秩适应(LoRA)方法的参数效率。该方法通过将权重绑定和选择性训练结合起来,寻找了在性能和可训练参数之间的最佳平衡。

LoRA方法是一种提高参数效率的微调技术,通过对低秩矩阵进行逼近来减少可训练参数。Tied-LoRA方法通过将权重绑定应用于LoRA中的低秩矩阵,跨基础语言模型的层共享相同的权重,从而减少可训练参数的数量。

论文地址:https://arxiv.org/pdf/2311.09578.pdf

通过在不同任务和基础语言模型上进行系统实验,研究人员确定了特定的Tied-LoRA配置,相较于标准LoRA方法,仅利用13%的参数即可达到可比较的性能。在多个任务上进行的实验显示,Tied-LoRA方法在提高参数效率的同时保持了竞争性能,特定配置(vBuA)在性能上表现优异,减少了87%的参数。

Tied-LoRA是一种有效的方法,通过权重绑定和选择性训练提高了LoRA方法的参数效率,为在实践中应用AI提供了新的可能性。然而,对比其他参数效率方法、讨论局限性并确定未来探索的潜在领域仍然是重要的。

0000

评论列表

共(0)条相关推荐

- 0001

- 0000

- 0000

- 0000

- 0000